De wereld staat op het punt te worden overspoeld door kunstmatige-intelligentiesoftware die in een sticker op een lantaarnpaal zou kunnen zitten.

Wat TinyML wordt genoemd, een brede beweging om machine learning-vormen van AI te schrijven die kunnen worden uitgevoerd op apparaten met een zeer laag vermogen, krijgt nu een eigen reeks benchmarktests voor prestaties en stroomverbruik.

De test, MLPerf, is de oprichting van de MLCommons, een industrieconsortium dat al jaarlijkse benchmarkevaluaties van computers uitgeeft voor de twee delen van machine learning, de zogenaamde training, waarbij een neuraal netwerk wordt gebouwd door de instellingen ervan te verfijnen in meerdere experimenten ; en zogenaamde inferentie, waarbij het voltooide neurale netwerk voorspellingen doet wanneer het nieuwe gegevens ontvangt.

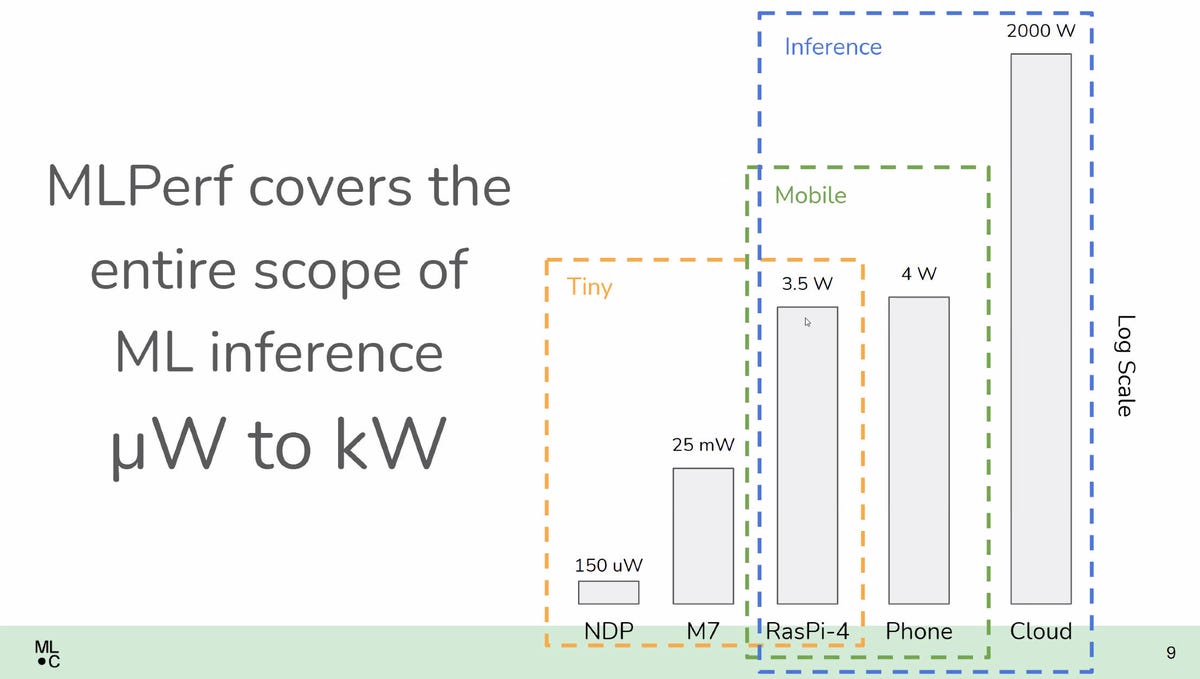

Die benchmarktests waren echter gericht op conventionele computerapparatuur, variërend van laptops tot supercomputers. MLPerf Tiny Inference, zoals het nieuwe examen wordt genoemd, richt zich op de nieuwe grens van dingen die op smartphones draaien, tot dingen die zo dun kunnen zijn als een postzegel, zonder helemaal geen batterij.

De referentie-implementatie voor MLPerf Tiny Inference test hoeveel latentie wordt veroorzaakt en hoeveel energie wordt verbruikt door vier representatieve machine learning-taken uit te voeren op een ST MIcroelectronics Nucleo ARM-gebaseerde microcontrollerkaart voor embedded systemen.

“Dit voltooit het benchmarkspectrum van microwatt tot megawatt”, zei David Kanter, uitvoerend directeur van MLCommons, het industrieconsortium dat toezicht houdt op MLPerf, in een briefing met de pers.

Ook: De prestatiebenchmark van de AI-industrie, MLPerf, meet voor het eerst ook de energie die machine learning verbruikt

De tests meten de latentie in milliseconden en het stroomverbruik in micro-Jules, om vier representatieve machine learning te voltooien taken, waarbij lager in beide gevallen beter is. Het is de tweede keer dat ML Commons een energiemeting introduceert. In april introduceerde de groep een meting van het gebruikte wisselstroomvermogen, in watt, in de bestaande MLPerf Inference-test.

TinyML vertegenwoordigt redelijk taken die bekend zijn bij velen die mobiele apparaten gebruiken, dingen zoals het wake-word dat een telefoon activeert, zoals “Hey, Google” of “Hey, Siri”. (De directeur vertrouwde het publiek grinnikend toe dat hij en zijn collega's “Hey, Google” op kantoor moeten noemen als “Hey, G”, om te voorkomen dat elkaars telefoons constant afgaan.)

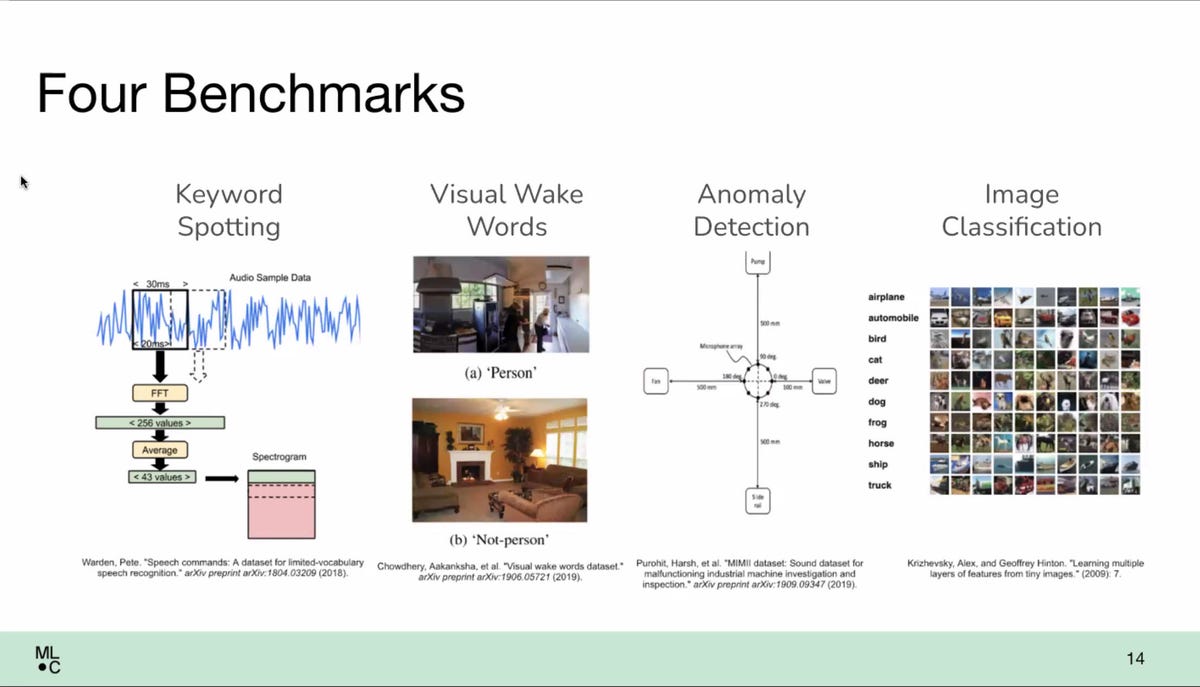

In dit geval omvatten de vier taken het spotten van trefwoorden, maar ook drie andere: zogenaamde visuele wake-woorden, waarbij een object in een gezichtsveld enige activiteit veroorzaakt (denk aan videodeurbel); beeldclassificatie op de veelgebruikte CIFAR-10 dataset; en anomaliedetectie, een visueel inspectiesysteem dat op een fabrieksvloer kan worden gebruikt.

De benchmark is gemaakt door een referentie-implementatie, waarbij die vier taken worden uitgevoerd op een klein ingebed computerbord, de Nucleo-L4R5ZI van ST Microelectronics, waarop een ARM Cortex-M4 ingebedde processor draait.

De Nucleo wordt door ML Commons geacht voldoende breed te worden gebruikt om apparaten met een zeer laag vermogen te vertegenwoordigen. De Nucleo draaide Google's softwaresysteem voor TinyML, genaamd TensorFlow Lite, in dit geval een versie speciaal ontworpen voor microcontrollers.

Vier groepen dienden hun resultaten in bij de benchmark: Syntiant, een in Irvine, Californië gevestigde ontwerper van AI-processors; LatentAI, een in Menlo Park, Californië gevestigde spin-out van onderzoeksinstituut SRI International dat een SDK voor ontwikkelaar maakt voor AI; Peng Cheng Laboratory, een onderzoekslaboratorium in Shenzen, China; en hls4ml, een verzameling onderzoekers van Fermilab, Columbia University, UC San Diego en CERN.

Syntiant voerde de benchmark uit op een ARM Cortex-M0-processor, terwijl LatentAI een Raspberry Pi 4-systeem met een Broardcom-chip gebruikte en hls4ml een Xilinx-processor op een Pynq-Z2-ontwikkelingsbord gebruikte.

Misschien wel de meest interessante inzending vanuit hardwarestandpunt was de aangepaste processor van Peng Cheng Laboratory, die het ontwierp en die werd gefabriceerd door Semiconductor Manufacturing International in China. Dat deel voert de open RISC-V-instructieset uit, een project van de University of California in Berkeley dat steeds meer steun krijgt als alternatief voor ARM-chipinstructies.

Een formeel document met een beschrijving van de benchmark is beschikbaar om te downloaden op OpenReview.net, geschreven door twee van de academische adviseurs van de organisatie, Colby Banbury en Vijay Janapa Reddi van Harvard University, samen met meerdere bijdragende auteurs. Die paper is dit jaar voorgelegd aan de NeurIPS, de grootste academische conferentie op het gebied van AI.

De benchmark is in de loop van achttien maanden gemaakt via collectieve input van werkende leden van ML Commons, waaronder vertegenwoordigers van CERN, Columbia University en UC San Diego, Google, chipmakers Infineon, Qualcomm, Silicon Labs, STMicro en Renesas, AI-startup SambaNova Systemen en chipontwerpsoftwaremaker Synopsys, onder anderen.

Reddi van Harvard zei dat het ontwerp het resultaat was van zowel stemmen door die adviseurs, maar ook van een selectieproces uit de suggesties.

“Het wordt aangedreven door stemmen, maar we willen wel begrijpen wat de feedback is van consumenten of klanten”, aldus Reddi.

“Er is een element van groepsconsensus, en er is een element van haalbaarheid”, zei Kanter, waarmee hij de beperkingen oplost van welke datasets in de praktijk kunnen worden gebruikt voor tests. “Als je niet evalueert op een echte dataset, krijg je geen superbetekenisvolle resultaten”, zei hij. Datasets zoals CIFAR-10 zorgen ervoor dat de resultaten “vergelijkbaar en goed worden herkend”, voegde hij eraan toe.

“Dat is een poortfactor”, zei Kanter over het datasetprobleem. “Er zijn veel applicaties waarvan we graag de prestaties zouden willen meten, maar uiteindelijk kijk je een beetje naar de beschikbare bronnen, vooral omdat dit een eerste poging is.”

Een van de grootste uitdagingen bij het benchmarken van TinyML is dat de softwarestack, alle coderingslagen van hardware-instructiesets tot en met de frameworks van machine learning, zoals Google's TensorFlow Lite, een veel gevarieerdere verzameling software vormen dan gewoonlijk wordt gevonden in programma's geschreven voor pc's en supercomputers in TensorFlow, PyTorch en Nvidia's CUDA-software-engine.

De tests stellen bedrijven in staat om zowel hun eigen versie van een neuraal netwerkalgoritme te gebruiken, als een standaardmodel te gebruiken, hetzelfde als alle anderen, genaamd “open” of “gesloten” benchmarkresultaten, respectievelijk.

Een extra complicatie is het definiëren van de exacte vermogensenvelop. “Het meten van het vermogen voor op batterijen gebaseerde systemen is een hele uitdaging”, merkte Kanter op. De embedded board-systemen die in de testsuite worden gebruikt, werken in een gecontroleerde testopstelling waar hun absolute runtime-vermogen voor de taken wordt “onderschept” door een vermogensmonitor die in feite de stroom levert.

“We hebben zojuist het hele batterijsubsysteem eruit gehaald”, zegt Peter Torelli, president van het Embedded Microprocessor Benchmark Consortium, een groep die al tientallen jaren de prestaties van embedded systemen meet, die werkte aan de energiecomponent van de benchmark.

Ook: Machine learning aan de rand: TinyML wordt groot

In de echte wereld is een verschillende omstandigheden zullen elk apparaat begroeten dat daadwerkelijk in een mobiele telefoon of een apparaat op de fabrieksvloer draait. Pete Warden, hoofd ontwikkeling van Google voor TinyML, heeft betoogd dat de inspanningen van TinyML zich moeten concentreren op apparaten die op batterijen werken en geen stopcontact hebben.

Warden heeft gesuggereerd dat zelfs eenvoudigere TinyML-apparaten energie kunnen oogsten, zodat ze niet eens een batterij hebben, maar eerder van hun energie zouden worden voorzien via de zon of via warmte-emitterende organismen of structuren in de buurt.

Hoewel de ML Commons in principe in overeenstemming is met Warden's opvatting dat veel TinyML-apparaten alleen batterijvoeding of energiewinning zullen hebben, omvatten de benchmarks apparaten zoals de Raspberri Pi die een wandstroombron zouden kunnen gebruiken. Met een vermogen van 3,5 watt is de Raspberri Pi een stuk groter dan de microwatt van de kleinste soorten embedded systemen.

Gezien hoe nieuw de benchmark is, zei Kanter, alleen het referentiesysteem van Reddi en Banbury van Harvard biedt feitelijk de vermogensmeting in deze eerste reeks resultaten; de vier andere indieners hebben geen vermogensmetingen verstrekt.

“We verwachten nogal wat energiemetingen te zien voor de volgende ronde”, vertelde hij ZDNet via e-mail.

Ook: Google AI-manager ziet een wereld van biljoenen apparaten los van menselijke zorg

Verwante onderwerpen:

Hardware Digitale transformatie CXO Internet of Things Innovatie Enterprise Software < img src="https://www.zdnet.com/a/hub/i/r/2018/09/04/c3df0f2d-c0dd-40e0-aac3-cf7a5effe212/thumbnail/40x40/a512fa125babb0e8085dab571e85ced1/tiernan-ray-author. jpg" class="" height="40" width="40" alt="Tiernan Ray" height="40" width="40" title="Om ultra-low power AI te meten, krijgt MLPerf een TinyML-benchmark"/>