Il mondo sta per essere inondato da un software di intelligenza artificiale che potrebbe trovarsi all'interno di un adesivo attaccato a un lampione.

Quello che viene chiamato TinyML, un ampio movimento per scrivere forme di intelligenza artificiale per l'apprendimento automatico che possono essere eseguite su dispositivi a bassissima potenza, sta ora ricevendo una propria suite di test di benchmark su prestazioni e consumo energetico.

Il test, MLPerf, è la creazione di MLCommons, un consorzio industriale che emette già valutazioni annuali di benchmark dei computer per le due parti del machine learning, il cosiddetto training, in cui viene costruita una rete neurale affinando le sue impostazioni in più esperimenti ; e la cosiddetta inferenza, in cui la rete neurale finita fa previsioni quando riceve nuovi dati.

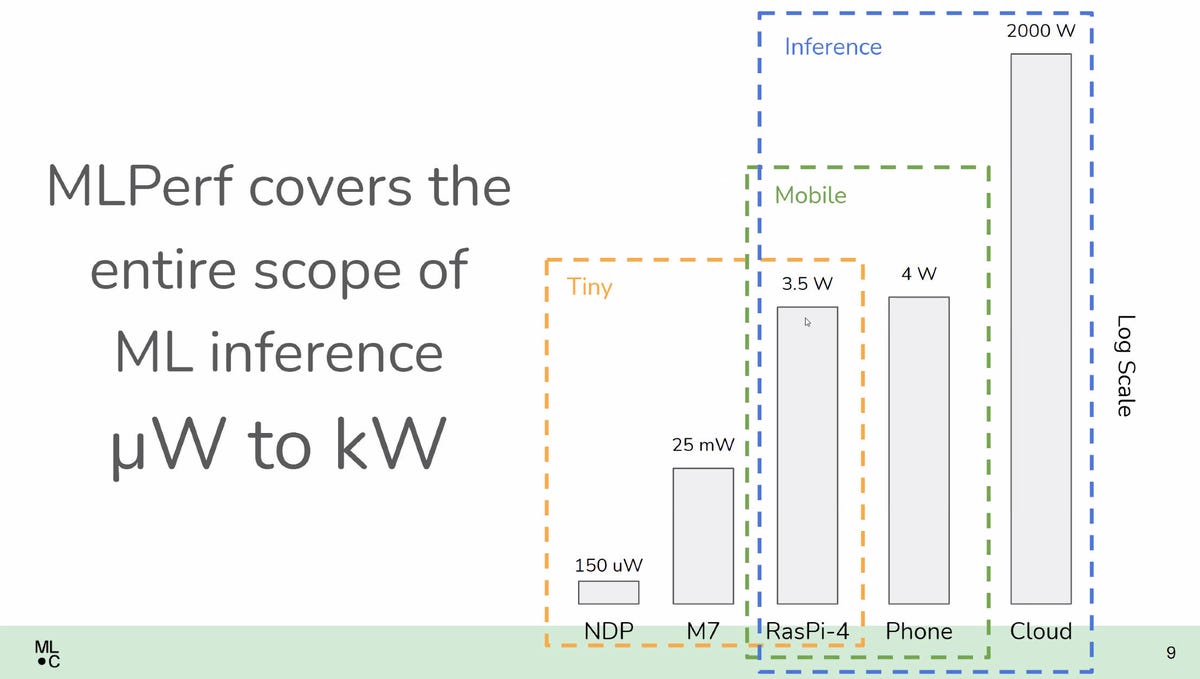

Questi test di benchmark, tuttavia, si sono concentrati su dispositivi di elaborazione convenzionali che vanno dai laptop ai supercomputer. MLPerf Tiny Inference, come viene chiamato il nuovo esame, si concentra sulla nuova frontiera delle cose che girano sugli smartphone fino a cose che potrebbero essere sottili come un francobollo, senza alcuna batteria.

L'implementazione di riferimento per MLPerf Tiny Inference verifica quanta latenza è sostenuta e quanta energia viene consumata eseguendo quattro attività di machine learning rappresentative su una scheda microcontrollore basata su ST MIcroelectronics Nucleo ARM per sistemi embedded.

“Questo completa lo spettro dei benchmark da micro-watt a megawatt”, ha affermato David Kanter, direttore esecutivo di MLCommons, il consorzio industriale che supervisiona MLPerf, in un briefing con la stampa.

Anche: Il benchmark delle prestazioni del settore AI, MLPerf, per la prima volta misura anche l'energia consumata dal machine learning

I test misurano la latenza in millisecondi e il consumo energetico in micro-Jules, per completare quattro machine learning rappresentativi compiti, dove minore è meglio in entrambi i casi. Questa è la seconda volta che ML Commons introduce una misurazione dell'energia. Ad aprile, il gruppo ha introdotto una misura della potenza CA utilizzata, in watt, nel test di inferenza MLPerf esistente.

TinyML rappresenta abbastanza attività familiari a molti che utilizzano dispositivi mobili, cose come la parola di attivazione che attiva un telefono, come “Ehi, Google” o “Ehi, Siri”. (Il direttore ha confidato al pubblico, con una risatina, che lui e i suoi colleghi devono fare riferimento a “Ehi, Google” in ufficio come “Ehi, G”, per non avere i telefoni degli altri che si spengono costantemente.)

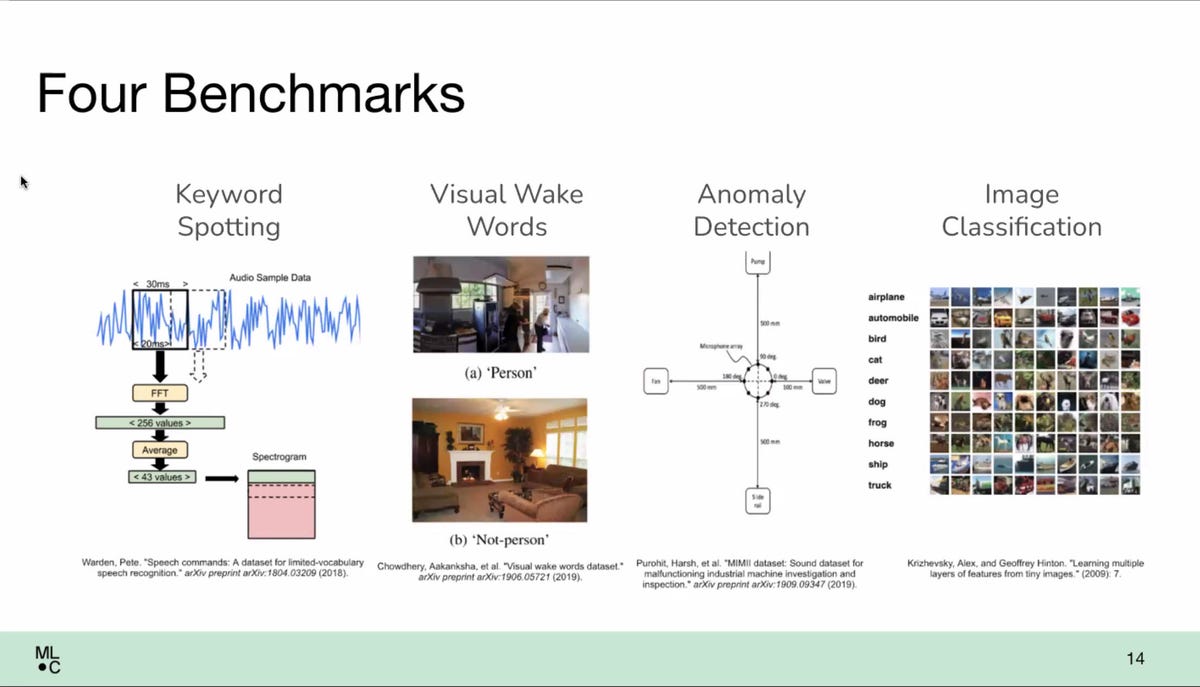

In questo caso, le quattro attività includevano l'individuazione delle parole chiave, ma anche altre tre: le cosiddette parole di riattivazione visiva, in cui un oggetto in un campo visivo attiva alcune attività (si pensi al campanello video); classificazione delle immagini sul set di dati CIFAR-10 ampiamente utilizzato; e rilevamento delle anomalie, un sistema di ispezione visiva che potrebbe essere utilizzato in una fabbrica.

Il benchmark è stato costruito un'implementazione di riferimento, in cui queste quattro attività vengono eseguite su una piccola scheda per computer embedded, il Nucleo-L4R5ZI di ST Microelectronics, che esegue un processore embedded ARM Cortex-M4.

Il Nucleo è ritenuto da ML Commons in uso sufficientemente ampio per rappresentare dispositivi a bassissima potenza. Il Nucleo gestiva il sistema software di Google per TinyML, chiamato TensorFlow Lite, in questo caso una versione appositamente progettata per i microcontrollori.

Quattro gruppi hanno presentato i loro risultati al benchmark: Syntiant, un designer di processori AI con sede a Irvine, in California; LatentAI, uno spin-out con sede a Menlo Park, California, dell'istituto di ricerca SRI International che realizza un SDK per sviluppatori per l'IA; Peng Cheng Laboratory, un laboratorio di ricerca a Shenzen, in Cina; e hls4ml, una raccolta di ricercatori del Fermilab, della Columbia University, dell'UC San Diego e del CERN.

Syntiant ha eseguito il benchmark su un processore ARM Cortex-M0, mentre LatentAI ha utilizzato un sistema Raspberry Pi 4 con un chip Broardcom e hls4ml ha utilizzato un processore Xilinx su una scheda di sviluppo Pynq-Z2.

Forse la proposta più interessante da un punto di vista hardware è stato il processore personalizzato del Peng Cheng Laboratory, che ha progettato e fabbricato dalla China Semiconductor Manufacturing International. Quella parte esegue il set di istruzioni aperto RISC-V, un progetto dell'Università della California a Berkeley che sta ottenendo un supporto crescente come alternativa alle istruzioni del chip ARM.

Un documento formale che descrive il benchmark è disponibile per il download su OpenReview.net, scritto da due dei consulenti accademici dell'organizzazione, Colby Banbury e Vijay Janapa Reddi dell'Università di Harvard, insieme a diversi autori. Quel documento è stato presentato al NeurIPS di quest'anno, la più grande conferenza accademica nel campo dell'intelligenza artificiale.

Il benchmark è stato creato nel corso di diciotto mesi grazie al contributo collettivo dei membri di lavoro di ML Commons che includono rappresentanti del CERN, della Columbia University e della UC San Diego, Google, i produttori di chip Infineon, Qualcomm, Silicon Labs, STMicro e Renesas, la startup AI SambaNova Sistemi e produttore di software di progettazione di chip Synopsys, tra gli altri.

Reddi di Harvard ha affermato che il design è stato il risultato sia del voto di quei consulenti, ma anche di un processo di selezione tra i suggerimenti.

“È guidato dal voto, ma vogliamo capire quale sia il feedback dei consumatori o dei clienti”, ha affermato Reddi.

“C'è un elemento di consenso di gruppo, e c'è un elemento di fattibilità”, ha detto Kanter, intendendo affrontare i limiti di quali set di dati possono essere utilizzati in pratica per i test. “Se non stai valutando su un set di dati reale, non otterrai risultati super-significativi”, ha detto. I set di dati come CIFAR-10 assicurano che i risultati saranno “comparabili e ben riconosciuti”, ha aggiunto.

“Questo è un fattore chiave”, ha affermato Kanter in merito al problema del set di dati. “Ci sono molte applicazioni su cui ci piacerebbe essere in grado di misurare le prestazioni, ma, alla fine, si guarda in qualche modo a quali sono le risorse disponibili, soprattutto se si tratta di uno sforzo iniziale”.

Una delle maggiori sfide del benchmarking di TinyML è che lo stack software, tutti i livelli di codifica dalle istruzioni hardware impostate attraverso i framework di machine learning, come TensorFlow Lite di Google, costituiscono una raccolta di software molto più varia di quella che si trova solitamente in programmi scritti per PC e supercomputer in TensorFlow, PyTorch e il motore software CUDA di Nvidia.

I test consentono alle aziende che si sottopongono sia di utilizzare la propria versione di un algoritmo di rete neurale, sia di utilizzare un modello standard, lo stesso di tutti gli altri, soprannominato risultati di benchmark “aperto” o “chiuso”, rispettivamente.

Un'ulteriore complicazione è definire l'esatto inviluppo di potenza. “Misurare la potenza per i sistemi a batteria è molto impegnativo”, ha osservato Kanter. I sistemi di schede embedded utilizzati nella suite di test vengono eseguiti in una configurazione di test controllata in cui la loro potenza di runtime assoluta per le attività viene “intercettata” da un monitor di alimentazione che, di fatto, fornisce l'alimentazione.

“Abbiamo appena eliminato l'intero sottosistema della batteria”, ha affermato Peter Torelli, presidente dell'Embedded Microprocessor Benchmark Consortium, un gruppo che da decenni misura le prestazioni dei sistemi embedded, che hanno lavorato sulla componente energetica del benchmark.

Anche: Apprendimento automatico all'avanguardia: TinyML sta diventando grande

Nel mondo reale, un una serie diversa di circostanze accoglierà qualsiasi dispositivo che funziona effettivamente in un telefono cellulare o in un dispositivo di fabbrica. Il capo dello sviluppo di Google per TinyML, Pete Warden, ha sostenuto che gli sforzi di TinyML dovrebbero concentrarsi su dispositivi alimentati a batteria, senza connessione alla presa a muro.

Warden ha suggerito che anche i dispositivi TinyML più semplici potrebbero utilizzare la raccolta di energia, in modo che non dispongano nemmeno di una batteria, ma che la loro energia venga fornita tramite il sole o tramite organismi o strutture che emettono calore nelle vicinanze.

Sebbene in linea di principio ML Commons sia in accordo con l'opinione di Warden secondo cui molti dispositivi TinyML avranno solo alimentazione a batteria o raccolta di energia, i benchmark includono dispositivi come Raspberri Pi che potrebbero utilizzare una fonte di alimentazione a parete. Con 3,5 watt di potenza, il Raspberri Pi è un po' più grande dei micro-watt dei più piccoli tipi di sistemi embedded.

Data la novità del benchmark, ha affermato Kanter, solo il sistema di riferimento di Reddi e Banbury ad Harvard offre effettivamente la misurazione della potenza in questa prima serie di risultati; gli altri quattro partecipanti non hanno fornito misurazioni di potenza.

“Ci aspettiamo di vedere alcune misurazioni di energia per il prossimo round”, ha detto a ZDNet via e-mail.

Inoltre: Il dirigente di Google AI vede un mondo di trilioni di dispositivi svincolati dalle cure umane

Argomenti correlati:

Hardware Digital Transformation CXO Internet of Things Innovation Enterprise Software < img src="https://www.zdnet.com/a/hub/i/r/2018/09/04/c3df0f2d-c0dd-40e0-aac3-cf7a5effe212/thumbnail/40x40/a512fa125babb0e8085dab571e85ced1/tiernan-ray-author. jpg" class="" height="40" width="40" alt="Tiernan Ray" height="40" width="40" title="Per misurare l'intelligenza artificiale a bassissima potenza, MLPerf ottiene un benchmark TinyML"/>