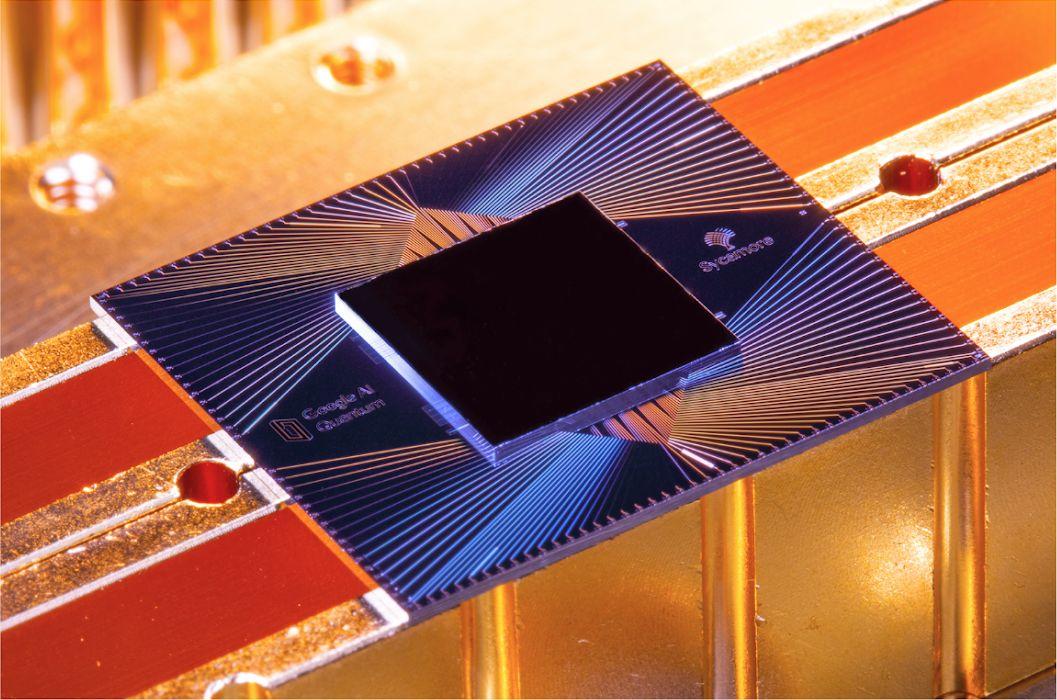

Google-Forscher haben erfolgreich haben Fehlerkorrekturmethoden mit dem Sycamore-Prozessor des Unternehmens getestet.

Die Forscher von Google haben gezeigt, dass die Fehlerkorrektur unter bestimmten Bedingungen auf dem Sycamore-Quantenprozessor des Unternehmens funktioniert und sogar exponentiell skalieren kann ist ein weiterer Schritt zum Bau eines fehlertoleranten Quantencomputers.

Der Durchbruch wird wahrscheinlich die Aufmerksamkeit von Wissenschaftlern auf sich ziehen, die an der Quantenfehlerkorrektur arbeiten, einem Gebiet, das sich nicht mit der Qubit-Zählung, sondern mit der Qubit-Qualität befasst.

Obwohl die Erhöhung der Anzahl der von Quantencomputern unterstützten Qubits oft als Schlüsselfaktor für die Erschließung der beispiellosen Rechenleistung von Quantentechnologien dargestellt wird, ist es ebenso wichtig sicherzustellen, dass sich diese Qubits zuverlässig verhalten. , fehlerfreie Ergebnisse.

Dies ist die Idee, die dem Konzept eines fehlertoleranten Quantencomputers zugrunde liegt, aber die Quantenfehlerkorrektur befindet sich noch in einem sehr frühen Stadium. Derzeit haben die Wissenschaftler aufgrund der extrem instabilen Natur der Teilchen noch Schwierigkeiten, die wenigen Qubits, mit denen sie es zu tun haben, zu kontrollieren und zu manipulieren, was bedeutet, dass Quantenberechnungen immer noch mit Fehlern gespickt sind.

Laut Google würden die meisten Anwendungen Fehlerraten von nur 10^-15 verlangen; Im Vergleich dazu weisen moderne Quantenplattformen derzeit durchschnittliche Fehlerraten auf, die näher bei 10^-3 liegen.

Eine Lösung besteht darin, die physikalische Stabilität von Qubits zu verbessern, aber Wissenschaftler priorisieren zunehmend einen alternativen Workaround-Ansatz, bei dem Fehler direkt im Quantenprozessor erkannt und korrigiert werden können.

Typischerweise geschieht dies, indem Quantendaten auf viele verschiedene Qubits verteilt und zusätzliche Qubits verwendet werden, um diese Informationen zu verfolgen und Fehler zu identifizieren und zu korrigieren. Die gesamte fehlerkorrigierte Gruppe von Qubits bildet einen einzigen Cluster, der als “logisches Qubit” bekannt ist.

Dieser Ansatz, auch Stabilizer-Code genannt, verschränkt im Wesentlichen Daten-Qubits mit Mess-Qubits, die unerwünschte Störungen der Daten-Qubit-Zustände in Fehler verwandeln können, die dann dank spezieller Software kompensiert werden können.

Während die Prinzipien von Stabilisatorcodes theoretisch auf verschiedene Plattformen angewendet wurden, hat sich die Methode laut Google weder als skalierbar in großen Systemen erwiesen, noch hat sie gezeigt, dass sie mehreren Runden der Fehlerkorrektur standhält.

Die Forscher des Werberiesen testeten Stabilisatorcodes mit dem Sycamore-Quantenprozessor des Unternehmens, beginnend mit einem logischen Qubit-Cluster aus fünf Qubits, die in einer eindimensionalen Kette verbunden sind. Die Qubits dienten abwechselnd als Daten-Qubits und Mess-Qubits mit der Aufgabe, Fehler zu erkennen.

Mit zunehmender Größe des Clusters, fanden die Forscher, verringerten sich die Fehler exponentiell. Das Team testete die Methode mit verschiedenen Größen von logischen Qubits und erreichte einen maximalen Cluster von 21 Qubits, was logische Fehler um mehr als das 100-fache im Vergleich zu Clustern aus nur fünf Qubits reduzierte. Mit anderen Worten, je größer das logische Qubit, desto besser können Fehler korrigiert werden.

Dies ist wichtig, da von praktischen Quantencomputern erwartet wird, dass sie für jedes logische Qubit mindestens 1.000 Fehlerkorrektur-Qubits benötigen. Der Nachweis, dass Fehlerkorrekturmethoden skalierbar sind, ist daher von grundlegender Bedeutung für die Entwicklung eines nützlichen Quantencomputers.

Google fand auch heraus, dass die Fehlerunterdrückungsrate auch nach 50 Runden Fehlerkorrektur stabil blieb – eine “Schlüsselerkenntnis” für die Machbarkeit der Quantenfehlerkorrektur, so das Unternehmen.

Natürlich unterliegt das Experiment immer noch großen Einschränkungen. Aktuelle Quantencomputer können weniger als 100 Qubits unterstützen – Sycamore beispielsweise hat 54 Qubits –, sodass es unmöglich ist, die Methode mit den 1.000 Qubits zu testen, die für praktische Anwendungen notwendig wären.

Und selbst wenn 21 Qubits ausreichen würden, um ein nützliches logisches Qubit zu erstellen, könnte der Prozessor von Google nur zwei dieser logischen Qubits unterstützen, was für reale Anwendungen noch lange nicht ausreicht. Die Ergebnisse von Google bleiben daher vorerst ein Proof-of-Concept.

Darüber hinaus hoben die Wissenschaftler hervor, dass die inhärent hohen Fehlerraten von Qubits wahrscheinlich problematisch werden könnten. In den Experimenten des Teams haben 11 % der Überprüfungen einen Fehler entdeckt, was bedeutet, dass Fehlerkorrekturtechnologien unglaublich effizient sein müssen, um jede Störung in Geräten mit mehreren tausend Mal mehr Qubits zu erkennen und zu korrigieren.

“Diese experimentellen Demonstrationen bieten eine Grundlage für den Bau eines skalierbaren fehlertoleranten Quantencomputers mit supraleitenden Qubits”, so die Forscher. “Dennoch bleiben viele Herausforderungen auf dem Weg zur skalierbaren Quantenfehlerkorrektur.”

Es bleibt, dass die Ergebnisse von Google die Tür zu mehr Forschung und Experimenten in einem immer geschäftigeren Feld geöffnet haben.

Anfang dieses Jahres hat beispielsweise Amazons Cloud-Tochter AWS ihr erstes Forschungspapier veröffentlicht, in dem eine neue Architektur für einen Quantencomputer detailliert beschrieben wird, mit dem Ziel, einen neuen Standard für die Fehlerkorrektur zu setzen.

Die Methode von AWS basiert auf einem ähnlichen Ansatz wie die von Google, ist jedoch mit einem Prozessordesign gekoppelt, das das Potenzial von Qubits auf Flip-States reduzieren könnte, was als Blaupause für einen genaueren Quantencomputer vorgeschlagen wurde.

Ähnliche Themen:

Google ![]()