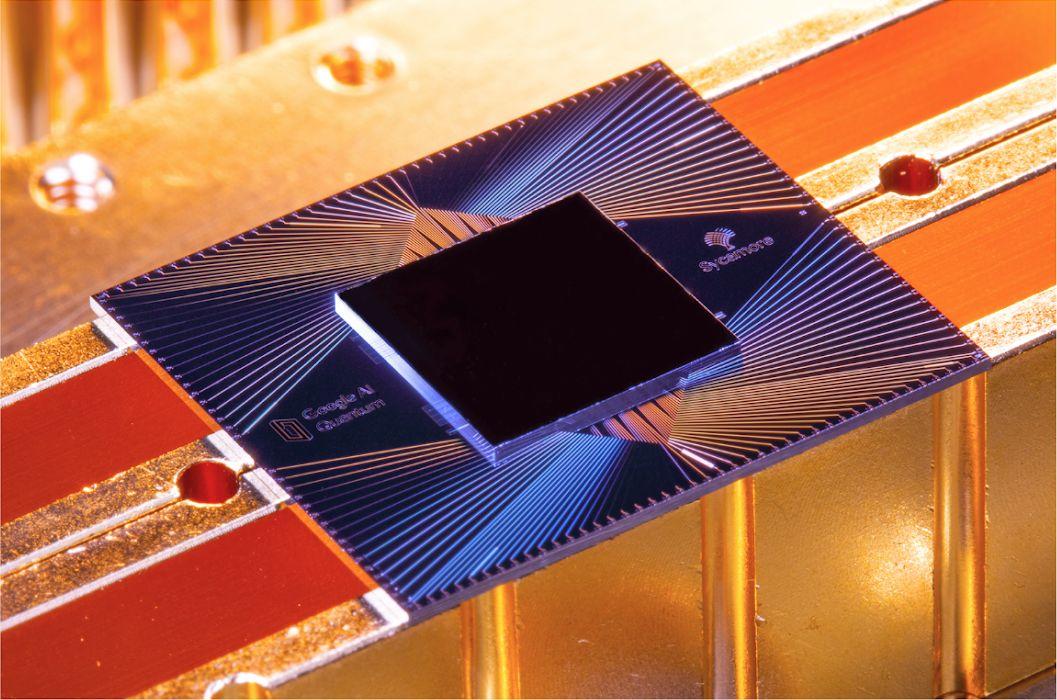

I ricercatori di Google hanno avuto successo metodi di correzione degli errori testati con il processore Sycamore dell'azienda.

I ricercatori di Google hanno dimostrato che, a determinate condizioni, la correzione degli errori funziona sul processore quantistico Sycamore dell'azienda e può persino scalare in modo esponenziale, in quanto è ancora un altro passo verso la costruzione di un computer quantistico tollerante ai guasti.

È probabile che la svolta attiri l'attenzione degli scienziati che lavorano sulla correzione degli errori quantistici, un campo che non riguarda il conteggio dei qubit ma piuttosto la qualità dei qubit.

Anche se l'aumento del numero di qubit supportati dai computer quantistici viene spesso presentato come il fattore chiave per sbloccare la potenza di calcolo senza precedenti delle tecnologie quantistiche, altrettanto importante è garantire che tali qubit si comportino in modo da consentire un'affidabilità , risultati privi di errori.

Questa è l'idea alla base del concetto di computer quantistico tollerante ai guasti, ma la correzione degli errori quantistici è ancora in una fase iniziale. Per ora, gli scienziati stanno ancora lottando per controllare e manipolare i pochi qubit con cui hanno a che fare, a causa della natura estremamente instabile delle particelle, il che significa che i calcoli quantistici sono ancora pieni di errori.

Secondo Google, la maggior parte delle applicazioni richiederebbe tassi di errore a partire da 10^-15; in confronto, le piattaforme quantistiche all'avanguardia hanno attualmente tassi di errore medi che si avvicinano a 10^-3.

Una soluzione consiste nel migliorare la stabilità fisica dei qubit, ma gli scienziati stanno dando sempre più priorità a un approccio alternativo, in cui gli errori possono essere rilevati e corretti direttamente all'interno del processore quantistico.

In genere, ciò viene fatto distribuendo i dati quantistici su molti qubit diversi e utilizzando qubit aggiuntivi per tenere traccia di tali informazioni, identificando e correggendo gli errori man mano che si verificano. Il gruppo complessivo di qubit corretto per gli errori forma un singolo cluster noto come “qubit logico”.

Denominato codice stabilizzatore, questo approccio essenzialmente interlaccia i qubit di dati con i qubit di misura che possono trasformare in errori indesiderate perturbazioni degli stati dei qubit di dati, che possono poi essere compensati grazie a software specifici.

Sebbene i principi dei codici stabilizzatori siano stati teoricamente applicati a diverse piattaforme, ha affermato Google, non è stato dimostrato che il metodo sia scalabile in sistemi di grandi dimensioni, né è stato dimostrato che resista a diversi cicli di correzione degli errori.

I ricercatori del gigante della pubblicità hanno deciso di testare i codici stabilizzatori con il processore quantistico Sycamore dell'azienda, partendo da un cluster logico di qubit composto da cinque qubit collegati in una catena unidimensionale. I qubit si alternavano tra la funzione di qubit di dati e i qubit di misurazione incaricati di rilevare gli errori.

Aumentando la dimensione del cluster, hanno scoperto i ricercatori, l'errore si riduce in modo esponenziale. Il team ha testato il metodo con varie dimensioni di qubit logici, raggiungendo un cluster massimo di 21 qubit, che è risultato ridurre l'errore logico di oltre 100 volte rispetto ai cluster composti da soli cinque qubit. In altre parole, maggiore è il qubit logico, migliori sono gli errori che possono essere corretti.

Questo è importante perché si prevede che i computer quantistici pratici richiedano almeno 1.000 qubit di correzione degli errori per ogni qubit logico. Dimostrare che i metodi di correzione degli errori possono scalare, quindi, è fondamentale per lo sviluppo di un computer quantistico utile.

Google ha anche scoperto che il tasso di soppressione degli errori è rimasto stabile anche dopo 50 cicli di correzione degli errori, una “rilevazione chiave” per la fattibilità della correzione degli errori quantistici, ha affermato la società.

Naturalmente, ci sono ancora enormi limitazioni all'esperimento. Gli attuali computer quantistici possono supportare meno di 100 qubit – Sycamore, ad esempio, ha 54 qubit – il che significa che è impossibile testare il metodo con i 1.000 qubit che sarebbero necessari per le applicazioni pratiche.

E anche se 21 qubit fossero sufficienti per creare un utile qubit logico, il processore di Google sarebbe in grado di supportare solo due di quei qubit logici, che sono ancora lontani dall'essere sufficienti per essere utilizzati nelle applicazioni della vita reale. I risultati di Google, quindi, restano per ora un proof-of-concept.

Inoltre, gli scienziati hanno evidenziato che è probabile che i tassi di errore intrinsecamente elevati dei qubit diventino problematici. Negli esperimenti del team, l'11% dei controlli ha rilevato un errore, il che significa che le tecnologie di correzione degli errori dovranno essere incredibilmente efficienti per rilevare e correggere ogni perturbazione nei dispositivi che hanno diverse migliaia di volte più qubit.

“Queste dimostrazioni sperimentali forniscono le basi per la costruzione di un computer quantistico scalabile tollerante ai guasti con qubit superconduttori”, hanno affermato i ricercatori. “Tuttavia, rimangono molte sfide sulla strada verso la correzione degli errori quantistica scalabile”.

Resta che le scoperte di Google hanno aperto la porta a ulteriori ricerche e sperimentazioni in un campo sempre più impegnato.

All'inizio di quest'anno, ad esempio, la consociata cloud di Amazon, AWS, ha pubblicato il suo primo documento di ricerca che descrive in dettaglio una nuova architettura per un computer quantistico con l'obiettivo di stabilire un nuovo standard per la correzione degli errori.

Il metodo di AWS si basa su un approccio simile a quello di Google, ma è abbinato a un design del processore che potrebbe ridurre il potenziale dei qubit di capovolgere gli stati, in quello che è stato presentato come un progetto per un computer quantistico più preciso.

Argomenti correlati:

Google