![]()

Aan de slag met kunstmatige intelligentie en machine learning Nu bekijken

Aan de slag met kunstmatige intelligentie en machine learning Nu bekijken

Wat is kunstmatige intelligentie (AI)?

Het hangt ervan af aan wie je het vraagt.

In de jaren vijftig beschreven de grondleggers van het vakgebied, Minsky en McCarthy, kunstmatige intelligentie als elke taak die door een machine wordt uitgevoerd en waarvoor voorheen menselijke intelligentie nodig was.

Dat is duidelijk een vrij brede definitie, daarom zie je soms ruzies over de vraag of iets echt AI is of niet.

Moderne definities van wat het betekent om intelligentie te creëren zijn specifieker. Francois Chollet, een AI-onderzoeker bij Google en maker van de machine-learning softwarebibliotheek Keras, heeft gezegd dat intelligentie gekoppeld is aan het vermogen van een systeem om zich aan te passen en te improviseren in een nieuwe omgeving, om zijn kennis te generaliseren en toe te passen op onbekende scenario's.

“Intelligentie is de efficiëntie waarmee je nieuwe vaardigheden verwerft bij taken waar je je voorheen niet op voorbereidde,” zei hij.

“Intelligentie is geen vaardigheid op zich; het is niet wat je kunt doen ; het is hoe goed en hoe efficiënt je nieuwe dingen kunt leren.”

Het is een definitie waaronder moderne AI-aangedreven systemen, zoals virtuele assistenten, zouden worden gekarakteriseerd als 'smalle AI', het vermogen om hun training te generaliseren bij het uitvoeren van een beperkt aantal taken, zoals spraakherkenning of computervisie.

Gewoonlijk vertonen KI-systemen ten minste enkele van de volgende gedragingen die verband houden met menselijke intelligentie: plannen, leren, redeneren, probleemoplossing, kennisrepresentatie, perceptie, beweging en manipulatie en, in mindere mate, sociale intelligentie en creativiteit.

Wat zijn de toepassingen van AI?

AI is tegenwoordig alomtegenwoordig en wordt gebruikt om aan te bevelen wat u de volgende keer online moet kopen, om te begrijpen wat u zegt tegen virtuele assistenten, zoals Amazon's Alexa en Apple's Siri, om te herkennen wie en wat er op een foto staat, om spam te herkennen of om spam te detecteren. kaartfraude.

Wat zijn de verschillende soorten AI?

Op een zeer hoog niveau kan kunstmatige intelligentie worden opgesplitst in twee brede typen:

Narrow AI

Smalle AI is wat we tegenwoordig overal om ons heen in computers zien – intelligente systemen die hebben geleerd of hebben geleerd specifieke taken uit te voeren zonder expliciet te zijn geprogrammeerd hoe ze dat moeten doen.

Dit type machine-intelligentie is duidelijk zichtbaar in de spraak- en taalherkenning van de virtuele Siri-assistent op de Apple iPhone, in de zichtherkenningssystemen op zelfrijdende auto's, of in de aanbevelingsengines die producten voorstellen die je misschien leuk vindt op basis van wat je in het verleden hebt gekocht. In tegenstelling tot mensen kunnen deze systemen alleen leren of leren hoe ze gedefinieerde taken moeten uitvoeren, daarom worden ze smalle AI genoemd.

Algemene AI

Algemene AI is heel anders en is het type aanpasbare intellect dat bij mensen wordt aangetroffen, een flexibele vorm van intelligentie die in staat is om te leren hoe enorm verschillende taken moeten worden uitgevoerd, van het knippen van haar tot het maken van spreadsheets of redeneren over een breed scala aan onderwerpen op basis van op zijn opgebouwde ervaring.

Dit is het soort AI dat vaker wordt gezien in films, zoals HAL in 2001 of Skynet in The Terminator, maar die vandaag niet bestaat – en AI-experts zijn fel verdeeld over hoe snel het werkelijkheid zal worden.

Wat kan Narrow AI doen?

Er zijn een groot aantal opkomende toepassingen voor smalle AI:

Interpretatie van videofeeds van drones die visuele inspecties uitvoeren van infrastructuur zoals oliepijpleidingen.Organiseren van persoonlijke en zakelijke agenda's.Reageren op eenvoudige vragen van de klantenservice.Coördinatie met andere intelligente systemen om taken uit te voeren zoals het boeken van een hotel op een geschikte tijd en locatie. Radiologen helpen potentiële tumoren op röntgenfoto's te herkennen.Ongepaste inhoud online markeren, slijtage in liften detecteren op basis van gegevens die zijn verzameld door IoT-apparaten.Een 3D-model van de wereld genereren op basis van satellietbeelden… de lijst gaat maar door.< p>Er ontstaan voortdurend nieuwe toepassingen van deze leersystemen. Ontwerper van grafische kaarten Nvidia heeft onlangs een op AI gebaseerd systeem Maxine onthuld, waarmee mensen videogesprekken van goede kwaliteit kunnen voeren, bijna ongeacht de snelheid van hun internetverbinding. Het systeem vermindert de bandbreedte die nodig is voor dergelijke oproepen met een factor 10 door niet de volledige videostream via internet te verzenden en in plaats van een klein aantal statische beelden van de beller te animeren op een manier die is ontworpen om de gezichtsuitdrukkingen en bewegingen van de beller in realtime en niet te onderscheiden van de video.

Maar hoeveel onbenut potentieel deze systemen ook hebben, soms overtreffen de ambities voor de technologie de realiteit. Een voorbeeld hiervan zijn zelfrijdende auto's, die zelf worden ondersteund door AI-aangedreven systemen zoals computer vision. Elektrisch autobedrijf Tesla loopt enigszins achter op de oorspronkelijke tijdlijn van CEO Elon Musk voor het opwaarderen van het Autopilot-systeem van de auto naar “volledig zelfrijdend” van de beperktere ondersteunende rijmogelijkheden van het systeem, met de optie Volledig zelfrijdend pas onlangs uitgerold naar een selecte groep deskundige chauffeurs als onderdeel van een bètatestprogramma.

Wat kan General AI doen?

Een onderzoek uitgevoerd onder vier groepen experts in 2012/13 door AI-onderzoekers Vincent C Müller en filosoof Nick Bostrom meldde een kans van 50% dat kunstmatige algemene intelligentie (AGI) tussen 2040 en 2050 zou worden ontwikkeld, oplopend tot 90% in 2075. groep ging zelfs nog verder en voorspelde dat de zogenaamde 'superintelligentie' – die Bostrom definieert als “elk intellect dat de cognitieve prestaties van mensen in vrijwel alle interessegebieden ver overtreft” – ongeveer 30 jaar na het bereiken van AGI werd verwacht.

Recente beoordelingen door AI-experts zijn echter voorzichtiger. Pioniers op het gebied van modern AI-onderzoek, zoals Geoffrey Hinton, Demis Hassabis en Yann LeCun, zeggen dat de samenleving nog lang niet in de buurt is van de ontwikkeling van AGI. Gezien de scepsis van de voorlopers op het gebied van moderne AI en de heel andere aard van moderne smalle AI-systemen dan AGI, is er misschien weinig reden om te vrezen dat een algemene kunstmatige intelligentie de samenleving in de nabije toekomst zal ontwrichten.

< p>Dat gezegd hebbende, zijn sommige AI-experts van mening dat dergelijke projecties enorm optimistisch zijn gezien ons beperkte begrip van het menselijk brein en geloven ze dat AGI nog eeuwen verwijderd is.

Wat zijn recente mijlpalen in de ontwikkeling van AI?

Hoewel moderne, smalle AI beperkt kan zijn tot het uitvoeren van specifieke taken, zijn deze systemen binnen hun specialismen soms in staat tot bovenmenselijke prestaties , in sommige gevallen zelfs van superieure creativiteit, een eigenschap die vaak als intrinsiek menselijk wordt beschouwd.

Er zijn te veel doorbraken geweest om een definitieve lijst samen te stellen, maar enkele hoogtepunten zijn:

In 2009 toonde Google aan dat zijn zelfrijdende Toyota Prius meer dan 10 ritten van elk 100 mijl kon afleggen, waardoor de samenleving op weg was naar auto's zonder bestuurder. In 2011 haalde het computersysteem IBM Watson de krantenkoppen over de hele wereld toen het de Amerikaanse quizshow Jeopardy! won. , het verslaan van twee van de beste spelers die de show ooit had voortgebracht. Om de show te winnen, gebruikte Watson natuurlijke taalverwerking en analyses op enorme opslagplaatsen van gegevens die worden verwerkt om door mensen gestelde vragen te beantwoorden, vaak in een fractie van een seconde. In 2012 luidde een andere doorbraak het potentieel van AI in om een groot aantal nieuwe taken aan te pakken voorheen beschouwd als te complex voor welke machine dan ook. Dat jaar zegevierde het AlexNet-systeem beslissend in de ImageNet Large Scale Visual Recognition Challenge. De nauwkeurigheid van AlexNet was zodanig dat het foutenpercentage halveerde in vergelijking met concurrerende systemen in de wedstrijd voor beeldherkenning.

De prestaties van AlexNet demonstreerden de kracht van leersystemen op basis van neurale netwerken, een model voor machinaal leren dat al tientallen jaren bestond, maar dat eindelijk zijn potentieel realiseerde dankzij verfijningen in de architectuur en sprongen in parallelle verwerkingskracht die mogelijk werden gemaakt door de wet van Moore. De bekwaamheid van machine learning-systemen bij het uitvoeren van computervisie haalde dat jaar ook de krantenkoppen, toen Google een systeem trainde om een internetfavoriet te herkennen: foto's van katten.

De volgende demonstratie van de doeltreffendheid van machine learning-systemen die de aandacht van het publiek trok, was de triomf van de Google DeepMind AlphaGo AI in 2016 over een menselijke grootmeester in Go, een oud Chinees spel waarvan de complexiteit de computers decennialang overrompelde. Go heeft ongeveer 200 zetten per beurt in vergelijking met ongeveer 20 bij schaken. In de loop van een Go-spel zijn er zoveel mogelijke zetten die elk van tevoren moeten doorzoeken om het beste spel te identificeren, vanuit een computationeel oogpunt te duur. In plaats daarvan werd AlphaGo getraind in het spelen van het spel door bewegingen van menselijke experts te nemen in 30 miljoen Go-spellen en deze in diepgaande neurale netwerken te voeren.

Het trainen van deze deep learning-netwerken kan erg lang duren, waarbij enorme hoeveelheden gegevens moeten worden opgenomen en herhaald, aangezien het systeem zijn model geleidelijk verfijnt om het beste resultaat te bereiken.

Echter, meer recentelijk, Google verfijnde het trainingsproces met AlphaGo Zero, een systeem dat “volledig willekeurige” spelletjes tegen zichzelf speelde en er vervolgens van leerde. Demis Hassabis, CEO van Google DeepMind, heeft ook een nieuwe versie van AlphaGo Zero onthuld die de spellen schaken en shogi onder de knie heeft.

En AI blijft sprinten langs nieuwe mijlpalen: een systeem dat is getraind door OpenAI heeft de beste spelers ter wereld verslagen in één-op-één-wedstrijden van de online multiplayer-game Dota 2.

Datzelfde jaar won OpenAI hebben AI-agenten gemaakt die hun eigen taal hebben uitgevonden om samen te werken en hun doel effectiever te bereiken, gevolgd door Facebook-agenten die agenten trainen om te onderhandelen en te liegen.

2020 was het jaar waarin een AI-systeem schijnbaar het vermogen kreeg om als een mens te schrijven en te praten over bijna elk onderwerp dat je maar kunt bedenken.

Het systeem in kwestie, bekend als Generative Pre-trained Transformer 3 of GPT-3, kortweg, is een neuraal netwerk dat is getraind op miljarden Engelstalige artikelen die beschikbaar zijn op het open web.

Al snel nadat het beschikbaar was gesteld voor testen door de non-profitorganisatie OpenAI, bruiste het internet van het vermogen van GPT-3 om artikelen te genereren over bijna elk onderwerp dat eraan werd voorgelegd, artikelen die op het eerste gezicht vaak moeilijk te onderscheiden van die welke door een mens zijn geschreven. Evenzo volgden indrukwekkende resultaten op andere gebieden, met het vermogen om overtuigende vragen over een breed scala aan onderwerpen te beantwoorden en zelfs door te gaan voor een beginnende JavaScript-coder.

Maar hoewel veel door GPT-3 gegenereerde artikelen een air van waarheidsgetrouwheid, bleek uit verdere tests dat de gegenereerde zinnen vaak niet door de beugel konden, en dat ze oppervlakkig plausibele maar verwarde uitspraken opleverden, evenals soms regelrechte onzin.

Er is nog steeds veel belangstelling voor het gebruik van het natuurlijke taalbegrip van het model als basis voor toekomstige services. Het is beschikbaar om ontwikkelaars te selecteren om in software in te bouwen via de bèta-API van OpenAI. Het zal ook worden opgenomen in toekomstige services die beschikbaar zijn via het Azure-cloudplatform van Microsoft.

Misschien kwam het meest opvallende voorbeeld van het potentieel van AI eind 2020, toen het op aandacht gebaseerde neurale netwerk AlphaFold 2 van Google een resultaat liet zien dat sommigen noemden een Nobelprijs voor Scheikunde waardig.

Het vermogen van het systeem om naar de bouwstenen van een eiwit, ook wel aminozuren genoemd, te kijken en de 3D-structuur van dat eiwit af te leiden, zou een grote invloed kunnen hebben op de snelheid waarmee ziekten worden begrepen en medicijnen worden ontwikkeld. In de Critical Assessment of Protein Structure Prediction-wedstrijd heeft AlphaFold 2 de 3D-structuur van een eiwit bepaald met een nauwkeurigheid die wedijvert met kristallografie, de gouden standaard voor het overtuigend modelleren van eiwitten.

In tegenstelling tot kristallografie, waarvoor maanden nodig zijn om resultaten terug te geven, kan AlphaFold 2 eiwitten in uren modelleren. Omdat de 3D-structuur van eiwitten zo'n belangrijke rol speelt in de menselijke biologie en ziekte, is een dergelijke versnelling aangekondigd als een baanbrekende doorbraak voor de medische wetenschap, om nog maar te zwijgen van mogelijke toepassingen in andere gebieden waar enzymen worden gebruikt in de biotechnologie.

Wat is machine learning?

Vrijwel alle tot nu toe genoemde prestaties kwamen voort uit machine learning, een subset van AI die verantwoordelijk is voor de overgrote meerderheid van de prestaties in het veld in de afgelopen jaren. Als mensen het tegenwoordig over AI hebben, hebben ze het over het algemeen over machine learning.

Momenteel genieten van iets van een heropleving, in eenvoudige bewoordingen, is machine learning waar een computersysteem leert hoe een taak uit te voeren in plaats van te worden geprogrammeerd hoe het moet. Deze beschrijving van machine learning gaat helemaal terug tot 1959 toen het werd bedacht door Arthur Samuel, een pionier op dit gebied die een van 's werelds eerste zelflerende systemen ontwikkelde, het Samuel Checkers-playing Program.

Om te leren, krijgen deze systemen enorme hoeveelheden gegevens binnen, die ze vervolgens gebruiken om te leren hoe ze een specifieke taak moeten uitvoeren, zoals het verstaan van spraak of het ondertitelen van een foto. De kwaliteit en omvang van deze dataset zijn belangrijk voor het bouwen van een systeem dat zijn toegewezen taak nauwkeurig kan uitvoeren. Als u bijvoorbeeld een machine learning-systeem zou bouwen om huizenprijzen te voorspellen, zouden de trainingsgegevens meer moeten bevatten dan alleen de grootte van het onroerend goed, maar ook andere opvallende factoren, zoals het aantal slaapkamers of de grootte van de tuin.

Wat zijn neurale netwerken?

De sleutel tot het succes van machine learning zijn neurale netwerken. Deze wiskundige modellen zijn in staat om interne parameters aan te passen om de output te veranderen. Een neuraal netwerk wordt gevoed met datasets die het leren wat het moet uitspugen wanneer het tijdens de training bepaalde gegevens krijgt aangeboden. Concreet zou het netwerk grijswaardenafbeeldingen kunnen krijgen van de getallen tussen nul en 9, naast een reeks binaire cijfers – nullen en enen – die aangeven welk getal in elke grijsschaalafbeelding wordt weergegeven. Het netwerk zou dan worden getraind en de interne parameters aanpassen totdat het het aantal in elke afbeelding met een hoge mate van nauwkeurigheid classificeert. Dit getrainde neurale netwerk zou vervolgens kunnen worden gebruikt om andere grijswaardenafbeeldingen van getallen tussen nul en 9 te classificeren. Een dergelijk netwerk werd gebruikt in een baanbrekend artikel dat de toepassing van neurale netwerken laat zien, gepubliceerd door Yann LeCun in 1989 en is gebruikt door de US Postal Service om handgeschreven postcodes te herkennen.

De structuur en werking van neurale netwerken zijn heel losjes gebaseerd op de verbindingen tussen neuronen in de hersenen. Neurale netwerken bestaan uit onderling verbonden lagen van algoritmen die gegevens met elkaar in contact brengen. Ze kunnen worden getraind om specifieke taken uit te voeren door het belang aan te passen dat aan gegevens wordt toegekend terwijl deze tussen deze lagen worden doorgegeven. Tijdens de training van deze neurale netwerken, zullen de gewichten die aan gegevens worden gehecht terwijl deze tussen de lagen passeren, blijven worden gevarieerd totdat de uitvoer van het neurale netwerk heel dicht in de buurt komt van wat gewenst is. Op dat moment heeft het netwerk 'geleerd' een bepaalde taak uit te voeren. De gewenste output kan van alles zijn, van het correct labelen van fruit in een afbeelding tot het voorspellen wanneer een lift zou kunnen falen op basis van de sensorgegevens.

Een subset van machine learning is deep learning, waarbij neurale netwerken worden uitgebreid tot uitgestrekte netwerken met een groot aantal omvangrijke lagen die worden getraind met behulp van enorme hoeveelheden gegevens. Deze diepe neurale netwerken hebben geleid tot de huidige sprong voorwaarts in het vermogen van computers om taken als spraakherkenning en computervisie uit te voeren.

Er zijn verschillende soorten neurale netwerken met verschillende sterke en zwakke punten. Recurrente neurale netwerken (RNN) zijn een type neuraal netwerk dat bijzonder geschikt is voor natuurlijke taalverwerking (NLP) – de betekenis van tekst begrijpen – en spraakherkenning, terwijl convolutionele neurale netwerken hun oorsprong hebben in beeldherkenning en uiteenlopende toepassingen hebben. als aanbevelingssystemen en NLP. Het ontwerp van neurale netwerken evolueert ook, waarbij onderzoekers een effectievere vorm van diep neuraal netwerk verfijnen, genaamd lange korte termijn geheugen of LSTM – een type RNN-architectuur die wordt gebruikt voor taken zoals NLP en voor voorspellingen van de aandelenmarkt – waardoor het kan werken snel genoeg om te worden gebruikt in on-demand systemen zoals Google Translate.

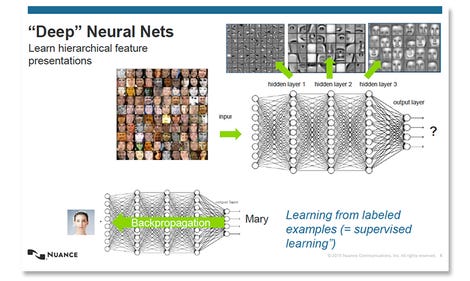

De structuur en training van diepe neurale netwerken.

Afbeelding: Nuance

Wat zijn andere soorten AI?

Een ander gebied van AI-onderzoek is evolutionaire berekening.

Het is ontleend aan Darwins theorie van natuurlijke selectie. Het ziet dat genetische algoritmen willekeurige mutaties en combinaties tussen generaties ondergaan in een poging de optimale oplossing voor een bepaald probleem te ontwikkelen.

Deze aanpak is zelfs gebruikt om AI-modellen te ontwerpen, waarbij AI effectief wordt gebruikt om AI te helpen bouwen. Dit gebruik van evolutionaire algoritmen om neurale netwerken te optimaliseren, wordt neuro-evolutie genoemd. Het zou een belangrijke rol kunnen spelen bij het ontwerpen van efficiënte AI, aangezien het gebruik van intelligente systemen steeds vaker voorkomt, vooral omdat de vraag naar datawetenschappers vaak groter is dan het aanbod. De techniek werd gedemonstreerd door Uber AI Labs, dat artikelen publiceerde over het gebruik van genetische algoritmen om diepe neurale netwerken te trainen voor leerproblemen met versterking.

Ten slotte zijn er expertsystemen, waar computers zijn geprogrammeerd met regels waarmee ze een reeks beslissingen kunnen nemen op basis van een groot aantal invoer, waardoor die machine het gedrag van een menselijke expert in een specifiek domein kan nabootsen. Een voorbeeld van deze op kennis gebaseerde systemen kan bijvoorbeeld een stuurautomaatsysteem zijn dat een vliegtuig bestuurt.

Wat voedt de heropleving van AI?

Zoals hierboven geschetst, hebben de grootste doorbraken voor AI-onderzoek de afgelopen jaren plaatsgevonden op het gebied van machine learning, met name op het gebied van deep learning.

Dit is deels veroorzaakt door de gemakkelijke beschikbaarheid van gegevens, maar nog meer door een explosie van parallelle rekenkracht, gedurende welke tijd het gebruik van clusters van grafische verwerkingseenheden (GPU's) om machine learning-systemen te trainen steeds meer voorkomt.

Deze clusters bieden niet alleen veel krachtigere systemen voor het trainen van machine learning-modellen, maar zijn nu ook algemeen beschikbaar als cloudservices via internet. In de loop van de tijd zijn de grote technologiebedrijven, zoals Google, Microsoft en Tesla, overgestapt op het gebruik van gespecialiseerde chips die zijn toegespitst op zowel lopende, als meer recentelijk, trainingsmodellen voor machine learning.

Een voorbeeld van een voorbeeld hiervan van deze aangepaste chips is de Tensor Processing Unit (TPU) van Google, waarvan de nieuwste versie de snelheid versnelt waarmee nuttige modellen voor machinaal leren die zijn gebouwd met behulp van de TensorFlow-softwarebibliotheek van Google, informatie uit gegevens kunnen afleiden, evenals de snelheid waarmee ze kunnen worden getraind.

Deze chips worden gebruikt om modellen te trainen voor DeepMind en Google Brain en de modellen die ten grondslag liggen aan Google Translate en de beeldherkenning in Google Foto's en services waarmee het publiek modellen voor machine learning kan bouwen met behulp van Google's TensorFlow Research Cloud. De derde generatie van deze chips werd onthuld op de I/O-conferentie van Google in mei 2018 en is sindsdien verpakt in machine learning-krachtpatsers, pods genaamd, die meer dan honderdduizend biljoen drijvende-kommabewerkingen per seconde (100 petaflops) kunnen uitvoeren. Dankzij deze voortdurende TPU-upgrades heeft Google zijn services kunnen verbeteren die zijn gebaseerd op machine learning-modellen, waardoor de tijd die nodig is om modellen die in Google Translate worden gebruikt, te trainen, is gehalveerd.

Wat zijn de elementen van machine learning?

Zoals gezegd is machine learning een subset van AI en wordt het over het algemeen opgesplitst in twee hoofdcategorieën: leren onder toezicht en niet-gesuperviseerd leren.

Onder toezicht leren

Een veelgebruikte techniek voor het aanleren van AI-systemen is door ze te trainen met behulp van veel gelabelde voorbeelden. Deze machine-learningsystemen worden gevoed met enorme hoeveelheden gegevens, die zijn geannoteerd om de interessante functies te benadrukken. Dit kunnen foto's zijn met een label om aan te geven of ze een hond bevatten of geschreven zinnen met voetnoten om aan te geven of het woord 'bas' betrekking heeft op muziek of op een vis. Eenmaal getraind, kan het systeem deze labels vervolgens toepassen op nieuwe gegevens, bijvoorbeeld op een hond op een foto die zojuist is geüpload.

Dit proces van het aanleren van een machine door een voorbeeld wordt begeleid leren genoemd. Het labelen van deze voorbeelden wordt gewoonlijk uitgevoerd door online werknemers die in dienst zijn van platforms zoals Amazon Mechanical Turk.

Het trainen van deze systemen vereist doorgaans enorme hoeveelheden gegevens, waarbij sommige systemen miljoenen voorbeelden moeten doorzoeken om te leren hoe ze een taak effectief kunnen uitvoeren – hoewel dit steeds meer mogelijk is in een tijdperk van big data en wijdverbreide datamining. Trainingsdatasets zijn enorm en groeien in omvang — Google's Open Images Dataset heeft ongeveer negen miljoen afbeeldingen, terwijl de gelabelde videoopslagplaats YouTube-8M linkt naar zeven miljoen gelabelde video's. ImageNet, een van de eerste databases van dit soort, heeft meer dan 14 miljoen gecategoriseerde afbeeldingen. Het werd in twee jaar tijd samengesteld en werd samengesteld door bijna 50.000 mensen – van wie de meesten werden gerekruteerd via Amazon Mechanical Turk – die bijna een miljard foto's van kandidaten controleerden, sorteerden en labelden.

Toegang hebben tot enorme gelabelde datasets kan op de lange termijn ook minder belangrijk zijn dan toegang tot grote hoeveelheden rekenkracht.

In de afgelopen jaren zijn Generative Adversarial Networks (GAN's) gebruikt in machine learning-systemen die slechts een kleine hoeveelheid gelabelde gegevens nodig hebben naast een grote hoeveelheid niet-gelabelde gegevens, die, zoals de naam al doet vermoeden, minder handmatig werk vereist om voor te bereiden.< /p>

Deze aanpak zou het toegenomen gebruik van semi-gesuperviseerd leren mogelijk maken, waarbij systemen kunnen leren taken uit te voeren met een veel kleinere hoeveelheid gelabelde gegevens dan nodig is voor trainingssystemen die tegenwoordig gebruikmaken van gesuperviseerd leren.

p>

Niet-gesuperviseerd leren

Ongesuperviseerd leren daarentegen gebruikt een andere benadering, waarbij algoritmen patronen in gegevens proberen te identificeren, op zoek naar overeenkomsten die kunnen worden gebruikt om die gegevens te categoriseren.

Een voorbeeld kan zijn het clusteren van fruit dat een vergelijkbare hoeveelheid weegt of auto's met een vergelijkbare motorinhoud.

Het algoritme is niet van tevoren ingesteld om specifieke soorten gegevens eruit te pikken; het zoekt gewoon naar gegevens die de overeenkomsten kunnen groeperen, bijvoorbeeld Google Nieuws dat elke dag verhalen over vergelijkbare onderwerpen groepeert.

Versterkend leren

Een grove analogie voor versterkend leren is een huisdier belonen met een traktatie wanneer het een truc uitvoert. Bij versterkingsleren probeert het systeem een beloning te maximaliseren op basis van de invoergegevens, waarbij het in feite een proces van vallen en opstaan doorloopt totdat het het best mogelijke resultaat bereikt.

Een voorbeeld van versterkend leren is het Deep Q-netwerk van Google DeepMind, dat is gebruikt voor de beste menselijke prestaties in verschillende klassieke videogames. Het systeem krijgt pixels van elk spel en bepaalt verschillende informatie, zoals de afstand tussen objecten op het scherm.

Door ook te kijken naar de behaalde score in elk spel, bouwt het systeem een model op van welke actie maximaliseer de score in verschillende omstandigheden, bijvoorbeeld in het geval van de videogame Breakout, waar de peddel naartoe moet worden verplaatst om de bal te onderscheppen.

De aanpak wordt ook gebruikt in robotica-onderzoek, waar versterkingsleren autonome robots kan helpen om zich optimaal te gedragen in echte omgevingen.

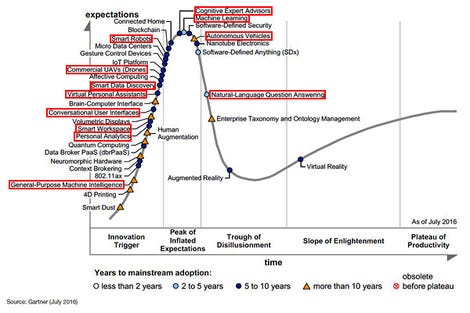

Veel AI-gerelateerde technologieën komen eraan, of hebben dit al bereikt, de “piek van opgeblazen verwachtingen” in Gartner's Hype Cycle, met de terugslag gedreven 'trog van desillusie' op de loer.

Afbeelding: Gartner/Annotaties: ZDNet

Wat zijn de leidende bedrijven in AI?

Nu AI een steeds grotere rol speelt in moderne software en services, strijdt elk groot technologiebedrijf om robuuste technologie voor machine learning te ontwikkelen voor intern gebruik en om via cloudservices aan het publiek te verkopen.

Elk regelmatig haalt de krantenkoppen voor baanbrekend onderzoek in AI-onderzoek, hoewel het waarschijnlijk Google is met zijn DeepMind AI AlphaFold- en AlphaGo-systemen die waarschijnlijk de grootste impact hebben gehad op het publieke bewustzijn van AI.

Welke AI-services zijn beschikbaar?

Alle grote cloudplatforms — Amazon Web Services, Microsoft Azure en Google Cloud Platform — bieden toegang tot GPU-arrays voor training en het uitvoeren van machine learning-modellen, waarbij Google zich ook opmaakt om gebruikers zijn Tensor Processing Units te laten gebruiken — aangepast chips waarvan het ontwerp is geoptimaliseerd voor het trainen en uitvoeren van machine learning-modellen.

Alle benodigde bijbehorende infrastructuur en services zijn beschikbaar bij de grote drie, de cloudgebaseerde gegevensopslag, die de enorme hoeveelheid gegevens kan bevatten die nodig zijn om machine learning-modellen te trainen, services om gegevens te transformeren om deze voor te bereiden voor analyse, visualisatietools om de resultaten duidelijk weer te geven, en software die het bouwen van modellen vereenvoudigt.

Deze cloudplatforms vereenvoudigen zelfs het maken van aangepaste modellen voor machine learning, waarbij Google een service aanbiedt die het maken van AI-modellen automatiseert, genaamd Cloud AutoML. Deze service voor slepen en neerzetten bouwt aangepaste modellen voor beeldherkenning en vereist dat de gebruiker geen ervaring heeft met machine learning.

Cloudgebaseerde, machine learning-services zijn voortdurend in ontwikkeling. Amazon biedt nu een groot aantal AWS-aanbiedingen die zijn ontworpen om het proces van het trainen van machine learning-modellen te stroomlijnen en heeft onlangs Amazon SageMaker Clarify gelanceerd, een tool om organisaties te helpen vooroordelen en onevenwichtigheden in trainingsgegevens uit te roeien die zouden kunnen leiden tot scheve voorspellingen door het getrainde model .

Voor die bedrijven die geen eigen machine=learning-modellen willen bouwen, maar in plaats daarvan AI-aangedreven, on-demand services willen gebruiken, zoals spraak-, visie- en taalherkenning, onderscheidt Microsoft Azure zich door het brede scala aan services op aanbod, op de voet gevolgd door Google Cloud Platform en vervolgens AWS. Ondertussen probeert IBM, naast zijn meer algemene on-demand aanbod, ook sectorspecifieke AI-services te verkopen die gericht zijn op alles, van gezondheidszorg tot detailhandel, deze aanbiedingen samen te brengen onder zijn IBM Watson-paraplu en $ 2 miljard te hebben geïnvesteerd in het kopen van The Weather Kanaal om een schat aan gegevens te ontsluiten om zijn AI-services uit te breiden.

Welke van de grote technologiebedrijven wint de AI-race?

Intern gebruiken elke technologiegigant en anderen zoals Facebook AI om talloze openbare diensten te helpen stimuleren: zoekresultaten weergeven, aanbevelingen doen, mensen en dingen op foto's herkennen, on-demand vertalingen, spam spotten – de lijst is uitgebreid.

Maar een van de meest zichtbare uitingen van deze AI-oorlog is de opkomst van virtuele assistenten, zoals Apple's Siri, Amazon's Alexa, de Google Assistant en Microsoft Cortana.

Omdat ze sterk afhankelijk zijn van spraakherkenning en natuurlijke taalverwerking en een enorm corpus nodig hebben om vragen te beantwoorden, wordt er enorm veel technologie gestoken in het ontwikkelen van deze assistenten.

Maar hoewel Siri van Apple misschien als eerste bekendheid heeft gekregen , het zijn Google en Amazon wiens assistenten sindsdien Apple hebben ingehaald op het gebied van AI – Google Assistant met zijn vermogen om een breed scala aan vragen te beantwoorden en Amazon's Alexa met het enorme aantal 'vaardigheden' dat externe ontwikkelaars hebben gecreëerd om toe te voegen naar zijn mogelijkheden.

In de loop van de tijd krijgen deze assistenten vaardigheden waardoor ze responsiever worden en beter in staat zijn om te gaan met het soort vragen dat mensen stellen in reguliere gesprekken. De Google Assistent biedt nu bijvoorbeeld een functie genaamd Voortgezet gesprek, waar een gebruiker vervolgvragen kan stellen op hun eerste vraag, zoals 'Hoe is het weer vandaag?', gevolgd door 'Hoe zit het met morgen?' en het systeem begrijpt dat de vervolgvraag ook betrekking heeft op het weer.

Deze assistenten en bijbehorende services kunnen ook veel meer aan dan alleen spraak, met de nieuwste versie van Google Lens die tekst in afbeeldingen kan vertalen en u kunt zoeken naar kleding of meubels met behulp van foto's.

Ondanks dat het in Windows 10 is ingebouwd, heeft Cortana het de laatste tijd bijzonder moeilijk gehad, met Amazon's Alexa nu gratis beschikbaar op Windows 10-pc's. Tegelijkertijd heeft Microsoft de rol van Cortana in het besturingssysteem vernieuwd om zich meer te concentreren op productiviteitstaken, zoals het beheren van de planning van de gebruiker, in plaats van meer op de consument gerichte functies die worden aangetroffen in andere assistenten, zoals het afspelen van muziek.

Welke landen lopen voorop in AI?

Het zou een grote vergissing zijn om te denken dat de Amerikaanse techreuzen het gebied van AI hebben genaaid. Chinese bedrijven Alibaba, Baidu en Lenovo investeren fors in AI op gebieden variërend van e-commerce tot autonoom rijden. Als land streeft China naar een driestappenplan om van AI een kernindustrie voor het land te maken, een die tegen eind 2020 150 miljard yuan ($ 22 miljard) waard zal zijn om tegen 2030 's werelds toonaangevende AI-macht te worden.

Baidu heeft geïnvesteerd in de ontwikkeling van zelfrijdende auto's, mogelijk gemaakt door zijn diepgaande algoritme, Baidu AutoBrain. Na een aantal jaren van tests, waarbij de zelfrijdende Apollo Apollo meer dan vijf miljoen kilometer aan tests had afgelegd, vervoerde het meer dan 100.000 passagiers in 27 steden over de hele wereld.

Baidu lanceerde een vloot van 40. Apollo Go Robotaxis in Peking dit jaar. De oprichter van het bedrijf voorspelde dat zelfrijdende voertuigen binnen vijf jaar gemeengoed zullen zijn in de steden van China.

De combinatie van zwakke privacywetten, enorme investeringen, gecoördineerde gegevensverzameling en big data-analyse door grote bedrijven zoals Baidu, Alibaba en Tencent, betekent dat sommige analisten denken dat China een voordeel zal hebben ten opzichte van de VS als het gaat om toekomstig AI-onderzoek , waarbij een analist de kans omschrijft dat China de leiding neemt over de VS als 500 tegen 1 in het voordeel van China.

Baidu's zelfrijdende auto, een aangepaste BMW 3-serie.

Afbeelding: Baidu

Hoe kan ik aan de slag met AI?

Hoewel je een redelijk krachtige Nvidia GPU voor je pc kunt kopen – ergens rond de Nvidia GeForce RTX 2060 of sneller – en een machine learning-model kunt trainen, is waarschijnlijk de gemakkelijkste manier om te experimenteren met AI-gerelateerde services via de cloud.

Alle grote technologiebedrijven bieden verschillende AI-services, van de infrastructuur om uw eigen machine learning-modellen te bouwen en te trainen tot webservices waarmee u toegang krijgt tot AI-aangedreven tools zoals spraak, taal, visie en sentimentherkenning op aanvraag.

Hoe gaat AI de wereld veranderen?

Robots en auto's zonder bestuurder

De wens dat robots autonoom kunnen handelen en de wereld om hen heen kunnen begrijpen en navigeren, betekent dat er een natuurlijke overlap is tussen robotica en AI. Hoewel AI slechts een van de technologieën is die in robotica worden gebruikt, helpt AI robots om nieuwe gebieden te betreden, zoals zelfrijdende auto's, bezorgrobots en helpt ze robots nieuwe vaardigheden te leren. Begin 2020 onthulden General Motors en Honda de Cruise Origin, een elektrisch aangedreven auto zonder bestuurder, en Waymo, de zelfrijdende groep binnen Google-moederalfabet, heeft onlangs zijn robotaxi-service geopend voor het grote publiek in Phoenix, Arizona, met een service voor een gebied van 50 vierkante mijl in de stad.

Nepnieuws

We staan op het punt om neurale netwerken te hebben die fotorealistische afbeeldingen kunnen maken of iemands stem op een perfecte manier kunnen nabootsen. Dat brengt het potentieel met zich mee voor enorm ontwrichtende sociale veranderingen, zoals het niet langer kunnen vertrouwen op video- of audiobeelden als echt. Er begint ook bezorgdheid te ontstaan over de manier waarop dergelijke technologieën zullen worden gebruikt om de afbeeldingen van mensen te misbruiken, en er worden al tools gemaakt om beroemde gezichten op overtuigende wijze in films voor volwassenen te verwerken.

Spraak- en taalherkenning

Machine learning-systemen hebben computers geholpen te herkennen wat mensen zeggen met een nauwkeurigheid van bijna 95%. De kunstmatige intelligentie- en onderzoeksgroep van Microsoft meldde ook dat het een systeem had ontwikkeld dat gesproken Engels net zo nauwkeurig transcribeert als menselijke transcribenten.

Omdat onderzoekers een doel van 99% nauwkeurigheid nastreven, verwachten we dat praten met computers steeds gebruikelijker zal worden, naast meer traditionele vormen van mens-machine-interactie.

Ondertussen zorgde OpenAI's taalvoorspellingsmodel GPT-3 onlangs voor opschudding met zijn vermogen om artikelen te maken die door kunnen gaan alsof ze door een mens zijn geschreven.

Gezichtsherkenning en bewaking

In de afgelopen jaren is de nauwkeurigheid van gezichtsherkenningssystemen enorm toegenomen, tot het punt waarop de Chinese techgigant Baidu zegt dat het gezichten kan matchen met 99% nauwkeurigheid, op voorwaarde dat het gezicht duidelijk genoeg is op de video. Terwijl de politie in westerse landen over het algemeen alleen heeft geprobeerd gezichtsherkenningssystemen te gebruiken bij grote evenementen, zetten de autoriteiten in China een landelijk programma op om CCTV in het hele land te verbinden met gezichtsherkenning en om AI-systemen te gebruiken om verdachten en verdacht gedrag op te sporen, en heeft ook het gebruik van gezichtsherkenningsbrillen door de politie uitgebreid.

Hoewel de privacyregelgeving wereldwijd varieert, is het waarschijnlijk dat dit meer indringende gebruik van AI-technologie, inclusief AI die emoties kan herkennen, geleidelijk meer zal worden. wijd verspreid. Een groeiende terugslag en vragen over de eerlijkheid van gezichtsherkenningssystemen hebben er echter toe geleid dat Amazon, IBM en Microsoft de verkoop van deze systemen aan wetshandhavers hebben stopgezet of stopgezet.

Gezondheidszorg< /p>

AI kan uiteindelijk een dramatische impact hebben op de gezondheidszorg, radiologen helpen om tumoren op röntgenfoto's te onderscheiden, onderzoekers helpen bij het opsporen van genetische sequenties die verband houden met ziekten en het identificeren van moleculen die kunnen leiden tot effectievere medicijnen. De recente doorbraak van Google's AlphaFold 2 machine learning-systeem zal naar verwachting de tijd die nodig is tijdens een belangrijke stap bij het ontwikkelen van nieuwe medicijnen van maanden tot uren terugbrengen.

Er zijn proeven geweest met AI-gerelateerde technologie in ziekenhuizen over de hele wereld. Deze omvatten IBM's Watson-hulpmiddel voor klinische besluitvorming, dat oncologen trainen in het Memorial Sloan Kettering Cancer Center, en het gebruik van Google DeepMind-systemen door de Britse National Health Service, waar het helpt bij het opsporen van oogafwijkingen en het stroomlijnen van het proces van screening van patiënten op hoofd- en nekkanker.

Versterking van discriminatie en vooroordelen

Een groeiende zorg is de manier waarop systemen voor machinaal leren de menselijke vooroordelen en maatschappelijke ongelijkheden die in hun trainingsgegevens worden weerspiegeld, kunnen codificeren. Deze vrees wordt bevestigd door meerdere voorbeelden van hoe een gebrek aan variatie in de gegevens die worden gebruikt om dergelijke systemen te trainen, negatieve gevolgen heeft voor de echte wereld.

In 2018 ontdekten een onderzoekspaper van MIT en Microsoft dat gezichtsherkenningssystemen die door grote technologiebedrijven worden verkocht, significant hogere foutenpercentages vertoonden bij het identificeren van mensen met een donkere huid, een probleem dat wordt toegeschreven aan het feit dat trainingsdatasets voornamelijk werden samengesteld van blanke mannen.

Een jaar later bleek uit een ander onderzoek dat Amazon's Rekognition-gezichtsherkenningssysteem problemen had met het identificeren van het geslacht van personen met een donkere huid, een beschuldiging die werd aangevochten door Amazon-executives, wat een van de onderzoekers ertoe aanzette om de punten die in de Amazon-weerlegging naar voren kwamen aan de orde te stellen.

Sinds de publicatie van de onderzoeken zijn veel van de grote technologiebedrijven, althans tijdelijk, gestopt met de verkoop van gezichtsherkenningssystemen aan politiediensten.

Een ander voorbeeld van onvoldoende gevarieerde resultaten van trainingsgegevens die de resultaten scheeftrekken, haalde de krantenkoppen in 2018 toen Amazon een wervingstool voor machine learning schrapte die mannelijke sollicitanten als de voorkeur identificeerde. Er wordt momenteel onderzoek gedaan naar manieren om vooroordelen in zelflerende systemen te compenseren.

AI en opwarming van de aarde

Naarmate de omvang van machine learning-modellen en de datasets die worden gebruikt om ze te trainen, toeneemt, neemt ook de ecologische voetafdruk toe van de enorme rekenclusters die deze modellen vormen en uitvoeren. De milieu-impact van het voeden en koelen van deze compute farms was het onderwerp van een paper van het World Economic Forum in 2018. Een schatting van 2019 was dat het vermogen dat nodig is voor machine learning-systemen elke 3,4 maanden verdubbelt.

De kwestie van de enorme hoeveelheid energie die nodig is om krachtige machine learning-modellen te trainen, werd onlangs onder de aandacht gebracht door de release van het taalvoorspellingsmodel GPT-3, een uitgestrekt neuraal netwerk met zo'n 175 miljard parameters.

Hoewel de middelen die nodig zijn om dergelijke modellen te trainen enorm kunnen zijn en grotendeels alleen beschikbaar zijn voor grote bedrijven, is de energie die nodig is om deze modellen te laten werken, eenmaal getraind aanzienlijk minder. Naarmate de vraag naar diensten op basis van deze modellen groeit, wordt het energieverbruik en de daaruit voortvloeiende milieu-impact opnieuw een probleem.

Een argument is dat de milieu-impact van training en het gebruik van grotere modellen moet worden afgewogen tegen de potentiële machine learning, die een aanzienlijk positief effect moet hebben, bijvoorbeeld de snellere vooruitgang in de gezondheidszorg die waarschijnlijk lijkt na de doorbraak van Google DeepMind's AlphaFold 2.

Zal AI ons allemaal doden?

Nogmaals, het hangt af van wie je het vraagt. Naarmate AI-aangedreven systemen capabeler zijn geworden, zijn waarschuwingen voor de nadelen erger geworden.

Elon Musk, de CEO van Tesla en SpaceX, heeft beweerd dat AI een “fundamenteel risico is voor het voortbestaan van de menselijke beschaving”. Als onderdeel van zijn streven naar sterker regelgevend toezicht en meer verantwoord onderzoek naar het verminderen van de nadelen van AI, richtte hij OpenAI op, een non-profit onderzoeksbureau op het gebied van kunstmatige intelligentie dat vriendelijke AI wil promoten en ontwikkelen waar de samenleving als geheel van profiteert. Evenzo waarschuwde de gewaardeerde fysicus Stephen Hawking dat zodra een voldoende geavanceerde AI is gemaakt, deze snel zal evolueren tot het punt waarop het de menselijke capaciteiten enorm overtreft. Een fenomeen staat bekend als een singulariteit en kan een existentiële bedreiging vormen voor de mensheid.

Toch lijkt het idee dat de mensheid op de rand staat van een AI-explosie die ons intellect in de schaduw zal stellen, voor sommige AI-onderzoekers belachelijk.

Chris Bishop, onderzoeksdirecteur van Microsoft in Cambridge, Engeland, benadrukt hoe verschillend de enge intelligentie van AI vandaag de dag is afkomstig van de algemene intelligentie van mensen, die zegt dat wanneer mensen zich zorgen maken over “Terminator en de opkomst van de machines enzovoort? Volstrekte onzin, ja. In het beste geval zijn dergelijke discussies tientallen jaren verwijderd.”

< h2> Zal een AI je baan stelen?

De mogelijkheid dat kunstmatig intelligente systemen veel van de moderne handarbeid vervangen, is misschien een meer geloofwaardige nabije toekomst mogelijkheid.

Hoewel AI niet alle banen zal vervangen, lijkt het zeker dat AI de aard van het werk zal veranderen, waarbij de enige vraag is hoe snel en hoe ingrijpend automatisering de werkplek zal veranderen.

Er is nauwelijks een gebied van menselijke inspanningen dat AI niet het potentieel heeft om invloed uit te oefenen. Zoals AI-expert Andrew Ng het stelt: “veel mensen doen routinematige, repetitieve banen. Helaas is technologie vooral goed in het automatiseren van routinematig, repetitief werk”, zegt hij dat hij een “aanzienlijk risico op technologische werkloosheid in de komende decennia” ziet.< /p>

Het bewijs van welke banen zullen worden verdrongen, begint naar voren te komen. Er zijn nu 27 Amazon Go-winkels en kassavrije supermarkten waar klanten gewoon items uit de schappen halen en naar buiten lopen in de VS. Wat dit betekent voor de meer dan drie miljoen mensen in de VS die als kassier werken, valt nog te bezien. Amazon loopt opnieuw voorop in het gebruik van robots om de efficiëntie in zijn magazijnen te verbeteren. Deze robots dragen schappen met producten naar menselijke plukkers die items selecteren om te verzenden. Amazon heeft meer dan 200.000 bots in zijn fulfilmentcentra, met plannen om er meer toe te voegen. Maar Amazon benadrukt ook dat naarmate het aantal bots is gegroeid, ook het aantal menselijke werknemers in deze magazijnen is toegenomen. Amazon en kleine roboticabedrijven werken echter aan het automatiseren van de resterende handmatige taken in het magazijn, dus het is geen gegeven dat handmatige en robotische arbeid hand in hand zullen blijven groeien.

Volledig autonome zelfrijdende voertuigen zijn nog geen realiteit, maar volgens sommige voorspellingen zal de zelfrijdende vrachtwagenindustrie alleen al in het komende decennium 1,7 miljoen banen overnemen, zelfs zonder rekening te houden met de impact op koeriers en taxichauffeurs.< /p>

Maar voor sommige van de gemakkelijkst te automatiseren taken is zelfs geen robotica nodig. Op dit moment zijn er miljoenen mensen werkzaam in de administratie, het invoeren en kopiëren van gegevens tussen systemen, het najagen en boeken van afspraken voor bedrijven, aangezien software steeds beter wordt in het automatisch bijwerken van systemen en het markeren van belangrijke informatie, waardoor de behoefte aan beheerders zal afnemen.

Zoals bij elke technologische verandering zullen er nieuwe banen worden gecreëerd om de verloren banen te vervangen. Het is echter onzeker of deze nieuwe functies snel genoeg zullen worden gecreëerd om de ontheemden een baan te bieden en of de nieuwe werklozen over de nodige vaardigheden of het temperament zullen beschikken om deze opkomende rollen te vervullen.

Niet iedereen is een pessimist. Voor sommigen is AI een technologie die werknemers zal vergroten in plaats van vervangen. Niet alleen dat, maar ze beweren dat er een commerciële noodzaak zal zijn om mensen niet regelrecht te vervangen, als een AI-geassisteerde werknemer – denk aan een menselijke conciërge met een AR-headset die hen precies vertelt wat een klant wil voordat ze erom vragen – zal productiever of effectiever zijn dan een AI die alleen werkt.

Er is een breed scala aan meningen over hoe snel kunstmatig intelligente systemen de menselijke capaciteiten zullen overtreffen onder AI-experts.

Het Future of Humanity Institute van de Universiteit van Oxford vroeg honderden experts op het gebied van machine learning om de AI-capaciteiten in de komende decennia te voorspellen.

Opmerkelijke data waren onder meer het schrijven van essays over AI die in 2026 door een mens zouden kunnen worden geschreven, vrachtwagenchauffeurs die ontslagen in 2027, AI overtreft de menselijke capaciteiten in de detailhandel in 2031, schrijft een bestseller in 2049 en doet het werk van een chirurg in 2053.

Ze schatten dat er een relatief grote kans is dat AI de mens binnen 45 jaar verslaat bij alle taken en alle menselijke taken binnen 120 jaar automatiseert.

Meer zien:

Verklaarbare AI: van de piek van opgeblazen verwachtingen tot de valkuilen van het interpreteren van machine learning-modellen.AI-biasdetectie (ook bekend als — het lot van onze datagestuurde wereld). Het probleem met AI: waarom we nieuwe wetten nodig hebben om te voorkomen dat algoritmen ons leven verpesten.Mens ontmoet AI: Intel Labs-team verlegt de grenzen van mens-machine-interactie met diepgaand leren.Grote steun om artsen te koppelen aan AI-assist-technologie.Wat de toekomst biedt voor AI: Gary Marcus vertelt over de reis naar robuuste kunstmatige intelligentie.De tijd is misschien rijp voor het professionaliseren van kunstmatige-intelligentiepraktijken .Dit is een AI, wat is je noodgeval?.Neuromorfe netwerken fokken voor plezier en winst: de nieuwe voortplantingswetenschap.Om er te komen: gestructureerde gegevens , semantiek, robotica en de toekomst van AI.Adobe lanceert AI-tools om omnichannel te volgen, afwijkingen sneller op te sporen.

IBM voegt Watson-tools toe voor begrijpend lezen, extractie van veelgestelde vragen.

Gerelateerde berichtgeving

Hoe ML en AI business intelligence en analyse zullen transformeren

Vooruitgang op het gebied van machine learning en kunstmatige intelligentie op vijf gebieden zal het voorbereiden, ontdekken, analyseren, voorspellen en nemen van datagestuurde besluitvorming vergemakkelijken.

Rapport: Kunstmatige intelligentie creëert banen en genereert economische winst

Een nieuw onderzoek van Deloitte laat zien dat early adopters van cognitieve technologieën positief zijn over hun huidige en toekomstige rol.

AI en banen: waar mensen beter zijn dan algoritmen, en vice versa

Het is gemakkelijk om verstrikt te raken in de onheilspellende voorspellingen over het verdwijnen van kunstmatige intelligentie miljoenen banen. Hier is een realiteitscheck.

Hoe kunstmatige intelligentie een nieuw type cybercriminaliteit ontketent(TechRepublic)

In plaats van zich achter een masker te verschuilen om een bank te beroven, verschuilen criminelen zich nu achter kunstmatige intelligentie om hun aanval uit te voeren. Maar ook financiële instellingen kunnen AI gebruiken om deze misdaden te bestrijden.

Elon Musk: Kunstmatige intelligentie kan de Derde Wereldoorlog ontketenen (CNET)

De seriële CEO vecht al tegen de sciencefictiongevechten van morgen, en hij blijft zich meer zorgen maken over de moordenaar robots dan iets anders.

Verwante onderwerpen:

Cloud Digital Transformation CXO Internet of Things Innovatie Enterprise Software ![]()