Bilde: Apple

Fredag avslørte Apple planer om å håndtere problemet med barnemishandling på sine operativsystemer i USA via oppdateringer til iOS 15, iPadOS 15, watchOS 8 og macOS Monterey.

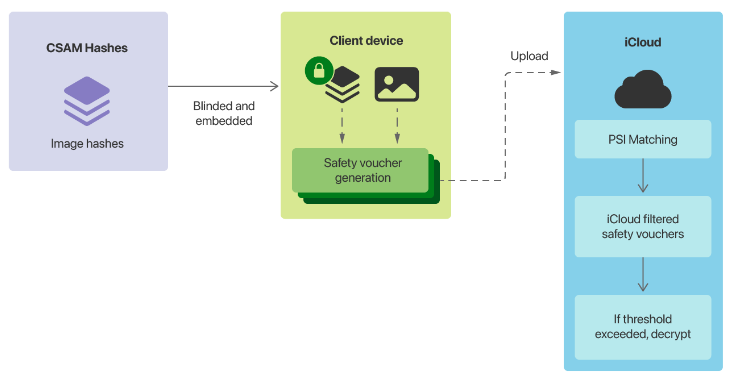

Den mest omstridte komponenten i Cupertinos planer er materialet for registrering av seksuelle overgrep mot barn (CSAM). Det vil omfatte Apple -enheter som matcher bilder på enheten mot en liste over kjente CSAM -bildeaviser levert av US National Center for Missing and Exploited Children (NCMEC) og andre barnesikkerhetsorganisasjoner før et bilde lagres i iCloud.

“Før et bilde lagres i iCloud Photos, utføres en enhetlig prosess på enheten for det bildet mot de kjente CSAM-hashene. Denne matchingsprosessen drives av en kryptografisk teknologi som kalles private set-kryss, som avgjør om det er en kamp uten å avsløre resultatet, “sa Apple.

“Enheten oppretter en kryptografisk sikkerhetskupong som koder kampresultatet sammen med ytterligere krypterte data om bildet. Denne kupongen lastes opp til iCloud -fotografier sammen med bildet.”

Når en ikke oppgitt terskel er nådd, vil Apple se på bilagene manuelt og se gjennom metadataene. Hvis selskapet bestemmer at det er CSAM, vil kontoen bli deaktivert og en rapport sendes til NCMEC. Cupertino sa at brukerne vil kunne appellere for å få en konto aktivert på nytt.

Apple hevder at terskelen vil sikre “mindre enn én til én billion bilsjanser i året for feil flagging av en gitt konto”.

De andre funksjonene som Apple kunngjorde på fredag, hadde Siri og søk som gir advarsler når en bruker søker etter CSAM-relatert innhold, og bruker maskinlæring for å advare barn når de skal se seksuelt eksplisitte bilder i iMessages.

“Når du mottar denne typen innhold, vil bildet bli uskarpt og barnet vil bli advart, presentert med nyttige ressurser og forsikret om at det er greit hvis de ikke vil se dette bildet. Som en ekstra forholdsregel kan barnet også fortalte at for å sikre at de er trygge, vil foreldrene deres få en melding hvis de ser det, sier Apple.

“Lignende beskyttelse er tilgjengelig hvis et barn prøver å sende seksuelt eksplisitte bilder. Barnet blir advart før bildet sendes, og foreldrene kan motta en melding hvis barnet velger å sende det.”

Bilde: Apple

Planer merket som bakdør

Apples planer vakte kritikk i helgen, med Electronic Frontier Foundation som merket funksjonene som en bakdør.

“Hvis du har brukt tid på å følge kryptokrigene, vet du hva dette betyr: Apple planlegger å bygge en bakdør inn i datalagringssystemet og meldingssystemet,” skrev EFF.

“Apple kan lenge forklare hvordan den tekniske implementeringen vil bevare personvernet og sikkerheten i den foreslåtte bakdøren, men på slutten av dagen er til og med en grundig dokumentert, nøye gjennomtenkt og snevt bakdør fortsatt en bakdør.”

EFF advarte om at når CSAM -systemet var på plass, ville neste trinn være å endre systemet for å søke etter andre typer innhold.

“Det er ikke en glatt skråning; det er et fullstendig bygget system som bare venter på at ytre press skal gjøre den minste endringen,” sa det.

“Overgrepssakene er enkle å forestille seg: regjeringer som forbyr homoseksualitet kan kreve at klassifisereren blir opplært til å begrense tilsynelatende LGBTQ+ -innhold, eller et autoritært regime kan kreve at klassifisereren kan oppdage populære satiriske bilder eller protestflyveblad.”

EFF la til at med iMessage for å begynne å skanne bilder sendt og mottatt, var kommunikasjonsplattformen ikke lenger ende-til-ende-kryptert.

“Apple og tilhengerne kan hevde at skanning før eller etter en melding er kryptert eller dekryptert holder løftet fra ende til ende intakt, men det ville være semantisk manøvrering for å skjule et tektonisk skifte i selskapets holdning til sterk kryptering, “sa stiftelsen.

Sjef for WhatsApp Will Cathcart sa at Facebook-eide plattformen ikke ville vedta Apples tilnærming og i stedet stole på at brukerne rapporterer materiale.

“Dette er et Apple -bygget og drevet overvåkningssystem som veldig enkelt kan brukes til å skanne privat innhold for alt de eller en regjering bestemmer seg for å kontrollere. Land der iPhone selges vil ha forskjellige definisjoner på hva som er akseptabelt,” sa Cathcart.

WhatsApp -sjefen spurte hvordan systemet ville fungere i Kina, og hva som ville skje når et spionprogrammannskap fant ut hvordan de skulle utnytte systemet.

WhatsApp skanner ukrypterte bilder – for eksempel profil- og gruppebilder – etter barnemishandling.

“Vi har tilleggsteknologi for å oppdage ny, ukjent CEI innenfor denne ukrypterte informasjonen. Vi bruker også maskinlæringsklassifiseringer til både å skanne tekstflater, for eksempel brukerprofiler og gruppebeskrivelser, og evaluere gruppeinformasjon og oppførsel for mistenkt CEI -deling,” sier selskapet. sa.

Tidligere Facebook CSO Alex Stamos sa at han var glad for å se Apple ta ansvar for virkningen av plattformen, men satte spørsmålstegn ved tilnærmingen.

“De flyttet begge ballen fremover teknisk mens de skadet den generelle innsatsen for å finne politisk balanse,” sa Stamos.

“Et av de grunnleggende problemene med Apples tilnærming er at de virker desperate etter å unngå å bygge en ekte tillits- og sikkerhetsfunksjon for kommunikasjonsproduktene sine. Det er ingen mekanisme for å rapportere spam, dødstrusler, hatefulle ytringer, NCII eller andre former for overgrep. på iMessage. ”

I stedet for “ikke-samtykkeskanning av lokale bilder og opprettelse av ML på klientsiden som ikke gir mye reell skadeforebygging”, sa Stamos at han ville foretrukket om Apple hadde robust rapportering i iMessage, bemannet et barnesikringsteam for å undersøke rapporter, og rullet sakte ut maskinlæring på klientsiden. Den tidligere Facebook-sikkerhetssjefen sa at han fryktet at Apple hadde forgiftet brønnen på klientsider.

“Mens Kina har blitt påkalt mye, forventer jeg at UK Online Safety Bill og EU Digital Services Act var mye viktigere for Apples hensyn,” sa han.

Varsleren Edward Snowden anklaget Apple for å ha distribuert masseovervåking rundt om i verden.

“Gjør ingen feil: hvis de kan søke etter barneporno i dag, kan de søke etter alt i morgen,” sa han.

“De gjorde en billion dollar av enheter til iNarcs -*uten å spørre.*”

Sent på fredag rapporterte 9to5Mac om et internt notat fra Apple som inneholdt et notat fra NCMEC.

“Vi vet at dagene som kommer vil bli fylt med skrikende stemmer fra minoriteten,” sa NCMEC.

Relatert dekning

Hvorfor ser det ut til at Apple gjør så mange dårlige designvalg? Hvorfor vil du kanskje ikke kjøpe en ny iPhone før i 2022 Slutt å ignorere denne iPhone -advarselen Apple FYQ3 knuser forventningene: 81,4 milliarder dollar omsetning, $ 1,30 EPS; deler sag

Relaterte emner:

Apple Security TV Data Management CXO datasentre ![]()