Bild: Apple

På fredagen avslöjade Apple planer på att ta itu med frågan om övergrepp mot barn på sina operativsystem i USA via uppdateringar till iOS 15, iPadOS 15, watchOS 8 och macOS Monterey.

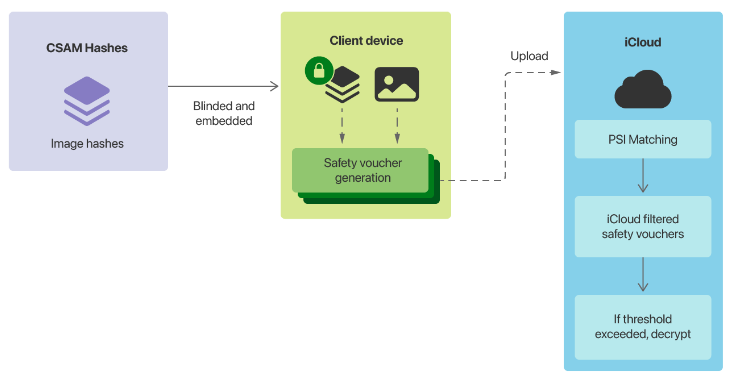

Den mest omtvistade komponenten i Cupertinos planer är dess system för upptäckt av sexuella övergrepp mot barn (CSAM). Det kommer att innebära att Apple -enheter matchar bilder på enheten mot en lista över kända CSAM -bildhashar som tillhandahålls av US National Center for Missing and Exploited Children (NCMEC) och andra barnsäkerhetsorganisationer innan en bild lagras i iCloud.

“Innan en bild lagras i iCloud Photos utförs en matchningsprocess på enheten för den bilden mot de kända CSAM-hasharna. Denna matchningsprocess drivs av en kryptografisk teknik som kallas privat uppsättningskorsning, som avgör om det finns en matchning utan att avslöja resultatet, säger Apple.

“Enheten skapar en kryptografisk säkerhetsbevis som kodar matchningsresultatet tillsammans med ytterligare krypterad data om bilden. Denna kupong laddas upp till iCloud -foton tillsammans med bilden.”

När ett ouppgivet tröskel har uppnåtts kommer Apple att manuellt titta på kupongerna och granska metadata. Om företaget bestämmer att det är CSAM kommer kontot att inaktiveras och en rapport skickas till NCMEC. Cupertino sa att användarna kommer att kunna överklaga för att få ett konto återaktiverat.

Apple hävdar att dess tröskel kommer att garantera “mindre än en i en biljon chans per år att felaktigt flagga ett visst konto”.

Det andra paret av funktioner som Apple tillkännagav på fredagen var att ha Siri och sökning ger varningar när en användare söker efter CSAM-relaterat innehåll och använder maskininlärning för att varna barn när de ska se sexuellt uttalade foton i iMessages.

“När du får den här typen av innehåll blir bilden suddig och barnet varnas, presenteras med hjälpsamma resurser och försäkras om att det är okej om de inte vill se det här fotot. Som en extra försiktighetsåtgärd kan barnet också berättade att för att se till att de är säkra kommer deras föräldrar att få ett meddelande om de ser det, säger Apple.

“Liknande skydd är tillgängliga om ett barn försöker skicka sexuellt explicita foton. Barnet kommer att varnas innan fotot skickas, och föräldrarna kan få ett meddelande om barnet väljer att skicka det.”

Bild: Apple

Planer märkta som en bakdörr

Apples planer väckte kritik under helgen, med Electronic Frontier Foundation som märkte funktionerna som en bakdörr.

“Om du har spenderat någon tid efter Crypto Wars vet du vad detta innebär: Apple planerar att bygga en bakdörr i sitt datalagringssystem och sitt meddelandesystem”, skrev EFF.

“Apple kan ingående förklara hur dess tekniska implementering kommer att bevara integriteten och säkerheten i den föreslagna bakdörren, men i slutet av dagen är till och med en noggrant dokumenterad, noga genomtänkt och snävt omfattande bakdörr fortfarande en bakdörr.”

EFF varnade för att när CSAM -systemet väl var på plats, skulle nästa steg vara att ändra systemet för att söka efter andra typer av innehåll.

“Det här är inte en hal sluttning; det är ett fullt byggt system som bara väntar på att yttre tryck ska göra den minsta förändring”, stod det.

“Missbruksärenden är lätta att föreställa sig: regeringar som förbjuder homosexualitet kan kräva att klassificeraren utbildas för att begränsa uppenbart HBTQ+ -innehåll, eller en auktoritär regim kan kräva att klassificeraren kan upptäcka populära satiriska bilder eller protestflygplan.”

EFF tillade att med iMessage för att börja skanna bilder skickade och mottagna var kommunikationsplattformen inte längre krypterad från ände till ände.

“Apple och dess förespråkare kan hävda att skanning före eller efter ett meddelande är krypterat eller dekrypterat håller löftet från slutet till slutet intakt, men det skulle vara semantisk manöver för att täcka över ett tektoniskt skift i företagets inställning till stark kryptering, sa stiftelsen.

Chef för WhatsApp Will Cathcart sa att den Facebookägda plattformen inte skulle anta Apples tillvägagångssätt och istället förlita sig på att användare rapporterar material.

“Detta är ett Apple -byggt och drivet övervakningssystem som mycket enkelt kan användas för att skanna privat innehåll efter allt som de eller en regering beslutar att de vill kontrollera. Länder där iPhones säljs kommer att ha olika definitioner av vad som är acceptabelt”, säger Cathcart.

WhatsApp -chefen frågade hur systemet skulle fungera i Kina, och vad som skulle hända när ett spionprogram besökt hur man använder systemet.

WhatsApp genomsöker okrypterade bilder – till exempel profil- och gruppfoton – efter barnmisshandel.

“Vi har ytterligare teknik för att upptäcka nytt, okänt CEI inom denna okrypterade information. Vi använder också maskininlärningsklassificerare för att både skanna textytor, till exempel användarprofiler och gruppbeskrivningar, och utvärdera gruppinformation och beteende för misstänkt CEI -delning,” företaget sa.

Tidigare Facebook CSO Alex Stamos sa att han var glad över att se Apple ta ansvar för effekterna av sin plattform, men ifrågasatte tillvägagångssättet.

“De båda flyttade fram bollen tekniskt samtidigt som de skadade den övergripande ansträngningen att hitta politisk balans”, säger Stamos.

“Ett av de grundläggande problemen med Apples tillvägagångssätt är att de verkar desperata efter att undvika att bygga en verklig förtroende- och säkerhetsfunktion för sina kommunikationsprodukter. Det finns ingen mekanism för att rapportera skräppost, dödshot, hatfulla uttalanden, NCII eller andra typer av övergrepp. på iMessage. ”

Istället för sin “icke-konsensusskanning av lokala foton och skapa ML på klientsidan som inte kommer att ge mycket verklig skadaprevention”, sa Stamos att han skulle ha föredragit om Apple hade robust rapportering i iMessage, bemannat ett barnsäkerhetsteam för att undersöka rapporter och långsamt rullade ut maskininlärning på klientsidan. Den tidigare Facebook-säkerhetschefen sa att han fruktade att Apple hade förgiftat brunnen på klientsidan klassificerare.

“Medan Kina har åberopats mycket förväntar jag mig att Storbritanniens onlinesäkerhetsförslag och EU Digital Services Act var mycket viktigare för Apples överväganden”, sa han.

Whistleblower Edward Snowden anklagade Apple för att ha infört massövervakning runt om i världen.

“Gör inga misstag: om de kan söka efter barnporr idag kan de söka efter allt imorgon”, sa han.

“De gjorde en biljon dollar enheter till iNarcs -*utan att fråga.*”

Sent på fredagen rapporterade 9to5Mac om ett internt memo från Apple som innehöll en anteckning från NCMEC.

“Vi vet att de kommande dagarna kommer att fyllas med minoritetens skrikande röster”, uppger NCMEC enligt uppgift.

Relaterad täckning

Varför verkar det som om Apple gör så många dåliga designval? Varför kanske du inte vill köpa en ny iPhone förrän 2022 Sluta ignorera denna iPhone -varning Apple FYQ3 krossar förväntningarna: 81,4 miljarder dollar intäkter, 1,30 dollar EPS; aktier sag

Relaterade ämnen:

Apple Security TV Data Management CXO Datacenter ![]()