Afbeelding: Apple

Vrijdag heeft Apple plannen onthuld om het probleem van kindermisbruik op zijn besturingssystemen in de Verenigde Staten aan te pakken via updates voor iOS 15, iPadOS 15, watchOS 8 en macOS Monterey.

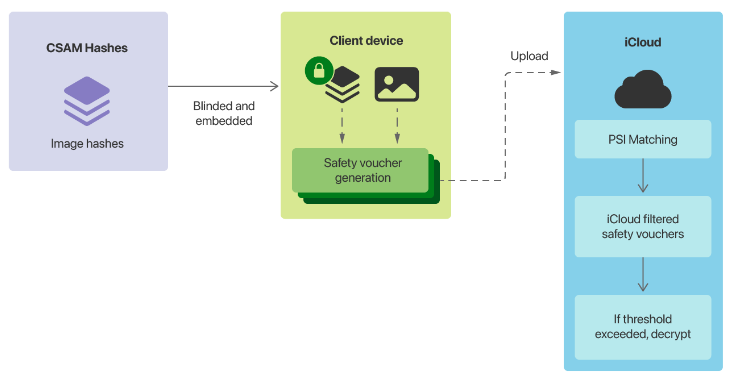

Het meest controversiële onderdeel van Cupertino's plannen is het detectiesysteem voor materiaal voor seksueel misbruik van kinderen (CSAM). Het gaat om Apple-apparaten die afbeeldingen op het apparaat matchen met een lijst met bekende CSAM-afbeeldingshashes die zijn verstrekt door het Amerikaanse National Center for Missing and Exploited Children (NCMEC) en andere kinderveiligheidsorganisaties voordat een afbeelding wordt opgeslagen in iCloud.

“Voordat een afbeelding wordt opgeslagen in iCloud-foto's, wordt er op het apparaat een matchingproces voor die afbeelding uitgevoerd met de bekende CSAM-hashes. Dit matchingproces wordt mogelijk gemaakt door een cryptografische technologie die private set-intersectie wordt genoemd, die bepaalt of er een match is zonder te onthullen het resultaat”, aldus Apple.

“Het apparaat maakt een cryptografische veiligheidsvoucher die het wedstrijdresultaat codeert, samen met aanvullende versleutelde gegevens over de afbeelding. Deze voucher wordt samen met de afbeelding geüpload naar iCloud-foto's.”

Zodra een niet-vermelde drempel is bereikt, zal Apple handmatig naar de vouchers kijken en de metadata beoordelen. Als het bedrijf vaststelt dat het CSAM is, wordt het account uitgeschakeld en wordt er een rapport naar de NCMEC gestuurd. Cupertino zei dat gebruikers een beroep kunnen doen op het opnieuw inschakelen van een account.

Apple beweert dat de drempel ervoor zorgt dat “minder dan een op een biljoen kans per jaar een bepaald account onjuist wordt gemarkeerd”.

De andere twee functies die Apple vrijdag aankondigde, waren dat Siri en zoeken waarschuwingen geven wanneer een gebruiker zoekt naar CSAM-gerelateerde inhoud, en het gebruik van machine learning om kinderen te waarschuwen wanneer ze op het punt staan seksueel expliciete foto's te bekijken in iBerichten.

“Bij het ontvangen van dit soort inhoud, wordt de foto wazig en wordt het kind gewaarschuwd, krijgt het nuttige hulpmiddelen aangeboden en wordt het gerustgesteld dat het goed is als het deze foto niet wil bekijken. Als extra voorzorgsmaatregel kan het kind ook worden verteld dat, om er zeker van te zijn dat ze veilig zijn, hun ouders een bericht zullen krijgen als ze het bekijken”, aldus Apple.

“Vergelijkbare beschermingen zijn beschikbaar als een kind seksueel expliciete foto's probeert te verzenden. Het kind wordt gewaarschuwd voordat de foto wordt verzonden en de ouders kunnen een bericht ontvangen als het kind ervoor kiest om het te verzenden.”

Afbeelding: Apple

Plannen gelabeld als een achterdeur

Apple's plannen lokten dit weekend kritiek uit, waarbij Electronic Frontier Foundation de functies bestempelde als een achterdeur.

“Als je de Crypto Wars hebt gevolgd, weet je wat dit betekent: Apple is van plan een achterdeur in te bouwen in zijn gegevensopslagsysteem en zijn berichtensysteem”, schreef de EFF.

“Apple kan uitgebreid uitleggen hoe de technische implementatie de privacy en veiligheid in de voorgestelde achterdeur zal behouden, maar uiteindelijk is zelfs een grondig gedocumenteerde, zorgvuldig doordachte en nauw begrensde achterdeur nog steeds een achterdeur.”

EFF waarschuwde dat als het CSAM-systeem eenmaal geïnstalleerd was, het veranderen van het systeem om naar andere soorten inhoud te zoeken de volgende stap zou zijn.

“Dat is geen gladde helling; dat is een volledig gebouwd systeem dat wacht op externe druk om de minste verandering aan te brengen,” zei het.

“De gevallen van misbruik zijn gemakkelijk voor te stellen: regeringen die homoseksualiteit verbieden, kunnen eisen dat de classifier wordt getraind om schijnbare LGBTQ+-inhoud te beperken, of een autoritair regime kan eisen dat de classifier populaire satirische afbeeldingen of protestfolders kan zien.”

De EFF voegde eraan toe dat met iMessage om te beginnen met het scannen van verzonden en ontvangen afbeeldingen, het communicatieplatform niet langer end-to-end versleuteld was.

“Apple en zijn voorstanders kunnen beweren dat scannen voor of nadat een bericht is gecodeerd of gedecodeerd de 'end-to-end'-belofte intact houdt, maar dat zou semantisch manoeuvreren zijn om een tektonische verschuiving in de houding van het bedrijf ten opzichte van sterke encryptie te verdoezelen, ', aldus de stichting.

Hoofd van WhatsApp Will Cathcart zei dat het Facebook-platform niet de aanpak van Apple zou overnemen en in plaats daarvan zou vertrouwen op gebruikers die materiaal rapporteren.

“Dit is een door Apple gebouwd en beheerd bewakingssysteem dat heel gemakkelijk kan worden gebruikt om privé-inhoud te scannen op alles wat zij of een overheid wil controleren. Landen waar iPhones worden verkocht, hebben verschillende definities van wat acceptabel is”, zei Cathcart.

De WhatsApp-chef vroeg hoe het systeem in China zou werken en wat er zou gebeuren als een spywareteam erachter kwam hoe het systeem te exploiteren.

WhatsApp scant niet-versleutelde afbeeldingen — zoals profiel- en groepsfoto's — op materiaal voor kindermisbruik.

“We hebben aanvullende technologie om nieuwe, onbekende CEI binnen deze niet-versleutelde informatie te detecteren. We gebruiken ook machine learning-classificaties om zowel tekstoppervlakken, zoals gebruikersprofielen en groepsbeschrijvingen te scannen, als groepsinformatie en gedrag te evalueren op vermoedelijk delen van CEI”, aldus het bedrijf. zei.

Voormalig Facebook-CSO Alex Stamos zei blij te zijn dat Apple de verantwoordelijkheid nam voor de impact van zijn platform, maar zette vraagtekens bij de aanpak.

“Ze hebben allebei de bal technisch naar voren gebracht, terwijl ze de algehele inspanning om een beleidsevenwicht te vinden, schade toebrachten”, zei Stamos.

“Een van de fundamentele problemen met de aanpak van Apple is dat ze wanhopig lijken te voorkomen dat ze een echte vertrouwens- en veiligheidsfunctie voor hun communicatieproducten bouwen. Er is geen mechanisme om spam, doodsbedreigingen, haatzaaien, NCII of andere vormen van misbruik te melden op iMessage.”

In plaats van het “niet-consensuele scannen van lokale foto's en het creëren van client-side ML die niet veel echte schadepreventie biedt”, zei Stamos dat hij liever had gehad dat Apple robuuste rapportage in iMessage had, een kinderveiligheidsteam bemand om rapporten te onderzoeken en langzaam machine learning aan de clientzijde uit te rollen. De voormalige Facebook-beveiligingschef zei dat hij vreesde dat Apple de put op client-side classifiers had vergiftigd.

“Hoewel er veel een beroep is gedaan op de VRC, verwacht ik dat de UK Online Safety Bill en de EU Digital Services Act veel belangrijker waren voor Apple's overwegingen”, zei hij.

Klulkenluider Edward Snowden beschuldigde Apple van het wereldwijd inzetten van massasurveillance.

“Vergis je niet: als ze vandaag naar kinderporno kunnen scannen, kunnen ze morgen overal naar zoeken”, zei hij.

“Ze hebben een biljoen dollar aan apparaten omgezet in iNarcs -*zonder te vragen.*”

Laat op vrijdag berichtte 9to5Mac over een interne memo van Apple met een notitie van NCMEC.

“We weten dat de komende dagen gevuld zullen zijn met de krijsende stemmen van de minderheid”, zei NCMEC naar verluidt.

Verwante dekking

Waarom lijkt het alsof Apple zoveel slechte ontwerpkeuzes maakt? Waarom zou je pas in 2022 een nieuwe iPhone willen kopen? $ 1,30 WPA; deelt sag

gerelateerde onderwerpen:

Apple Security TV Data Management CXO Datacenters ![]()