Kulynych opnåede den største belønning takket være sin opdagelse at Twitters algoritme har en tendens til at anvende et “skønhedsfilter”.

Billede: Bogdan Kulynych

Twitter har prøvet en hidtil uset metode til at finde de skjulte skævheder i sine egne algoritmer.

Den sociale medieplatform har tilmeldt eksterne forskere til en enestående konkurrence, hvor vindende deltagere var dem, der kunne komme med det mest overbevisende bevis for en uretfærdig praksis, der udføres af en af virksomhedens algoritmer.

Kaldet “algoritmisk bias bounty-udfordring”, og initiativet gav deltagerne fuld adgang til den kode, der ligger til grund for Twitters billedbeskæringsalgoritme, som bestemmer, hvordan billeder skal beskæres, så de let kan ses, når de kommer op på en brugers tidslinje.

SE: Pentagon siger, at dens nye AI kan se begivenheder 'dage i forvejen'

Modellen er programmeret til at estimere, hvad en person mest sandsynligt vil se på et billede – det vil sige den mest fremtrædende del af billedet, hvorfor det også er kendt som saltholdighedsalgoritmen. Målet med udfordringen var at finde ud af, om saltholdighedsalgoritmen træffer skadelige eller diskriminerende valg, med løfte om at vinde præmier fra $ 500 til $ 3.500.

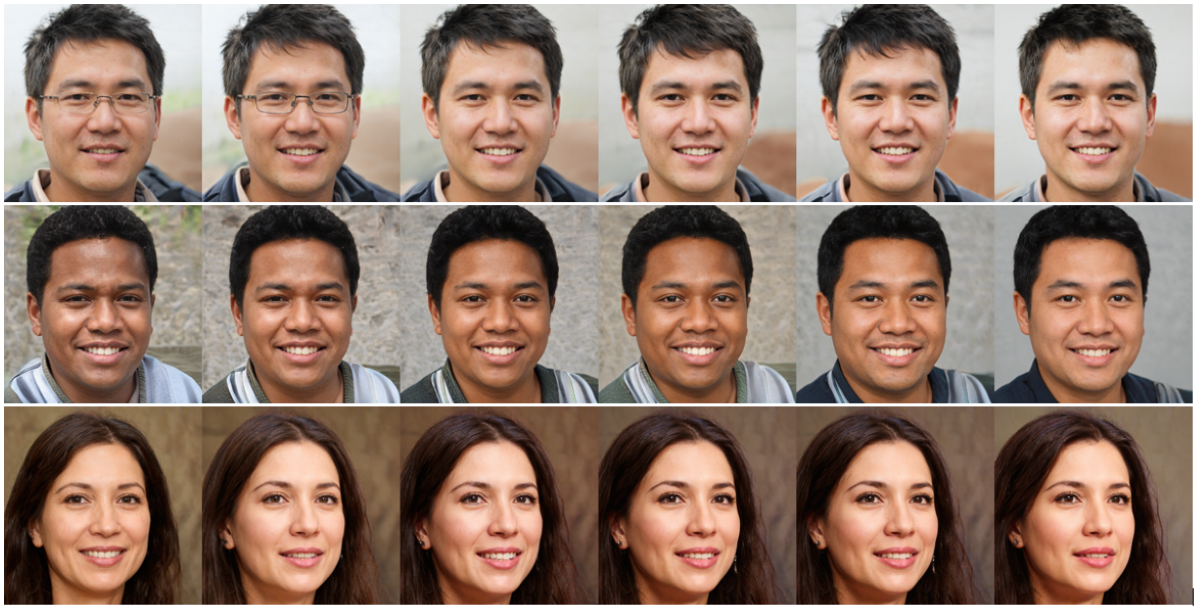

Sikkerheds- og fortrolighedsingeniørstuderende Bogdan Kulynych fik hovedpræmien. Forskeren opdagede, at algoritmen har en tendens til at anvende et “skønhedsfilter”: det favoriserer slankere, yngre ansigter såvel som dem med en lys eller varm hudfarve og glat hudtekstur og stereotypisk feminine ansigtstræk.

“Jeg så meddelelsen på Twitter, og den virkede tæt på mine forskningsinteresser – jeg er i øjeblikket en ph.d. -studerende, og jeg fokuserer på privatliv, sikkerhed, maskinlæring og hvordan de skærer sammen med samfundet,” Kulynych fortæller ZDNet. “Jeg besluttede mig for at deltage og nåede at lægge noget op på en uge.”

Det er ikke en nyhed, at Twitters saltholdighedsalgoritme er problematisk. Sidste år begyndte platformens brugere at bemærke, at teknologien havde en tendens til at vælge hvide mennesker frem for sorte, når de skulle beskære, såvel som mandlige ansigter frem for kvindelige ansigter. Efter at have foretaget nogle egne undersøgelser indrømmede virksomheden, at modellen foretog uretfærdige valg og fjernede saltholdighedsalgoritmen helt og i stedet lancerede en ny måde at vise standardformater i fuld størrelse.

Men i stedet for definitivt at lægge algoritmen væk, besluttede Twitter at gøre modellens kode tilgængelig for forskere for at se, om der kan opstå andre skadelige metoder.

Hvis ideen minder om de bug bounty -programmer, der nu er normen i sikkerhedsbranchen, er det fordi konceptet er baseret på nøjagtig det samme.

Af sikkerhedsmæssige årsager ser bug bounties virksomheder, der opfordrer sikkerhedseksperter til at hjælpe dem med at identificere sårbarheder i deres produkter, før hackere kan udnytte dem til deres fordel. Og inden for AI har eksperter længe tænkt på at omsætte konceptet til at opdage forspændinger i algoritmer.

Twitter er den første virksomhed, der har transformeret konceptet til et virkeligt initiativ, og ifølge Kulynych viser metoden løfte.

“Det lykkedes os at stille noget op på en meget kort periode,” siger Kulynych til ZDNet. “Selvfølgelig betyder det hurtige tempo, at der er mulighed for en falsk positiv. Men i sagens natur er det en god ting, fordi det tilskynder dig til at overflade så mange skader som muligt, så tidligt som muligt.”

Dette står i kontrast til den måde, akademikere hidtil har forsøgt at demonstrere algoritmisk skævhed og skade. Især ved revision af en ekstern virksomheds modeller kan denne proces tage måneder eller endda år, dels fordi forskere ikke har adgang til algoritmens kode. Algoritmen bias bounty-udfordring er derimod et Twitter-ledet initiativ, hvilket betyder, at virksomheden åbnede adgang til modellens kode for deltagere, der ønsker at undersøge.

SE: Kan AI forbedre dine afhentningslinjer?

Det er vigtigt, at den sociale medieplatforms udfordring var den første test i det virkelige liv af et koncept, der hidtil mest har eksisteret i fantasien hos dem, der studerer etisk AI. Og som med de fleste abstrakte ideer var et af de vigtigste stikpunkter, at der ikke findes nogen metode til algoritmiske skævheder. I modsætning til sikkerhedsfejl, der har veletablerede protokoller, regler og standarder, er der ingen bedste praksis, når det kommer til at opdage bias i AI.

Twitter har derfor produceret en industri-first med dybdegående vejledning og metodik for udfordringens deltagere at følge, når de forsøger at identificere potentielle skader, som saltholdighedsalgoritmen kan indføre-og det starter med at definere nøjagtigt hvad der udgør en skade.

“I beskrivelsen af konkurrencen var der en taksonomi af skader, der var virkelig nyttig og temmelig nuanceret,” siger Kulynych. “Det var endnu bredere end traditionelle forestillinger om partiskhed.”

Skaderne, der er defineret af Twitter, har denigration, stereotyper, forkert anerkendelse eller underrepræsentation, men også omdømme, psykologisk eller endog økonomisk skade.

Den sociale medieplatform bad derefter deltagerne om at udføre en blanding af kvalitativ og kvantitativ forskning og at præsentere deres resultater i en read-me-fil, der beskriver deres resultater, sammen med et GitHub-link, der demonstrerer skaden. For at bedømme det mest overbevisende stykke forskning overvejede Twitter kriterier som antallet af berørte brugere eller sandsynligheden for, at skaden opstår.

Kulynych startede med at generere et sæt ansigter ved hjælp af en meget sofistikeret ansigtsgenereringsalgoritme og modificerede derefter lidt af ansigtsegenskaberne for at finde ud af, hvad der mest sandsynligt ville fange opmærksomheden fra saltholdighedsalgoritmen. Han endte med et sæt ansigter, der alle opnåede “maksimal saliency” – og de syntes at afspejle visse skønhedsstandarder, der var indgraveret i modellen.

For eksempel i 37% af tilfældene blev algoritmens opmærksomhed bedre fanget, når huden blev lysere, eller når den blev varmere, mere mættet og mere kontrastrig. I en fjerdedel af sagerne steg saltholdigheden ved at gøre funktioner mere stereotypisk feminine; mens 18% af tiden fik yngre ansigter en bedre afgrøde. Den samme statistik gjaldt for slankere ansigter.

Med andre ord er ansigtsegenskaber, der ikke er i overensstemmelse med visse “skønhed” -standarder, der er fastsat af Twitters algoritme, mindre tilbøjelige til at få fokus, når billederne beskæres.

Selvfølgelig betyder den hurtige vending, at eksperimentet ikke er så stringent som et fuldgyldigt akademisk studie – en lektion, der er lært til fremtidige udfordringer. “For fremtidige virksomheder, der gør dette, tror jeg, at der ville være brug for mere tid til at sammensætte en kvalitetsindsendelse,” siger Kulynych.

Twitter har selv erkendt, at dette kun er et første skridt. Da vi annoncerede udfordringen, sagde virksomhedens produktchef Jutta Williams, at initiativet fulgte med nogle ubekendte, og at læring ville blive anvendt til den næste begivenhed.

SE: Større kvantecomputere, hurtigere: Denne nye idé kunne være den hurtigste vej til virkelige apps

Algoritmisk bias duster er tilsyneladende ved at blive virkelige, og forskere kan kun håbe, at andre teknologivirksomheder vil følge føringen – men med nogle forbehold, siger Kulynych.

“Jeg vil ikke formindske holdets præstationer, denne konkurrence er et stort skridt,” forklarer Kulynych. “Og problemet med algoritmisk bias er meget vigtigt at tage fat på. Jeg tror, at virksomheder incitamenteres til at løse dette problem, hvilket er godt. Men faren her er at glemme alt andet.”

Det vil sige, om algoritmen overhovedet skal eksistere. Nogle modeller har vist sig at generere betydelig skade, uanset om det er fordi de spreder misinformation eller påvirker privatlivets fred. I disse tilfælde bør spørgsmålet ikke være at finde ud af, hvordan algoritmen repareres – men om algoritmen foreviger skade bare ved at eksistere.

Twitter indrammede sin algoritmiske skævhedspræmieudfordring gennem prismen “skader” frem for “bias”; men efterhånden som konceptet vokser, forudser Kulynych muligheden for, at nogle virksomheder gemmer sig bag facaden af en bias -dusør for at legitimere eksistensen af algoritmer, der ved design er skadelige.

For eksempel, selvom et ansigtsgenkendelsessystem skulle være helt upartisk, udelukker det ikke spørgsmålet om, hvorvidt teknologien udgør en privatlivsrisiko for dem, der er udsat for det.

“Det store ved bias er, at det på forhånd antager, at systemet skulle eksistere, og hvis du kun retter bias, så vil alt om systemet være fint,” siger Kulynych. “Det er ikke en ny ting-alle har gjort etikvask og fairness-vask i nogen tid.”

Algoritmiske skævheder blev teoretiseret som en metode, der kunne tjene dem, der var mest påvirket af diskriminerende algoritmiske skader – og de kunne være et stærkt værktøj til at gøre teknologien mere retfærdig, så længe de ikke bliver et andet virksomhedsværktøj i stedet.

Big Data

Hvor er IBMs hybrid cloud -startplade? Syv måder at gøre realtidsteknologi til virkelighed for din organisation Maskinlæring på kanten: TinyML bliver stor Hvad sker der for Cloudera? McDonald's ønsker at 'demokratisere' maskinlæring for alle brugere på tværs af sine aktiviteter

Relaterede emner:

Digital Transformation CXO Internet of Things Innovation Enterprise Software Smart Cities ![]()