< /p > Bild: Apple

När Apple tillkännagav sina planer på att ta itu med övergrepp mot barn på sina operativsystem förra veckan sa det att tröskeln som det ställde in för att inaktivera konto för falska positiva konton skulle vara en i en biljon per år.

Några av hur Apple kom fram till det numret avslöjades i ett dokument [PDF] som gav mer information om systemet.

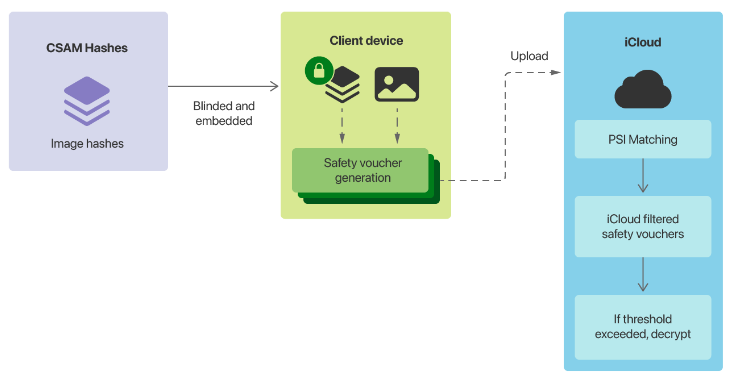

Den mest omtvistade komponenten i Cupertinos planer var dess system för upptäckt av sexuella övergrepp mot barn (CSAM). Det kommer att innebära att Apple -enheter matchar bilder på enheten mot en lista över kända CSAM -bildhashar som tillhandahålls av US National Center for Missing and Exploited Children (NCMEC) och andra barnsäkerhetsorganisationer innan en bild lagras i iCloud.

När en rapporteringströskel uppnås kommer Apple att inspektera metadata som laddas upp tillsammans med de krypterade bilderna i iCloud, och om företaget fastställer att det är CSAM kommer användarens konto att inaktiveras och innehållet överlämnas till NCMEC i USA.

I dokumentet står det att CSAM -hasharna Apple använde skulle vara skärningspunkten mellan två samlingar från två barnsäkerhetsorganisationer som verkar i olika länder.

“Varje perceptuell hash som bara finns i en deltagande barnsäkerhetsorganisations databas, eller bara i databaser från flera byråer i en enda suverän jurisdiktion, kasseras av denna process och ingår inte i den krypterade CSAM -databasen som Apple inkluderar i operativsystemet,” står det i dokumentet.

Efter att ha kört hasherna mot 100 miljoner icke-CSAM-bilder hittade Apple tre falska positiva och noll när det kördes mot en samling vuxenpornografi. Företaget sa att man antog en “värsta fall” -frekvens på en på en miljon, att det ville ha en rapporteringströskel för att säkerställa sin en-i-en-biljon falskt positiva funktionshinder.

“Genom att bygga in en extra säkerhetsmarginal genom att anta att varje iCloud -fotobibliotek är större än det faktiska största, förväntar vi oss att välja en initial matchningströskel på 30 bilder”, stod det.

“Eftersom denna initiala tröskel innehåller en drastisk säkerhetsmarginal som återspeglar ett värsta antagande om verkliga prestanda kan vi ändra tröskeln efter fortsatt empirisk utvärdering av NeuralHash falskt positiva priser-men tröskeln för match kommer aldrig att vara lägre än vad som är krävs för att producera en en-i-en-biljon falsk positiv ränta för ett givet konto. ”

För att säkerställa att Apples iCloud -servrar inte behåller räkningen av antalet positiva CSAM -bilder som en användare har, kommer deras enhet också att producera falska metadata, som Apple kallar säkerhetskuponger. Apple sa att dess servrar inte kommer att kunna skilja riktiga kuponger från de falska innan tröskeln nås.

“Matchningsprocessen på enheten kommer med en viss sannolikhet att ersätta en verklig säkerhetsbevis som genereras med en syntetisk kupong som bara innehåller buller. Denna sannolikhet är kalibrerad för att säkerställa att det totala antalet syntetiska kuponger är proportionellt mot matchningströskeln, “Sade Apple.

“Avgörande är att dessa syntetiska kuponger tillhör varje konto, inte för systemet som helhet. För konton under matchningströskeln är det bara användarens enhet som vet vilka kuponger som är syntetiska. Apples servrar gör inte och kan inte bestämma detta nummer och kan därför inte räkna antalet sanna positiva matchningar. ”

Apple bekräftade också att metadata skulle innehålla en lågupplöst kopia av bilderna för mänsklig inspektion, och dessa kopior körs också mot CSAM-hasharna.

“Denna oberoende hash har valts för att avvisa den osannolika möjligheten att matchningströskeln har överskridits på grund av icke-CSAM-bilder som påverkades negativt för att orsaka falska NeuralHash-matchningar mot den på enheten krypterade CSAM-databasen,” Apple sa.

“Om CSAM -fyndet bekräftas av denna oberoende hash, tillhandahålls de visuella derivaten till Apples mänskliga granskare för slutlig bekräftelse.”

Cupertino sa att systemet var utformat så att en användare inte behöver lita på Apple för att veta att systemet “fungerar som annonserat”.

“Hotmodellen förlitar sig på systemets tekniska egenskaper för att skydda sig mot den osannolika möjligheten att skadliga eller tvingade granskare, och i sin tur förlitar sig på granskarna att skydda sig mot möjligheten till tekniska eller mänskliga fel tidigare i systemet,” sa Apple.

Företaget hävdade att den mänskliga inspektionsprocessen skulle säkerställa att om icke-CSAM-hashar läggs till i rapporteringsuppsättningen, skulle materialet inte skickas vidare från Apple.

“Granskarna bekräftar bara en sak: att för ett konto som överskred matchningströskeln har bilderna som matchar positivt visuella derivat som är CSAM”, stod det.

“Det betyder att om icke-CSAM-bilder någonsin infogades i enhetens perceptuella CSAM-hashdatabas-oavsiktligt eller genom tvång-skulle det inte ha någon effekt om inte Apples mänskliga granskare också informerades om vilka specifika icke-CSAM-bilder de borde flag (för konton som överstiger matchningsgränsen) och tvingades sedan till det. ”

Företaget upprepade att det skulle vägra förfrågningar om att lägga till icke-CSAM-bilder i datamängden.

“Apple kommer också att vägra alla förfrågningar om att instruera mänskliga granskare att lämna in rapporter om allt annat än CSAM -material för konton som överstiger matchningsgränsen”, stod det.

När det gjorde det första tillkännagivandet meddelade Apple också att maskininlärning skulle användas inom iMessage för att varna föräldrar med hjälp av familjedelning när barnkonton har visat eller skickat sexuellt explicita bilder, samt ge varningar till barnet.

“För barnkonton som är 12 år och yngre kommer varje instans av en sexuellt explicit bild som skickas eller tas emot att varna barnet om att om de fortsätter att se eller skicka bilden kommer deras föräldrar att få ett meddelande. Endast om barnet fortsätter med att skicka eller Om du ser en bild efter den här varningen kommer meddelandet att skickas, säger Apple tidigare.

“För barnkonton i åldern 13-17 år varnas barnet fortfarande och frågas om det vill se eller dela en sexuellt explicit bild, men föräldrar meddelas inte.”

I sitt dokument sa Apple att funktionen inte kan aktiveras för vuxenkonton och inte är aktiverad som standard.

I frågan om falska positiva, sa det för barn mellan 13 och 17 år, om en bild är felkategoriserad och ett barn ser den skulle de se något som inte är uttryckligt. För dem under 13 år kan det innebära föräldrakontroll.

“För ett barn under 13 år vars konto är valt för funktionen och vars föräldrar valde att ta emot aviseringar för funktionen, skickar barnet en kontradiktorisk bild eller en som godartat utlöser en falsk positiv klassificering innebär att om de beslutar för att gå igenom båda varningarna kommer de att se något som inte är sexuellt uttryckligt och en avisering kommer att skickas till deras föräldrar, säger Apple.

“Eftersom bilden som utlöste meddelandet finns kvar på barnets enhet kan deras föräldrar bekräfta att bilden inte var sexuellt explicit.”

Apple sa också att det har övervägt frågan om en vuxen som tvingades till ett konto som barn under 13 år, men gav inte någon annan upplösning än att säga att om man inte tittar på bilderna skulle det inte behöva skickas varningar .

“Om funktionen var aktiverad smygande eller skadligt – till exempel i hotmodellen för intim partnerövervakning, genom att tvinga en användare att gå med i Family Sharing med ett konto som är konfigurerat att tillhöra ett barn under 13 år – användaren skulle få en varning när du försöker se eller skicka en sexuellt explicit bild, “stod det.

“Om de väljer att fortsätta, kommer de att få en andra varning som låter dem veta att visning av bilden kommer att resultera i att ett meddelande skickas och ger dem ett annat val om att fortsätta. Om de avböjde att fortsätta, inte heller det faktum att varningar presenterades, eller användarens beslut att avbryta, skickas till någon. ”

Relaterad täckning

Skanning av material för missbruk av barnmissbruk i iOS 15 drar eld Apple vägrar regeringens krav på att utvidga skanning utöver barnmisshandelUS Bill introducerades för att stävja “stor teknisk mobbning” i appbutikutrymmet Forskare upptäcker ny AdLoad kampanjer för skadlig kod som riktar sig till Mac och Apple -produkter

Relaterade ämnen:

Apple Security TV Data Management CXO Data Center ![]()