Toen Apple vorige week zijn plannen aankondigde om materiaal over kindermisbruik op zijn besturingssystemen aan te pakken, zei het dat de drempel die het instelde voor het uitschakelen van valse positieven-accounts één op een biljoen per jaar zou zijn.

Een deel van de manier waarop Apple tot dat aantal kwam, werd onthuld in een document [PDF] dat meer details over het systeem verschafte.

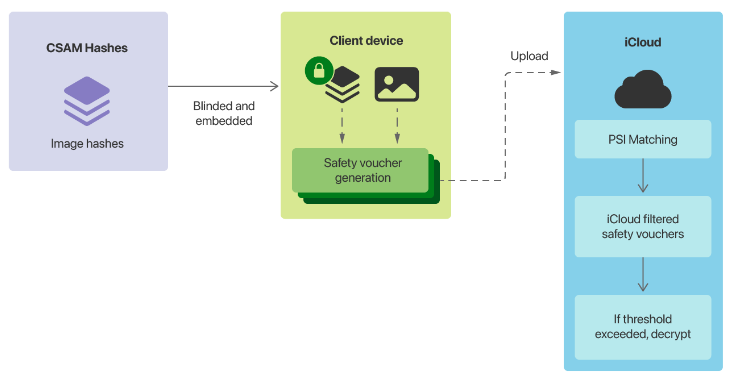

Het meest controversiële onderdeel van Cupertino's plannen was het on-device detectiesysteem voor materiaal voor seksueel misbruik van kinderen (CSAM). Het gaat om Apple-apparaten die afbeeldingen op het apparaat matchen met een lijst met bekende CSAM-afbeeldingshashes die zijn verstrekt door het Amerikaanse National Center for Missing and Exploited Children (NCMEC) en andere kinderveiligheidsorganisaties voordat een afbeelding wordt opgeslagen in iCloud.

Wanneer een rapportagedrempel is bereikt, inspecteert Apple de metadata die samen met de versleutelde afbeeldingen in iCloud zijn geüpload, en als het bedrijf vaststelt dat het CSAM is, wordt het gebruikersaccount uitgeschakeld en wordt de inhoud overgedragen aan NCMEC in de VS.

In het document staat dat de CSAM-hashes die Apple gebruikte de kruising zouden zijn van twee collecties van twee kinderveiligheidsorganisaties die in verschillende landen actief zijn.

“Alle perceptuele hashes die voorkomen in de database van één deelnemende organisatie voor kinderveiligheid, of alleen in databases van meerdere instanties in één soevereine jurisdictie, worden door dit proces weggegooid en niet opgenomen in de versleutelde CSAM-database die Apple in het besturingssysteem opneemt,” het document vermeldt.

Na het uitvoeren van de hashes tegen 100 miljoen niet-CSAM-afbeeldingen, vond Apple drie valse positieven, en nul bij het uitvoeren van een verzameling porno voor volwassenen. Het bedrijf zei dat het, uitgaande van een “worst-case” foutenpercentage van één op één miljoen, een rapportagedrempel wilde om de vals-positieve uitschakelingsdrempel van één op een biljoen te waarborgen.

“Door een extra veiligheidsmarge in te bouwen door aan te nemen dat elke iCloud-fotobibliotheek groter is dan de werkelijke grootste, verwachten we een initiële overeenkomstdrempel van 30 afbeeldingen te kiezen”, aldus het.

“Aangezien deze initiële drempel een drastische veiligheidsmarge bevat die een worst-case aanname over de prestaties in de echte wereld weerspiegelt, kunnen we de drempel wijzigen na voortdurende empirische evaluatie van NeuralHash-vals-positieve percentages – maar de overeenkomstdrempel zal nooit lager zijn dan wat is vereist om een één-op-één-biljoen valse positieven te produceren voor een bepaald account.”

Om ervoor te zorgen dat de iCloud-servers van Apple het aantal positieve CSAM-afbeeldingen van een gebruiker niet bijhouden, produceert hun apparaat ook valse metadata, die Apple veiligheidsvouchers noemt. Apple zei dat zijn servers geen echte vouchers van nep kunnen onderscheiden totdat de drempel is bereikt.

“Het matchproces op het apparaat zal, met een zekere waarschijnlijkheid, een echte veiligheidsvoucher die wordt gegenereerd vervangen door een synthetische voucher die alleen ruis bevat. Deze waarschijnlijkheid is gekalibreerd om ervoor te zorgen dat het totale aantal synthetische vouchers evenredig is met de matchdrempel, ’, aldus Appel.

“Cruciaal is dat deze synthetische vouchers eigendom zijn van elk account, niet van het systeem als geheel. Voor accounts onder de matchdrempel weet alleen het apparaat van de gebruiker welke vouchers synthetisch zijn; de servers van Apple weten dat niet en kan dit aantal niet bepalen en kan daarom het aantal echte positieve overeenkomsten niet tellen.”

Apple heeft ook bevestigd dat de metadata een kopie met een lage resolutie van de afbeeldingen zouden bevatten voor menselijke inspectie, en deze kopieën worden ook uitgevoerd tegen de CSAM-hashes.

“Deze onafhankelijke hash is gekozen om de onwaarschijnlijke mogelijkheid te verwerpen dat de overeenkomstdrempel werd overschreden als gevolg van niet-CSAM-afbeeldingen die adversarieel werden verstoord om valse NeuralHash-overeenkomsten te veroorzaken met de op het apparaat versleutelde CSAM-database,” Apple zei.

“Als de CSAM-bevinding wordt bevestigd door deze onafhankelijke hash, worden de visuele afgeleiden verstrekt aan menselijke Apple-recensenten voor definitieve bevestiging.”

Cupertino zei dat het systeem zo is ontworpen dat een gebruiker Apple niet hoeft te vertrouwen om te weten dat het systeem “werkt zoals geadverteerd”.

“Het dreigingsmodel vertrouwt op de technische eigenschappen van het systeem om te beschermen tegen de onwaarschijnlijke mogelijkheid van kwaadwillende of gedwongen reviewers, en vertrouwt op zijn beurt op de reviewers om te waken tegen de mogelijkheid van technische of menselijke fouten eerder in het systeem”, aldus Apple.

Het bedrijf beweerde dat het menselijke inspectieproces ervoor zou zorgen dat als niet-CSAM-hashes aan de rapportageset zouden worden toegevoegd, het materiaal niet door Apple zou worden doorgegeven.

“De recensenten bevestigen slechts één ding: dat voor een account dat de overeenkomstdrempel overschrijdt, de positief overeenkomende afbeeldingen visuele afgeleiden hebben die CSAM zijn,” zei het.

“Dit betekent dat als niet-CSAM-afbeeldingen ooit zouden worden ingevoegd in de perceptuele CSAM-hashdatabase op het apparaat – per ongeluk of onder dwang – er geen effect zou zijn tenzij de menselijke recensenten van Apple ook zouden worden geïnformeerd welke specifieke niet-CSAM-afbeeldingen ze zouden moeten vlag (voor accounts die de overeenkomstdrempel overschrijden), en werden vervolgens gedwongen om dit te doen.”

Het bedrijf herhaalde dat het verzoeken om niet-CSAM-afbeeldingen aan de dataset toe te voegen, zou weigeren.

“Apple zal ook alle verzoeken weigeren om menselijke reviewers te instrueren om rapporten in te dienen voor iets anders dan CSAM-materiaal voor accounts die de overeenkomstdrempel overschrijden”, aldus het.

Toen het de eerste aankondiging deed, kondigde Apple ook aan dat machine learning binnen iMessage zou worden gebruikt om ouders die gebruikmaken van gezinsdeling te waarschuwen wanneer kinderaccounts seksueel expliciete afbeeldingen hebben bekeken of verzonden, en om het kind te waarschuwen.

“Voor kinderaccounts van 12 jaar en jonger zal elk verzonden of ontvangen exemplaar van een seksueel expliciete afbeelding het kind waarschuwen dat als ze de afbeelding blijven bekijken of verzenden, hun ouders een melding krijgen. Alleen als het kind doorgaat met het verzenden of verzenden van de afbeelding. het bekijken van een afbeelding na deze waarschuwing wordt de melding verzonden”, zei Apple eerder.

“Voor kinderaccounts van 13-17 jaar wordt het kind nog steeds gewaarschuwd en gevraagd of het een seksueel expliciete afbeelding wil bekijken of delen, maar ouders worden niet op de hoogte gebracht.”

In zijn document zei Apple dat de functie niet kan worden ingeschakeld voor accounts voor volwassenen en niet standaard is ingeschakeld.

Over de kwestie van valse positieven zei het dat in het geval van kinderen van 13 tot 17 jaar, als een afbeelding verkeerd is gecategoriseerd en een kind het bekijkt, ze iets zouden zien dat niet expliciet is. Voor degenen onder de 13 jaar kan het gaan om ouderlijke inspectie.

“Voor een kind jonger dan 13 jaar wiens account is aangemeld voor de functie en wiens ouders ervoor hebben gekozen om meldingen voor de functie te ontvangen, betekent het sturen van een vijandige afbeelding of een afbeelding die goedaardig een vals-positieve classificatie veroorzaakt, dat, als ze besluiten om door beide waarschuwingen heen te gaan, zullen ze iets zien dat niet seksueel expliciet is en wordt er een melding naar hun ouders gestuurd”, aldus Apple.

“Omdat de foto die de melding heeft geactiveerd, wordt bewaard op het apparaat van het kind, kunnen de ouders bevestigen dat de afbeelding niet seksueel expliciet was.”

Apple zei ook dat het de kwestie heeft overwogen van een volwassene die als kind onder de 13 jaar op een account wordt gedwongen, maar heeft geen andere oplossing geboden dan te stellen dat het niet bekijken van de afbeeldingen geen waarschuwingen zou doen uitgaan .

“Als de functie heimelijk of kwaadwillig is ingeschakeld, bijvoorbeeld in het Intimate Partner Surveillance-bedreigingsmodel, door een gebruiker te dwingen deel te nemen aan Family Sharing met een account dat is geconfigureerd als behorend tot een kind jonger dan 13 jaar, kan de gebruiker zou een waarschuwing krijgen wanneer ze een seksueel expliciete afbeelding proberen te bekijken of te verzenden”, aldus het.

“Als ze ervoor kozen om door te gaan, zouden ze een tweede waarschuwing krijgen om hen te laten weten dat het bekijken van de afbeelding zal resulteren in een melding en hen een andere keuze geeft om door te gaan. Als ze weigeren verder te gaan, noch het feit dat de waarschuwingen werden gepresenteerd, noch de beslissing van de gebruiker om te annuleren, worden naar niemand verzonden.”

Gerelateerde dekking

Scannen van materiaal voor kindermisbruik door Apple in iOS 15 trekt vuur aanApple weigert overheidseisen om scannen uit te breiden tot buiten kindermishandeling Amerikaanse wet geïntroduceerd om 'big tech pesten' in de app store-ruimte te beteugelen Onderzoekers ontdekken nieuwe AdLoad malwarecampagnes gericht op Macs en Apple-producten

gerelateerde onderwerpen:

Apple Security TV Data Management CXO-datacenters ![]()