< /p > Bilde: Apple

Da Apple kunngjorde sine planer om å håndtere overgrep mot barn på operativsystemene i forrige uke, sa det at terskelen den satte for falske positive kontodeaktiveringer ville være én av en billion per år.

Noen av virkemåten for hvordan Apple kom frem til dette nummeret ble avslørt i et dokument [PDF] som ga flere detaljer om systemet.

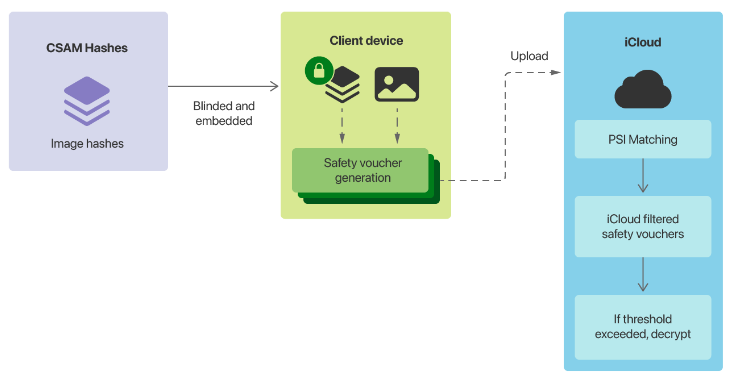

Den mest omstridte komponenten i Cupertinos planer var dets system for påvisning av seksuelle overgrep mot barn (CSAM). Det vil involvere Apple -enheter som matcher bilder på enheten mot en liste over kjente CSAM -bildeaviser levert av US National Center for Missing and Exploited Children (NCMEC) og andre barnesikkerhetsorganisasjoner før et bilde lagres i iCloud.

Når en rapporteringsgrense er nådd, vil Apple inspisere metadata lastet opp sammen med de krypterte bildene i iCloud, og hvis selskapet bestemmer at det er CSAM, vil brukerens konto bli deaktivert og innholdet overlevert til NCMEC i USA.

Dokumentet sier at CSAM -hashene Apple brukte ville være skjæringspunktet mellom to samlinger fra to barnesikkerhetsorganisasjoner som opererer i forskjellige land.

“Enhver perseptuell hash som bare vises i en deltakende barnesikkerhetsorganisasjons database, eller bare i databaser fra flere byråer i en enkelt suveren jurisdiksjon, blir kassert av denne prosessen og ikke inkludert i den krypterte CSAM -databasen som Apple inkluderer i operativsystemet,” står det i dokumentet.

Etter å ha kjørt hasjene mot 100 millioner ikke-CSAM-bilder, fant Apple tre falske positiver, og null når den ble kjørt mot en samling voksenpornografi. Selskapet sa at forutsatt at det var en “verst tenkelig” feilprosent på én av en million, ønsket det en rapporteringsterskel for å sikre sin en-i-en-billion trusler med falsk positiv deaktivering.

“Ved å bygge inn en ekstra sikkerhetsmargin ved å anta at hvert iCloud -fotobibliotek er større enn det faktisk største, forventer vi å velge en innledende matchterskel på 30 bilder,” heter det.

“Siden denne første terskelen inneholder en drastisk sikkerhetsmargin som gjenspeiler en verst tenkt antagelse om virkelige prestasjoner, kan vi endre terskelen etter fortsatt empirisk evaluering av NeuralHash falsk-positive priser-men kampgrensen vil aldri være lavere enn det som er nødvendig for å produsere en en-i-en-billion billioner falsk positiv rate for en gitt konto. ”

For å sikre at Apples iCloud -servere ikke beholder antall positive CSAM -bilder en bruker har, vil enheten også produsere falske metadata, som Apple kaller sikkerhetskuponger. Apple sa at serverne ikke vil kunne skille ekte bilag fra de falske før terskelen er nådd.

“Matchingsprosessen på enheten vil med en viss sannsynlighet erstatte en ekte sikkerhetskupong som genereres med en syntetisk bilag som bare inneholder støy. Denne sannsynligheten er kalibrert for å sikre at det totale antallet syntetiske bilag er proporsjonalt med kampgrensen, “Uttalte Apple.

“Avgjørende er at disse syntetiske bilagene er en eiendom for hver konto, ikke for systemet som helhet. For kontoer under samsvarsterskelen er det bare brukerens enhet som vet hvilke bilag som er syntetiske. Apples servere gjør ikke og kan ikke bestemme dette tallet, og kan derfor ikke telle antall sanne positive treff. ”

Apple bekreftet også at metadataene vil inneholde en lavoppløselig kopi av bildene for menneskelig inspeksjon, og disse kopiene kjøres også mot CSAM-hashene.

“Denne uavhengige hashen er valgt for å avvise den usannsynlige muligheten for at kampgrensen ble overskredet på grunn av ikke-CSAM-bilder som var forstyrret for å forårsake falske NeuralHash-treff mot den på enheten krypterte CSAM-databasen,” Apple sa.

“Hvis CSAM -funnet blir bekreftet av denne uavhengige hashen, blir de visuelle derivatene levert til Apple -menneskelige granskere for endelig bekreftelse.”

Cupertino sa at systemet var designet slik at en bruker ikke trenger å stole på Apple for å vite at systemet “fungerer som annonsert”.

“Trusselmodellen er avhengig av de tekniske egenskapene til systemet for å beskytte seg mot den usannsynlige muligheten for ondsinnede eller tvangsmessige korrekturlesere, og i sin tur avhengig av korrekturleserne for å beskytte seg mot muligheten for tekniske eller menneskelige feil tidligere i systemet,” sa Apple.

Selskapet fastholdt at den menneskelige inspeksjonsprosessen ville sikre at hvis ikke-CSAM-hash ble lagt til i rapporteringssettet, ville materialet ikke bli sendt videre fra Apple.

“Anmelderne bekrefter bare én ting: At for en konto som overskred terskelen for samsvar, har bildene med positiv samsvar visuelle derivater som er CSAM,” sto det.

“Dette betyr at hvis ikke-CSAM-bilder noen gang ble satt inn i den perseptuelle CSAM-hashdatabasen på enheten-utilsiktet eller gjennom tvang-ville det ikke ha noen effekt med mindre Apples menneskelige anmeldere også ble informert om hvilke spesifikke ikke-CSAM-bilder de burde flag (for kontoer som overstiger samsvarsterskelen), og ble deretter tvunget til å gjøre det. ”

Selskapet gjentok at det ville nekte forespørsler om å legge til ikke-CSAM-bilder i datasettet.

“Apple vil også nekte alle forespørsler om å instruere menneskelige korrekturlesere om å sende inn rapporter for annet enn CSAM -materiale for kontoer som overstiger terskelgrensen”, heter det.

Da Apple kunngjorde den første kunngjøringen, kunngjorde Apple også maskinlæring i iMessage for å varsle foreldre ved bruk av familiedeling når barnekontoer har sett eller sendt seksuelt eksplisitte bilder, samt gi advarsler til barnet.

“For barnekontoer som er 12 år og yngre, vil hver forekomst av et seksuelt eksplisitt bilde sendt eller mottatt advare barnet om at hvis de fortsetter å se eller sende bildet, vil foreldrene bli sendt et varsel. Bare hvis barnet fortsetter med å sende eller Hvis du ser et bilde etter denne advarselen, blir varselet sendt, “sa Apple tidligere.

“For barnekontoer i alderen 13-17 år blir barnet fortsatt advart og spurt om de ønsker å se eller dele et seksuelt eksplisitt bilde, men foreldre blir ikke varslet.”

I dokumentet sa Apple at funksjonen ikke kan aktiveres for voksne kontoer, og at den ikke er aktivert som standard.

På spørsmålet om falske positiver sa det for barn i alderen 13 til 17 år, hvis et bilde er feilkategorisert og et barn ser det, ville de se noe som ikke er eksplisitt. For de under 13 år kan det innebære foreldresyn.

“For et barn under 13 år hvis konto er valgt for funksjonen, og hvis foreldre valgte å motta varsler for funksjonen, sender barnet et motbydelig bilde eller et som godartet utløser en falsk positiv klassifisering, betyr at hvis de bestemmer seg for å fortsette gjennom begge advarslene, vil de se noe som ikke er seksuelt eksplisitt, og et varsel vil bli sendt til foreldrene deres, sier Apple.

“Fordi bildet som utløste varselet er bevart på barnets enhet, kan foreldrene bekrefte at bildet ikke var seksuelt eksplisitt.”

Apple sa også at det har vurdert spørsmålet om at en voksen ble tvunget til en konto som barn under 13 år, men ga ikke en annen løsning enn å si at det ikke ville bli sendt varsler til å se på bildene. .

“Hvis funksjonen ble aktivert skjult eller ondsinnet – for eksempel i trusselmodellen Intimate Partner Surveillance, ved å tvinge en bruker til å bli med i Family Sharing med en konto som er konfigurert til å tilhøre et barn under 13 år – brukeren vil motta en advarsel når du prøver å se eller sende et seksuelt eksplisitt bilde, “sto det.

“Hvis de valgte å fortsette, ville de bli gitt en annen advarsel om å fortelle dem at visning av bildet vil resultere i at en melding blir sendt, og gi dem et annet valg om de skal fortsette. Hvis de nektet å fortsette, verken det faktum at advarsler ble presentert, og heller ikke brukerens beslutning om å avbryte, blir sendt til noen. ”

Relatert dekning

Apples skanning av barnemishandling fra barn i iOS 15 trekker ild Apple nekter regjeringens krav om å utvide skanning utover barnemishandling USAs lovforslag ble introdusert for å dempe 'stor teknisk mobbing' i appbutikkområdet Forskere oppdager ny AdLoad kampanjer mot skadelig programvare som er rettet mot Mac og Apple -produkter

Relaterte emner:

Apple Security TV Data Management CXO datasentre ![]()