Cerebras voegde aan zijn eerder aangekondigde CS-2 AI-computer een nieuw switchproduct toe, de SwarmX, dat zowel routering als berekeningen doet, en een geheugencomputer met 2,4 petabyte aan DRAM en NAND, MemoryX genaamd.

Cerebras Systems

figuur>

Kunstmatige intelligentie in zijn diepe leervorm produceert neurale netwerken die biljoenen en biljoenen neurale gewichten of parameters zullen hebben, en de toenemende schaal levert speciale problemen op voor de hardware en software die worden gebruikt om dergelijke neurale netwerken te ontwikkelen.

“In twee jaar tijd werden modellen duizend keer groter en hadden ze duizend keer meer rekenkracht nodig”, zegt Andrew Feldman, mede-oprichter en CEO van AI-systeemmaker Cerebras Systems, die de recente geschiedenis van neurale netwerken samenvat in een interview met ZDNet via Zoom.

“Dat is een zwaar traject”, zegt Feldman.

Het bedrijf van Feldman onthult deze week nieuwe computers op de jaarlijkse Hot Chips computerchipconferentie voor geavanceerd computergebruik. De conferentie wordt dit jaar virtueel gehouden. Cerebras heeft een persbericht uitgegeven waarin de nieuwe computers worden aangekondigd.

Cerebras, dat concurreert met de AI-leider, Nvidia, en met andere AI-startups, zoals Graphcore en SambaNova Systems, wil voorop lopen in prestaties bij het trainen van die steeds grotere netwerken. Training is de fase waarin een neuraal netprogramma wordt ontwikkeld door het te onderwerpen aan grote hoeveelheden gegevens en de neurale netgewichten af te stemmen totdat ze de hoogst mogelijke nauwkeurigheid opleveren.

Ook: 'We kunnen dit probleem oplossen in een tijd die geen enkel aantal GPU's of CPU's kan bereiken', zegt startup Cerebras tegen de supercomputingconferentie

Het is geen geheim dat neurale netwerken groeien gestaag in omvang. In het afgelopen jaar, wat 's werelds grootste neurale netwerk was geweest, gemeten door neurale gewichten, werd het GPT-3 natuurlijke taalverwerkingsprogramma van OpenAI, met 175 miljard gewichten, overschaduwd door Google's 1,6-biljoen-parametermodel, de Switch Transformer.

Zulke enorme modellen komen in de problemen omdat ze de grenzen van een enkel computersysteem overstijgen. Het geheugen van een enkele GPU, in de orde van grootte van 16 gigabyte, wordt overspoeld door mogelijk honderden terabytes aan geheugen dat nodig is voor een model als GPT-3. Daarom wordt clustering van systemen cruciaal.

En hoe te clusteren wordt het cruciale punt, omdat elke machine bezig moet blijven, anders daalt de bezettingsgraad. Dit jaar hebben Nvidia, Stanford en Microsoft bijvoorbeeld een versie van GPT-3 gemaakt met één biljoen parameters, en deze hebben ze uitgerekt over 3.072 GPU's. Maar het gebruik, dat wil zeggen het aantal bewerkingen per seconde, was slechts 52% van de piekbewerkingen waartoe de machines theoretisch in staat zouden moeten zijn.

Vandaar dat het probleem dat Feldman en Cerebras willen oplossen, is om met grotere en grotere netwerken om te gaan op een manier die een beter gebruik van elk computerelement oplevert, en daardoor leidt tot betere prestaties, en bij uitbreiding, betere energiegebruik.

De nieuwe computers bestaan uit drie delen die met elkaar samenwerken. Een daarvan is een update van de computer van het bedrijf die de Wafer-Scale Engine of WSE-chip bevat, de grootste chip ooit gemaakt. Dat systeem heet de CS-2. Zowel WSE2 als CS-2 werden in april geïntroduceerd.

Ook: Cerebras zet 'absolute dominantie' van high-end computing voort, zegt het, met 's werelds grootste chip two-dot-oh

Cerebras Systems productmanager voor AI Natalia Vassilieva bezit de WSE-2 van het bedrijf, een enkele chip die bijna het gehele oppervlak van een twaalf-inch halfgeleiderwafer meet. De chip werd voor het eerst onthuld in april en vormt het hart van de nieuwe CS-2-machine, de tweede versie van het bedrijf van zijn speciale AI-computer.

Cerebras Systems

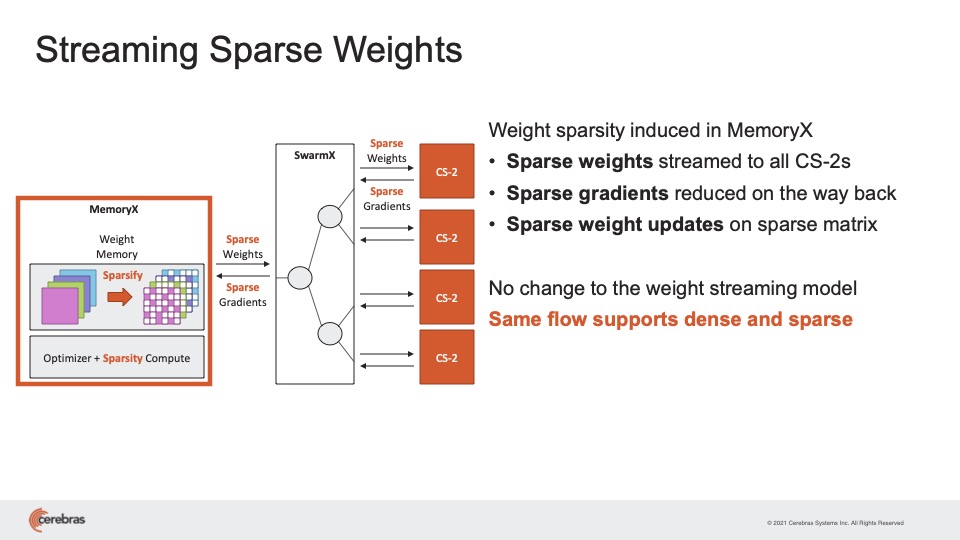

De nieuwe elementen deze week zijn een in een rek gemonteerde doos genaamd MemoryX, die 2,4 petabyte bevat gecombineerd met DRAM- en NAND-flashgeheugen, om alle gewichten van het neurale netwerk op te slaan. Een derde doos is een zogenaamde stofmachine die de CS-2 verbindt met de MemoryX, genaamd SwarmX. De fabric kan maar liefst 192 CS-2-machines verbinden met de MemoryX om een cluster te bouwen dat samenwerkt op één groot neuraal netwerk.

Parallelle verwerking van grote problemen is er meestal in twee soorten, data parallel of model parallel.

Tot op heden heeft Cerebras modelparallellisme uitgebuit, waarbij de neurale netwerklagen zijn verdeeld over verschillende delen van de massieve chip, zodat lagen en hun gewichten parallel lopen. De Cerebras-software beslist automatisch hoe lagen worden verdeeld over delen van de chip, en sommige lagen kunnen meer chipoppervlak krijgen dan andere.

Neurale gewichten, of parameters, zijn matrices, meestal weergegeven door vier bytes per gewicht, dus de gewichtsopslag is in feite een veelvoud van vier keer, ongeacht het totale aantal gewichten. Voor GPT-3, dat 175 miljard parameters heeft, zou de totale oppervlakte van het gehele neurale netwerk 700 gigabyte zijn.

Een enkele CS-1 kan alle parameters van een klein of middelgroot netwerk bevatten of alle van een bepaalde laag van een groot model zoals GPT-3, zonder naar extern geheugen te hoeven bladeren vanwege het grote on-chip SRAM van 18 gigabyte.

“De grootste laag in GPT-3 is ongeveer 12.000 x 48.000 elementen”, zei Feldman, sprekend over de afmetingen van een enkele gewichtsmatrix. “Dat past makkelijk op een enkele WSE-2.”

In de nieuwe WSE2-chip, die het SRAM-geheugen opvoert tot 40 gigabyte, kan een enkele CS-2-machine alle parameters bevatten die zouden worden gebruikt voor een bepaalde laag van een neuraal netwerk met 120 biljoen parameters, zegt Cerebras. “Bij hot chips laten we matrixvermenigvuldigingen zien van 48.000 x 48.000, twee keer zo groot als GPT-3”, merkt hij op.

In combinatie met de MemoryX kan de enkele CS-2 in de streamingbenadering alle modelgewichten verwerken terwijl ze laag voor laag naar de machine worden gestreamd.

Het bedrijf noemt dat graag 'brain-scale computing', naar analogie van de 100 biljoen synapsen in het menselijk brein.

Het neuraal netwerk met 120 biljoen parameters is in dit geval een synthetisch neuraal netwerk dat intern door Cerebras is ontwikkeld voor testdoeleinden, geen gepubliceerd neuraal netwerk.

Hoewel de CS-2 al die laagparameters in één machine kan bevatten, biedt Cerebras nu aan om MemoryX te gebruiken om dataparallellisme te bereiken. Gegevensparallellisme is het tegenovergestelde van modelparallellisme, in die zin dat elke machine dezelfde set gewichten heeft, maar een ander deel van de gegevens om aan te werken.

Om dataparallellisme te bereiken, bewaart Cerebras alle gewichten in MemoryX en zendt vervolgens die gewichten selectief uit naar de CS-2's, waar alleen het individuele gegevenssegment wordt opgeslagen.

Elke CS-2, wanneer het de streaminggewichten ontvangt, past die gewichten toe op de invoergegevens en geeft het resultaat vervolgens door de activeringsfunctie, een soort filter dat ook op de chip is opgeslagen, dat controleert de gewogen invoer om te zien of een drempel is bereikt.

Het eindresultaat van dat alles is het verloop, een kleine aanpassing van de gewichten, die vervolgens wordt teruggestuurd naar de MemoryX-box waar het wordt gebruikt om de hoofdlijst met gewichten bij te werken. De SwarmX doet al het heen en weer routeren tussen MemoryX en CS-2, maar het doet ook iets meer.

“De SwarmX doet zowel communicatie als berekening”, legt Feldman uit. “De SwarmX-stof combineert de gradiënten, een reductie genoemd, wat betekent dat het een bewerking als een gemiddelde uitvoert.”

En het resultaat, zegt Feldman, is een enorm hoger gebruik van de CS-2 in vergelijking met de concurrentie, zelfs op de huidige neurale netwerken zoals GPT-3.

“Het gebruik van andere mensen is 10% of 20%, maar we zien een gebruik tussen 70% en 80% op de grootste netwerken – dat is ongehoord”, zegt Feldman. De toevoeging van systemen biedt wat hij 'lineaire prestatieschaling' noemde, wat betekent dat, als zestien systemen worden toegevoegd, de snelheid om een neuraal net te trainen zestien keer sneller wordt.

Als resultaat, “Vandaag de dag vervangt elke CS2 honderden GPU's, en we kunnen nu duizenden GPU's vervangen” met de geclusterde aanpak, zei hij.

Cerebras beweert dat de geclusterde machines lineaire schaling produceren, wat betekent dat voor elk aantal machines dat wordt toegevoegd, de snelheid om een netwerk te trainen met een overeenkomstig veelvoud toeneemt.

Cerebras Systems

Parallisme leidt tot een bijkomend voordeel, zegt Cerebras, en dat is wat sparsity wordt genoemd.

Vanaf het begin heeft Cerebras betoogd dat Nvidia GPU's enorm inefficiënt zijn vanwege hun gebrek aan geheugen. De GPU moet naar het hoofdgeheugen, DRAM, gaan, wat kostbaar is, dus haalt het gegevens op in verzamelingen die batches worden genoemd. Maar dat betekent dat de GPU mogelijk werkt op gegevens met een nulwaarde, wat zonde is. En het betekent ook dat de gewichten niet zo vaak worden bijgewerkt terwijl ze wachten tot elke batch is verwerkt.

De WSE, omdat het die enorme hoeveelheid on-chip SRAM heeft, is in staat om individuele datasamples te trekken, een batch van één, zoals het wordt genoemd, en werkt op veel van dergelijke individuele samples parallel over de hele wereld. chippen. En met elk afzonderlijk monster is het, nogmaals, met snel geheugen mogelijk om alleen aan bepaalde gewichten te werken en deze selectief en vaak bij te werken.

Het bedrijf stelt – in formeel onderzoek en in een blogpost van productmanager voor AI Natalia Vassilieva – dat schaarste allerlei voordelen met zich meebrengt. Het zorgt voor een efficiënter geheugengebruik en zorgt voor dynamische parallellisatie, en het betekent dat backpropagation, een achterwaartse doorgang door de neurale gewichten, kan worden gecomprimeerd tot een efficiënte pijplijn die dingen verder parallelliseert en de training versnelt. Dat is een idee dat in het algemeen in toenemende mate in het veld lijkt te interesseren.

Toen het tijd werd om over te stappen naar een geclusterd systeem, kwam Cerebras weer met een spaarzame aanpak. Slechts enkele gewichten hoeven vanuit de MemoryX naar elke CS-2 te worden gestreamd en slechts enkele gradiënten hoeven naar de MemoryX te worden teruggestuurd.

Met andere woorden, Cerebras beweert dat zijn systeemnetwerk, bestaande uit computer, switch en geheugenopslag, zich gedraagt als een grote versie van de schaarse rekenkracht die op een enkele WSE-chip plaatsvindt.

In combinatie met de streamingbenadering heeft de schaarste in de CS-2, samen met MemoryX en SwarmX, een flexibele, dynamische component die volgens het bedrijf niet kan worden geëvenaard door andere machines.

“Elke laag kan een ander dun masker hebben,” zei Feldman, “dat we per tijdperk een andere sparsity kunnen geven, en tijdens de training kunnen we de sparsity veranderen, inclusief sparsity die kan profiteren van wat er is geleerd tijdens de training, dynamische sparsity genoemd – niemand anders kan dat.

Het toevoegen van schaarste aan dataparallelisme, zegt Feldman, zorgt voor een orde van grootte versnelling in de tijd om grote netwerken te trainen.

Cerebras pleit voor intensief en flexibel gebruik van de techniek die bekend staat als sparsity om extra prestatievoordelen te bieden.

Cerebras Systems

Natuurlijk, de kunst om veel meer CS-2-machines te verkopen, samen met de nieuwe apparaten , zal afhangen van de vraag of de markt klaar is voor multi-biljoenen of multi-tientallen-biljoenen-gewicht neurale netwerken. De CS-2 en de andere componenten worden naar verwachting in het vierde kwartaal van dit jaar verzonden, dus over een paar maanden.

Bestaande klanten lijken geïnteresseerd. Argonne National Laboratories, een van de negen gigantische supercomputercentra van het Amerikaanse ministerie van Energie, is sinds het begin een gebruiker van het CS-1-systeem. Hoewel het lab nog niet met de CS-2 en de andere componenten werkt, zijn de onderzoekers enthousiast.

“De afgelopen jaren hebben ons laten zien dat, voor NLP-modellen [natuurlijke taalverwerking], inzichten direct worden geschaald met parameters – hoe meer parameters, hoe beter de resultaten”, zegt Rick Stevens, de medewerker directeur van Argonne, in een voorbereide verklaring.

Ook: 'We doen over een paar maanden wat normaal gesproken jaren nodig zou zijn voor een medicijnontwikkelingsproces': DoE's Argonne Labs bestrijdt COVID-19 met AI

“De uitvindingen van Cerebras, die een 100x grotere parametercapaciteit zullen opleveren, hebben mogelijk het potentieel om de industrie te transformeren”, aldus Stevens. “Voor de eerste keer zullen we in staat zijn om hersengrote modellen te verkennen, waardoor enorme nieuwe wegen van onderzoek en inzicht worden geopend.”

Op de vraag of de tijd rijp is voor zulke pk's, merkte Feldman op: “Niemand legt matzah in de schappen in januari”, verwijzend naar het traditionele ongezuurde brood dat alleen wordt gevuld wanneer het nodig is, net voor het Pesachfeest in de lente.

De tijd voor enorme clusters van AI-machines is aangebroken, zei Feldman.

“Dit is geen matzah in januari”, zei hij.

moet lezen

Ethiek van AI: voordelen en risico's van kunstmatige intelligentie

De toenemende schaal van AI verhoogt de inzet voor belangrijke ethische vragen .

Lees meer

Verwante onderwerpen:

Hardware Digitale transformatie CXO Internet of Things Innovatie Enterprise Software