Cerebras ha aggiunto al suo computer CS-2 AI annunciato in precedenza con un nuovo prodotto switch, lo SwarmX, che esegue il routing ma anche i calcoli, e un computer con memoria contenente 2,4 petabyte di DRAM e NAND, chiamato MemoryX.

Cerebras Systems

L'intelligenza artificiale nella sua forma di apprendimento profondo sta producendo reti neurali che avranno trilioni e trilioni di pesi neurali, o parametri, e la scala crescente presenta problemi speciali per l'hardware e il software utilizzati per sviluppare tali reti neurali.

“In due anni, i modelli sono diventati mille volte più grandi e hanno richiesto mille volte più risorse di calcolo”, afferma Andrew Feldman, co-fondatore e CEO del produttore di sistemi di intelligenza artificiale Cerebras Systems, riassumendo la storia recente delle reti neurali in un'intervista con ZDNet tramite Zoom.

“Questa è una traiettoria difficile”, afferma Feldman.

L'azienda di Feldman questa settimana sta svelando nuovi computer alla conferenza annuale sui chip per computer Hot Chips per l'elaborazione avanzata. La conferenza si terrà virtualmente quest'anno. Cerebras ha emesso un comunicato stampa che annuncia i nuovi computer.

Cerebras, che compete con il leader dell'intelligenza artificiale, Nvidia, e con altre startup di intelligenza artificiale, come Graphcore e SambaNova Systems, mira a guidare le prestazioni durante la formazione di reti sempre più grandi. L'addestramento è la fase in cui viene sviluppato un programma di rete neurale sottoponendolo a grandi quantità di dati e sintonizzando i pesi della rete neurale finché non producono la massima precisione possibile.

Anche: “Possiamo risolvere questo problema in un lasso di tempo che nessun numero di GPU o CPU può raggiungere”, dice la startup Cerebras alla conferenza sul supercalcolo

Non è un segreto che il sistema neurale le reti sono cresciute costantemente di dimensioni. Nell'ultimo anno, quella che era stata la più grande rete neurale del mondo misurata dai pesi neurali, il programma di elaborazione del linguaggio naturale GPT-3 di OpenAI, con 175 miliardi di pesi, è stata eclissata dal modello da 1,6 trilioni di parametri di Google, Switch Transformer.

Tali modelli enormi incontrano problemi perché si estendono oltre i limiti di un singolo sistema informatico. La memoria di una singola GPU, dell'ordine di 16 gigabyte, è sovraccaricata da potenzialmente centinaia di terabyte di memoria richiesti per un modello come GPT-3. Quindi, il raggruppamento dei sistemi diventa cruciale.

E come raggruppare diventa il problema cruciale, perché ogni macchina deve essere tenuta occupata, altrimenti l'utilizzo diminuisce. Ad esempio, quest'anno, Nvidia, Stanford e Microsoft hanno creato una versione di GPT-3 con un trilione di parametri e l'hanno estesa a 3.072 GPU. Ma l'utilizzo, ovvero il numero di operazioni al secondo, era solo il 52% delle operazioni di punta di cui le macchine teoricamente dovrebbero essere in grado.

Quindi, il problema che Feldman e Cerebras hanno deciso di risolvere è gestire reti sempre più grandi in modo da ottenere un migliore utilizzo di ogni elemento di elaborazione e quindi portare a prestazioni migliori e, per estensione, a migliori consumo di energia.

I nuovi computer includono tre parti che interagiscono. Uno è un aggiornamento del computer dell'azienda che contiene il suo chip Wafer-Scale Engine o WSE, il più grande chip mai realizzato. Quel sistema si chiama CS-2. Sia WSE2 che CS-2 sono stati introdotti ad aprile.

Anche: Cerebras continua il “dominio assoluto” dell'elaborazione di fascia alta, si dice, con il chip più grande del mondo a due punti

Natalia Vassilieva, product manager di Cerebras Systems per AI, tiene in mano il WSE-2 dell'azienda, un singolo chip che misura quasi l'intera superficie di un wafer semiconduttore da dodici pollici. Il chip è stato presentato per la prima volta ad aprile ed è il cuore della nuova macchina CS-2, la seconda versione dell'azienda del suo computer AI dedicato.

Cerebras Systems

I nuovi elementi di questa settimana sono una scatola montata su rack chiamata MemoryX, che contiene 2,4 petabyte combinati di memoria flash DRAM e NAND, per memorizzare tutti i pesi della rete neurale. Una terza scatola è una cosiddetta macchina per tessuti che collega il CS-2 al MemoryX, chiamata SwarmX. Il fabric può connettere fino a 192 macchine CS-2 al MemoryX per costruire un cluster che lavora in modo cooperativo su un'unica grande rete neurale.

L'elaborazione parallela su problemi di grandi dimensioni in genere è di due tipi, parallelo dati o parallelo modello.

Ad oggi, Cerebras ha sfruttato il parallelismo del modello, in base al quale gli strati della rete neurale sono distribuiti su diverse parti del chip massiccio, in modo che gli strati e i loro pesi funzionino in parallelo. Il software Cerebras decide automaticamente come distribuire i livelli alle aree del chip e alcuni livelli possono ottenere un'area del chip maggiore di altri.

I pesi neurali, o parametri, sono matrici, tipicamente rappresentate da quattro byte per peso, quindi la memorizzazione del peso è fondamentalmente un multiplo di quattro volte qualunque sia il numero totale di pesi. Per GPT-3, che ha 175 miliardi di parametri, l'area totale dell'intera rete neurale sarebbe di 700 gigabyte.

Un singolo CS-1 può contenere tutti i parametri di una rete di piccole o medie dimensioni o tutti di un determinato livello di un modello di grandi dimensioni come GPT-3, senza dover eseguire il paging su una memoria esterna a causa della grande SRAM su chip di 18 gigabyte.

“Lo strato più grande in GPT-3 è di circa 12.000 x 48.000 elementi”, ha affermato Feldman, parlando delle dimensioni di una singola matrice di peso. “Si adatta facilmente a un singolo WSE-2.”

Nel nuovo chip WSE2, che porta la memoria SRAM a 40 gigabyte, una singola macchina CS-2 può contenere tutti i parametri che verrebbero utilizzati per un dato livello di una rete neurale da 120 trilioni di parametri, afferma Cerebras. “In hot chip mostriamo moltiplicazioni di matrici di 48.000 x 48.000, due volte più grandi di GPT-3”, osserva.

Se utilizzato in combinazione con MemoryX, nell'approccio streaming, il singolo CS-2 può elaborare tutti i pesi del modello man mano che vengono trasmessi alla macchina uno strato alla volta.

Alla società piace chiamare questo “calcolo su scala cerebrale” per analogia con i 100 trilioni di sinapsi nel cervello umano.

La rete neurale da 120 trilioni di parametri in questo caso è una rete neurale sintetica sviluppata internamente da Cerebras a scopo di test, non una rete neurale pubblicata.

Sebbene CS-2 possa contenere tutti quei parametri di livello in un'unica macchina, Cerebras offre ora l'utilizzo di MemoryX per ottenere il parallelismo dei dati. Il parallelismo dei dati è l'opposto del parallelismo del modello, nel senso che ogni macchina ha lo stesso insieme di pesi ma una diversa fetta di dati su cui lavorare.

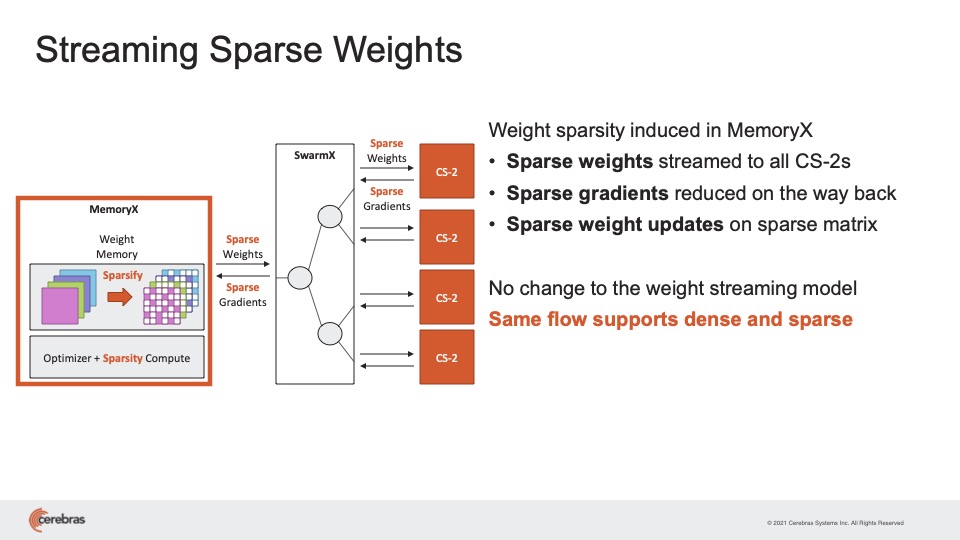

Per ottenere il parallelismo dei dati, Cerebras mantiene tutti i pesi in MemoryX e quindi trasmette selettivamente quei pesi ai CS-2, dove viene archiviata solo la singola porzione di dati.

Ogni CS-2, quando riceve i pesi in streaming, applica quei pesi ai dati di input, e poi passa il risultato attraverso la funzione di attivazione, una sorta di filtro che viene memorizzato anche sul chip, che controlla l'ingresso ponderato per vedere se viene raggiunta una soglia.

Il risultato finale di tutto ciò è il gradiente, un piccolo aggiustamento ai pesi, che viene poi rimandato al box MemoryX dove viene utilizzato per aggiornare l'elenco principale dei pesi. Lo SwarmX fa tutto il percorso avanti e indietro tra MemoryX e CS-2, ma fa anche qualcosa di più.

“SwarmX fa sia la comunicazione che il calcolo”, ha spiegato Feldman. “Il tessuto SwarmX combina i gradienti, chiamato riduzione, il che significa che esegue un'operazione come una media.”

E il risultato, afferma Feldman, è un utilizzo notevolmente maggiore del CS-2 rispetto alla concorrenza anche sulle reti neurali di produzione odierna come GPT-3.

“L'utilizzo di altre persone è compreso tra il 10% o il 20%, ma stiamo assistendo a un utilizzo tra il 70% e l'80% sulle reti più grandi, una cosa inaudita”, ha affermato Feldman. L'aggiunta di sistemi offre ciò che ha chiamato “ridimensionamento lineare delle prestazioni”, il che significa che, se vengono aggiunti sedici sistemi, la velocità per addestrare una rete neurale diventa sedici volte più veloce.

Di conseguenza, “Oggi ogni CS2 sostituisce centinaia di GPU e ora possiamo sostituire migliaia di GPU” con l'approccio cluster, ha affermato.

Cerebras afferma che le macchine in cluster producono un ridimensionamento lineare, il che significa che, per ogni numero di macchine aggiunte, la velocità per addestrare una rete aumenta di un multiplo corrispondente.

Cerebras Systems

Il parallelismo porta a un ulteriore vantaggio, afferma Cerebras, ed è ciò che viene chiamato scarsità.

Fin dall'inizio, Cerebras ha sostenuto che le GPU Nvidia sono gravemente inefficienti a causa della loro mancanza di memoria. La GPU deve andare nella memoria principale, DRAM, che è costosa, quindi recupera i dati in raccolte chiamate batch. Ma ciò significa che la GPU può operare su dati a valore zero, il che è uno spreco. E significa anche che i pesi non vengono aggiornati con la stessa frequenza mentre attendono l'elaborazione di ogni batch.

Il WSE, poiché ha quell'enorme quantità di SRAM su chip, è in grado di estrarre campioni di dati individuali, un batch di uno, come viene chiamato, e di operare su molti di questi campioni individuali in parallelo attraverso il patata fritta. E con ogni singolo campione è possibile, ancora, con memoria veloce, lavorare solo su determinati pesi e aggiornarli selettivamente e frequentemente.

La società sostiene, in una ricerca formale e in un post sul blog del product manager per AI Natalia Vassilieva, che la scarsità porta tutti i tipi di benefici. Rende l'utilizzo della memoria più efficiente e consente la parallelizzazione dinamica e significa che la backpropagation, un passaggio all'indietro attraverso i pesi neurali, può essere compressa in una pipeline efficiente che parallelizza ulteriormente le cose e accelera l'addestramento. Questa è un'idea che sembra mantenere un crescente interesse nel campo in generale.

Quando è arrivato il momento di passare a un sistema a cluster, Cerebras ha nuovamente adottato un approccio sparso. Solo alcuni pesi devono essere trasmessi a ciascun CS-2 dal MemoryX e solo alcuni gradienti devono essere rispediti al MemoryX.

In altre parole, Cerebras afferma che la sua rete di sistema composta da computer, switch e archivio di memoria, si comporta come una versione grande del calcolo sparso che avviene su un singolo chip WSE.

In combinazione con l'approccio allo streaming, la scarsità di CS-2, insieme a MemoryX e SwarmX, ha una componente flessibile e dinamica che, secondo l'azienda, non può essere eguagliata da altre macchine.

“Ogni strato può avere una diversa maschera sparsa”, ha detto Feldman, “che possiamo dare una diversa scarsità per epoca, e durante la corsa di allenamento possiamo cambiare la scarsità, inclusa la scarsità che può trarre vantaggio da ciò che è imparato durante l'allenamento, chiamato scarsità dinamica – nessun altro può farlo.

L'aggiunta di scarsità al parallelismo dei dati, afferma Feldman, comporta un'accelerazione di un ordine di grandezza nel tempo necessario per addestrare reti di grandi dimensioni.

Cerebras sostiene l'uso pesante e flessibile della tecnica nota come scarsità per apportare ulteriori vantaggi in termini di prestazioni.

Sistemi Cerebras

Naturalmente, l'arte di vendere molte più macchine CS-2, insieme ai nuovi dispositivi , dipenderà dal fatto che il mercato sia pronto per reti neurali multi-trilioni o multi-decine di trilioni di peso. Il CS-2 e gli altri componenti dovrebbero essere spediti nel quarto trimestre di quest'anno, quindi tra un paio di mesi.

I clienti esistenti sembrano interessati. Argonne National Laboratories, uno dei nove centri di supercalcolo giganti del Dipartimento dell'Energia degli Stati Uniti, utilizza il sistema CS-1 sin dall'inizio. Sebbene il laboratorio non stia ancora lavorando con il CS-2 né con gli altri componenti, i ricercatori sono entusiasti.

“Gli ultimi anni ci hanno mostrato che, per i modelli di PNL [elaborazione del linguaggio naturale], le intuizioni scalano direttamente con i parametri: più sono i parametri, migliori sono i risultati”, ha affermato Rick Stevens, che è il socio direttore di Argonne, in una dichiarazione preparata.

Anche: 'Stiamo facendo in pochi mesi quello che normalmente richiederebbe anni per un processo di sviluppo di un farmaco': Argonne Labs di DoE combatte COVID-19 con l'IA

“Le invenzioni di Cerebras, che forniranno un aumento di 100 volte nella capacità dei parametri, potrebbero avere il potenziale per trasformare il settore”, ha affermato Stevens. “Per la prima volta saremo in grado di esplorare modelli di dimensioni cerebrali, aprendo vaste nuove strade di ricerca e intuizione”.

Alla domanda se sia il momento giusto per tale potenza, Feldman ha osservato: “Nessuno mette la matzah sugli scaffali a gennaio”, riferendosi al tradizionale pane azzimo che viene rifornito solo esattamente quando necessario, poco prima della festa di Pasqua in primavera.

È giunto il momento per enormi cluster di macchine AI, ha affermato Feldman.

“Questo non è matzah a gennaio”, ha detto.

da leggere

Etica dell'IA: vantaggi e rischi dell'intelligenza artificiale

La scala crescente dell'IA sta sollevando la posta in gioco per importanti questioni etiche .

Ulteriori informazioni

Argomenti correlati:

Hardware Digital Transformation CXO Internet of Things Innovation Enterprise Software ![]()