![]()

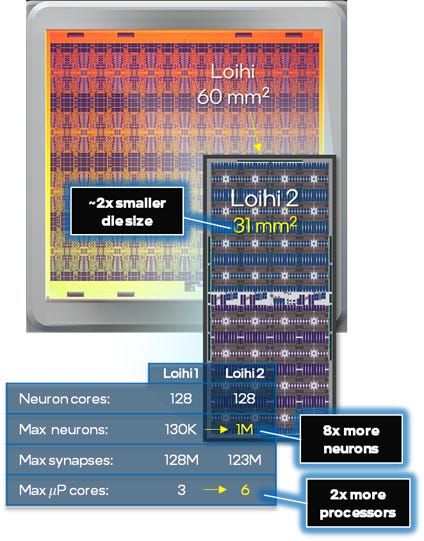

Loihi 2, pronunciato “Low-EE-he”, taglia a metà il dimensione del chip e moltiplica di otto volte il numero di neuroni di picco artificiali. Qui, l'esterno del chip è visto con i suoi contatti per il collegamento al circuito.

Walden Kirsch/Intel

Intel ha presentato giovedì la seconda versione del suo chip neuromorfico Loihi, “Loihi 2”, un processore per l'intelligenza artificiale che, a suo dire, riflette in modo più appropriato i processi che si verificano nel cervello umano rispetto ad altre tecnologie di intelligenza artificiale.

Il nuovo chip è ridotto della metà in un nodo di processo più avanzato, che ora misura 31 millimetri quadrati, eppure contiene un milione di neuroni di picco artificiali, otto volte il numero di quelli del suo predecessore.

p>E il chip guadagna nuova flessibilità grazie a un microcodice più esteso alla base del funzionamento dei neuroni di picco.

Loihi, pronunciato “low-EE-he”, prende il nome da un monte marino hawaiano, un giovane vulcano, “che sta emergendo dal mare in qualsiasi momento ora”, come dice Mike Davies, direttore dei computer neuromorfici di Intel.

Il nuovo chip ottiene anche un nuovo framework di sviluppo, chiamato Lava, che è scritto in Java e rilasciato come open source. Gli sviluppatori possono lavorare su programmi per Loihi senza avere accesso all'hardware. Il software è disponibile su Github.

Intel ha presentato la prima versione di Loihi nel 2017, descrivendolo all'epoca come un chip che “trarrebbe ispirazione dal modo in cui i neuroni comunicano e apprendono, utilizzando picchi e sinapsi di plastica che possono essere modulati in base alla tempistica”.

< p>Il chip è modellato come una “maglia” di core di calcolo

La prima Loihi è stata realizzata utilizzando la tecnologia di processo a 14 nanometri di Intel. La nuova versione utilizza la tecnologia Intel 4 di Intel, poiché l'azienda ha rinominato le sue generazioni di produzione. Si ritiene che sia fondamentalmente un chip a 7 nanometri, sebbene Intel non abbia rivelato tutti i dettagli della tecnologia di processo. La tecnologia è una versione di pre-produzione di Intel 4, sottolinea l'azienda.

Il chip ottiene un microcodice più flessibile che consente ai programmatori di “allocare variabili ed eseguire un'ampia gamma di istruzioni organizzate come brevi programmi utilizzando un linguaggio assembly”, afferma Intel.

Questi programmi hanno accesso alla memoria dello stato neurale, all'input sinaptico accumulato ai per il presente passo temporale, bit casuali per i modelli stocastici e un contatore del passo temporale per il calcolo time-gated. Il set di istruzioni supporta la ramificazione condizionale, la logica bit per bit e l'aritmetica a virgola fissa supportata da moltiplicatori hardware.

“Aggiunge molta generalità, programmabilità, mentre in precedenza eravamo limitati dai set di funzionalità fisse in Loihi 1”, ha affermato Davies di Intel in un'intervista telefonica a ZDNet.

Intel ha migliorato le prestazioni a molti livelli con il chip, ha affermato.

“Abbiamo carichi di lavoro che verranno eseguiti oltre dieci volte più velocemente e, a livello di circuito, siamo da due a sette volte, a seconda del parametro”. Intel ha anche potenziato la “scalabilità da chip a chip” moltiplicando per quattro la larghezza di banda su ciascun collegamento tra i core.

Il chip è in grado di scalare in tre dimensioni, ha affermato Davies, utilizzando inter-chip collegamenti.

Il chip ora ha quasi 150 gruppi di ricerca in tutto il mondo che utilizzano Loihi, ha affermato Davies.

La tesi dei sostenitori del calcolo neuromorfo è che l'approccio emula più da vicino le caratteristiche reali del funzionamento del cervello, come la grande economia con cui il cervello trasmette i segnali.

Il campo del deep learning, che adotta un approccio diverso all'IA, ha criticato gli approcci neuromorfici per non aver ottenuto risultati pratici, in contrasto con i sistemi di deep learning come ResNet che possono individuare immagini in immagini. Il capo dell'intelligenza artificiale di Facebook, Yann LeCun, nel 2019 ha respinto l'approccio neuromorfo in una conferenza in cui ha parlato sia lui che Davies.

Una fotografia della rete di core di calcolo in Loihi 2.

Intel

In un articolo pubblicato all'inizio di quest'anno su IEEE Spectrum, Davies e colleghi hanno portato prove di quelli che, secondo loro, sono i vantaggi dimostrabili dei chip neuromorfici su una serie di problemi. Come affermano nell'articolo, i chip neuromorfici ottengono vantaggi quando ci sono elementi in un problema come la ricorsione, che collegano al modo in cui il cervello elabora:

Mentre le reti neurali profonde feedforward convenzionali mostrano un beneficio modesto o nullo su Loihi, le reti più ispirate al cervello che utilizzano ricorrenza, precise relazioni di temporizzazione dei picchi, plasticità sinaptica, stocasticità e scarsità eseguono determinati calcoli con ordini di grandezza inferiori di latenza ed energia rispetto a approcci convenzionali all'avanguardia. Queste avvincenti reti neuromorfe risolvono una vasta gamma di problemi rappresentativi del calcolo simile al cervello, come la base di eventi

“Abbiamo un portafoglio di risultati che per la prima volta confermano davvero quantitativamente la promessa dell'hardware neuromorfo di fornire miglioramenti significativi in termini di efficienza energetica, latenza di elaborazione e efficienza dei dati di alcuni algoritmi di apprendimento”, ha detto Davies a ZDNet.

“È stata una delle sorprese davvero piacevoli scoprire che i chip neuromorfici sono fantastici nel risolvere i problemi di ottimizzazione”, ha affermato Davies. “Non è così sorprendente perché i cervelli sono sempre in ottimizzazione”, ha detto.

Nelle forme di apprendimento automatico dell'apprendimento profondo, il processo di fare previsioni, fare inferenza, è strettamente “processo feed-forward”, ha affermato Davies. Al contrario, ha detto Davies, “il cervello è un processo molto più complesso di quello, tiene sempre conto del feedback, è la comprensione del contesto e delle aspettative, nella sua inferenza.”

Il team Loihi di Intel descrive i risultati dei benchmark rispetto ai tradizionali approcci di deep learning. Le voci Loihi sono le tre reti elencate come “SLAYER”, che sta per “Spike Layer Error Reassignment”, uno strumento sviluppato nel 2018 dagli scienziati della National University of Singapore per consentire l'addestramento dei picchi neuromorfici con la retropropagazione.

IntelDi conseguenza, “Il cervello sta effettivamente eseguendo l'ottimizzazione”, ha affermato. “Poiché abbiamo estratto alcune di queste capacità in un quadro matematico standard, abbiamo scoperto che possiamo risolvere problemi come QUBO, ottimizzazione primaria non vincolata quadratica”, una classe di problemi che sono stati eseguiti nei computer quantistici.

“Abbiamo scoperto che possiamo effettivamente risolvere i problemi QUBO in modo fantastico”, ha detto.

Uno dei primi utenti di Loihi 2, il Los Alamos National Laboratory del Dipartimento dell'Energia degli Stati Uniti, racconta di essere stato in grado di stabilire connessioni tra più domini con il chip. Ad esempio, Loihi ha scoperto le correnti incrociate nell'apprendimento automatico e nell'informatica quantistica, secondo lo scienziato dello staff di Los Alamos, il dottor Gerd J. Kunde:

Gli investigatori del Los Alamos National Laboratory hanno utilizzato la piattaforma neuromorfica Loihi per studiare i compromessi tra calcolo quantistico e neuromorfo, oltre a implementare processi di apprendimento su chip. Questa ricerca ha mostrato alcune interessanti equivalenze tra le reti neurali di picco e gli approcci di ricottura quantistica per risolvere problemi di ottimizzazione difficile. Abbiamo anche dimostrato che l'algoritmo di backpropagation, un elemento fondamentale per l'addestramento delle reti neurali e precedentemente ritenuto non implementabile su architetture neuromorfe, può essere realizzato in modo efficiente su Loihi. Il nostro team è entusiasta di continuare questa ricerca con il chip Loihi 2 di seconda generazione.

In un prossimo articolo inviato a IEEE Spectrum, Davies e il team descrivono esperimenti con Loihi 2 in cui hanno confrontato il chip su attività di apprendimento automatico standard, come il set di dati di Google Speech Commands, addestrando un modello perceptron multistrato e confrontandolo con la rete profonda migliore della categoria, un modello creato dai ricercatori di Google e riportato l'anno scorso.

Le voci di Loihi hanno utilizzato uno strumento chiamato “SLAYER”, che sta per “Spike Layer Error Reassignment”, un programma introdotto nel 2018 da Sumit Bam Shrestha e Garrick Orchardat della National University of Singapore per consentire l'addestramento dei picchi neuromorfici con la retropropagazione.

Un modello, che cuoce in convoluzioni, ha ottenuto una precisione su quel test del 91,74%, che è migliore della rete profonda standard, ma utilizzando molti meno parametri.

Argomenti correlati:

Hardware Digital Transformation CXO Internet of Things Innovation Enterprise Software ![]()