Ett Google-datacenter med rack av dess TPU version 4-acceleratorchips för knäckande maskininlärning. Google använde ett kluster av 2 048 TPU:er för att träna sin största version någonsin av sitt naturliga språkprogram BERT, bestående av 481 miljarder parametrar, på 19 timmar, som en anmälan till MLPerfs benchmark-tävling.

< p>Den djupinlärningsvärld av artificiell intelligens är besatt av storlek.

Deep learning-program, som OpenAI:s GPT-3, fortsätter att använda fler och fler GPU-chips från Nvidia och AMD – eller nya typer av acceleratorchips – för att bygga allt större program. Noggrannheten hos programmen ökar med storleken, menar forskare.

Denna besatthet av storlek visades för fullt i onsdags i de senaste branschreferensresultaten rapporterade av MLCommons, som sätter standarden för att mäta hur snabbt datorchips kan krascha djupinlärningskod.

Google bestämde sig för att inte underkasta sig några standardmässiga benchmarktest av djupinlärning, som består av program som är väletablerade på området men relativt föråldrade. Istället visade Googles ingenjörer upp en version av Googles naturliga språkprogram BERT, som ingen annan leverantör använde.

MLPerf, benchmarksviten som används för att mäta prestanda i konkurrensen, rapporterar resultat för två segment: standarddivisionen “Stängd”, där de flesta leverantörer konkurrerar på väletablerade nätverk som ResNet-50; och “Open”-avdelningen, som låter leverantörer prova icke-standardiserade metoder.

Det var i Open-divisionen som Google visade en dator som använde 2 048 av Googles TPU-chips, version 4. Den maskinen kunde utveckla BERT-programmet på cirka 19 timmar.

Även: AI på sextio sekunder

BERT-programmet, ett neuralt nätverk med 481 miljarder parametrar, hade inte tidigare varit avslöjats. Det är över tre storleksordningar större än standardversionen av BERT i omlopp, känd som “BERT Large”, som bara har 340 miljoner parametrar. Att ha många fler parametrar kräver vanligtvis mycket mer datorkraft.

Google sa att den nya inlämningen speglar den ökande betydelsen av skala inom AI.

< p>Google skickade in den nya versionen av sitt BERT-språkprogram i “Open”-avdelningen av MLPerf. Graphcore och Samsung var de andra två leverantörerna som deltog i denna division.

< p>Google skickade in den nya versionen av sitt BERT-språkprogram i “Open”-avdelningen av MLPerf. Graphcore och Samsung var de andra två leverantörerna som deltog i denna division.

MLCommons

“Vår tankegång den här gången är att vi alltid har varit angelägna om att se till att våra inlämningar till MLPerf är väl anpassade till våra interna behov och behoven hos ML-industrin”, säger Aarush Selvan, som övervakar maskininlärningsinfrastruktur för Google, i en mediagenomgång.

“Och så, utbildning av stora modeller — modeller i storleksordningen tiotals eller hundratals miljarder parametrar, och till och med en biljon parametrar och uppåt, blir allt viktigare både inom Google — det är en enorm uppsättning av fokus för vår forskning och vår produktion — men också för våra molnkunder.”

MLPerfs testsvit är skapandet av MLCommons, ett industrikonsortium som utfärdar flera årliga benchmark-utvärderingar av datorer för de två delarna av maskininlärning: så kallad träning, där ett neuralt nätverk byggs upp genom att dess inställningar förfinas i flera experiment; och så kallad inferens, där det färdiga neurala nätverket gör förutsägelser när det tar emot ny data.

Onsdagens rapport är det senaste benchmarktestet för träningsfasen. Den följer den tidigare rapporten i juni.

De fullständiga MLPerf-resultaten diskuterades i ett pressmeddelande på MLCommons webbplats. Den fullständiga informationen om inlämningar kan ses i tabeller som publiceras på webbplatsen.

Även: Graphcore ger Nvidia ny konkurrens i de senaste MLPerf AI-riktmärkena< /p>

Googles Selvan sa att MLCommons borde överväga att inkludera fler stora modeller. De äldre, mindre nätverken som ResNet-50 “ger oss bara en proxy” för storskalig träningsprestanda, sa han.

“Att kasta 4 000 marker för att träna BERT på bara några sekunder är riktigt coolt”, konstaterade Selvan och syftade på den mindre versionen av BERT som de flesta leverantörer fokuserar på i den stängda divisionen.

“Och visar upp några aspekter av skalbarhet. , men det är egentligen bara en proxy, för i verkligheten använder du aldrig så många marker för att träna den lilla modellen.”

“Att kasta 4 000 marker för att träna BERT på bara några sekunder är riktigt coolt”, konstaterade Selvan, med hänvisning till den mindre versionen av BERT som de flesta leverantörer fokuserar på i den stängda divisionen. “Och visar upp vissa aspekter av skalbarhet, men det är egentligen bara en proxy, för i verkligheten använder du aldrig så många marker för att träna den lilla modellen.”

MLCommons

Den saknade komponenten, sa Selvan, är den så kallade effektiviteten hos systemen när de blir större. Google kunde köra sin gigantiska BERT-modell med 63 % effektivitet, sa han till ZDNet, mätt med antalet flyttalsoperationer per sekund som utförs i förhållande till en teoretisk kapacitet. Det, sa han, var bättre än det näst högsta branschresultatet, 52 %, som Nvidia uppnådde i utvecklingen av dess Megatron-Turing-språkmodell utvecklad med Microsoft.

“Framöver tror vi att det skulle vara riktigt häftigt att ha någon form av benchmark för stora modeller inom MLPerf-tävlingen,” sa Selvan.

David Kanter, verkställande direktör för MLCommons, sa att beslutet att ha stora modeller borde överlåtas till medlemmarna av Commons att besluta kollektivt. Han påpekade dock att användningen av små neurala nätverk som tester gör tävlingen tillgänglig för fler parter.

“Poängen med ett riktmärke är att vara rättvist och representativt, men också att inte göra någon som driver det i konkurs”, sa Kanter.

“I teorin skulle vi kunna göra träning GPT-3 till ett MLPerf riktmärke”, tillade Kanter, med hänvisning till språkmodellen med 175 miljarder parametrar som introducerades av OpenAI förra året som ett toppmodernt naturligt språk modell.

“Poängen med ett riktmärke är att vara rättvis och representativ, men också att inte göra någon som driver det i konkurs”, säger MLCommons ordförande Kanter. “I teorin skulle vi kunna göra träning GPT-3 en MLPerf -riktmärke … Utmaningen är att träning av GPT-3 är ganska beräkningsmässigt dyr. Det kostar tiotals miljoner dollar.”

MLCommons

“Utmaningen är att det är ganska dyrt att träna GPT-3. Det kostar tiotals miljoner dollar.”

Däremot är standardtesterna för MLPerf, vars kod görs tillgänglig för alla, en resurs som alla AI-forskare kan ta för att replikera testerna – utan att ha exotiska metoder för beräkning, sa Kanter.

“På det sättet producerar det dessa mycket värdefulla tekniska artefakter för hela samhället och hjälper till att driva branschen framåt.”

Google har inga planer på att publicera på den nya BERT-modellen, Selvan berättade för ZDNet i ett mejl och beskrev det som “något vi gjorde bara för MLPerf.” Programmet liknar design som beskrivs i forskning av Google tidigare i år på mycket parallelliserade neurala nätverk, sa Selvan.

Trots nyheten med BERT-programmet med 481 miljarder parametrar är det representativt för verkliga uppgifter eftersom det bygger på verklig kod.

“Vi tror att dessa riktmärken vi skickade in, eftersom de använder en staplad transformatorarkitektur, är ganska realistiska när det gäller deras beräkningsegenskaper med befintliga stora språkmodeller som har publicerats,” sa Selvan till ZDNet.< /p>

Liksom de mindre inlämningarna i MLPerf tränades den gigantiska BERT-modellen för att ge resultat med en viss noggrannhet, förklarar Selvan. I det här fallet, 75 % noggrannhet i förutsägelser, över de 72,2 % som krävs av MLPerf.

Nvidia-chips tog återigen lejonparten toppresultat för att träna neurala nät, med lite hjälp den här gången från Microsoft Azure.

Nvidia

Google-programmet förlitade sig också på färre exempel på textdata för att nå samma noggrannhet som resultaten för sluten division från andra leverantörer. Den stängda divisionen kräver ett program för att träna med nästan en halv miljard sekvenser av tokens, mestadels med en längd av 128 tokens per sekvens. Google-programmet tränades med endast cirka 20 miljoner tokens, men med en längd av 512 tokens per sekvens. Arbetet diskuteras mer i detalj i ett blogginlägg av Google.

Det 2 048-TPU-system som Google använde för att utföra arbetet är för närvarande tillgängligt som en Google Cloud-tjänst.

Resten av MLPerf-resultaten, mestadels i den stängda divisionen, visar att Nvidia och andra leverantörer fortsätter att göra framsteg när det gäller att minska tiden det tar att träna standardversionerna av ResNet, BERT och andra uppgifter.

Nvidia tog som alltid lejonparten av toppresultaten. Till exempel tog datorer som använder sin senaste generation av GPU, A100, de fyra bästa platserna för den snabbaste tiden att träna ResNet-50, den snabbaste var bara 21 sekunder. Det var med 4 320 A100 som arbetar parallellt, med hjälp av 1 080 AMD:s EPYC x86-processorer. Resultatet var en förbättring under de 24 sekunder som Nvidia noterade i junirapporten.

Men där system använde färre Nvidia-chips och färre värdprocessorer kunde konkurrenterna få högre poäng än Nvidia. Intels Habana Labs tog femteplatsen i ResNet-50 med 256 av Habanas Gaudi acceleratorchips övervakade av 128 Intel Xeons.

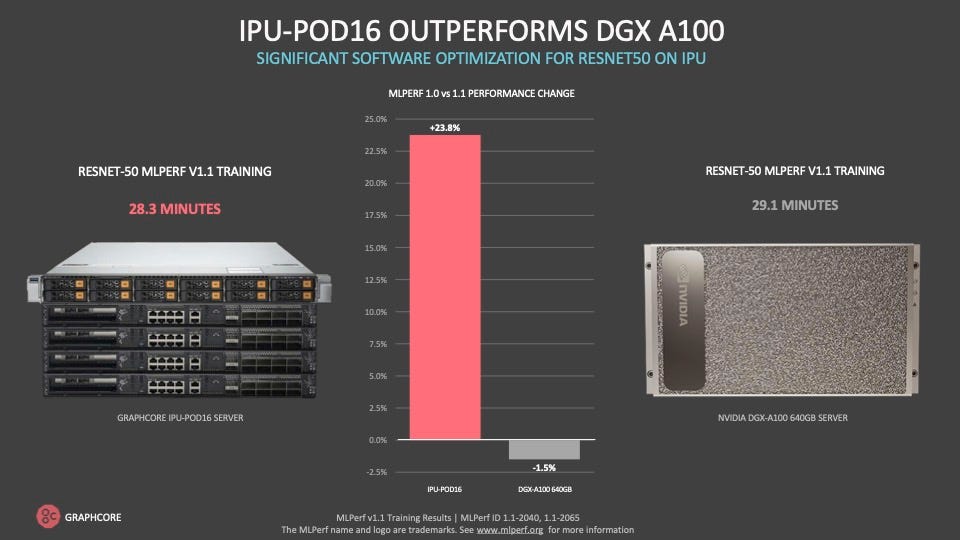

Graphcore gjorde fallet att det kan leverera bättre resultat till mycket lägre kostnad än Nvidias system , en större del av besparingarna är färre värdprocessorer från Intel eller AMD som behövs för ett motsvarande antal AI-acceleratorer.

Graphcore

Och Graphcore, den Bristol, Storbritannien-baserade startup som visade bäst poäng i junirapporten för ett tvåprocessorsystem på BERT-utbildning, tog sjätte platsen på ResNet-50 med en ny version av sin IPU-POD-dator som använder 256 av sina IPU-acceleratorchips och 32 AMD EPYC-värdprocessorer.

Habana- och Graphcore ResNet-50-resultaten var 3,4 minuter respektive 3,8 minuter. Det kan jämföras med 4,5 minuter som krävs av Nvidias 7:e plats, ett 64-vägs A100-system med 16 EPYC-processorer.

Precis som i junirapporten, första gången Graphcore deltog, betonade företaget vikten av att hitta en balans mellan prestanda och kostnad för de övergripande systemen. Företaget citerade tid-till-tid-tåget ResNet-50 på 28 minuter på sitt 16-vägssystem, en minut snabbare än ett jämförbart Nvidia DGXA100-system som kostar betydligt mer, sa det.

“Vår POD-16 överträffar en DGXA100… och det är halva listpriset för DGXA100”, sa Dave Lacey, Graphcores chefsmjukvaruarkitekt, i en mediagenomgång.

Mycket av kostnadsfördelarna kommer från att ha en mindre förhållande mellan Intel- eller AMD x86-värdprocessorer i förhållande till IPU-chips, sa Graphcore.

Graphcore kom på sjätte plats efter Nvidia-chips för högsta poäng som tränade standard BERT-modellen, på nästan 7 minuter mot 3 minuter för Nvidia-system på femte plats. Graphcore-systemet använde dock bara 4 AMD EPYC-processorer mot 16 i det Nvidia-baserade systemet.

“Värdprocessorpriset är en betydande del av kostnaden för ett system,” sa Lacey. “Som vilken dyr resurs som helst, använder du bara det du behöver.”

Graphcore gör fallet till det låga förhållandet mellan värdprocessor – Intel eller AMD x86 — till acceleratorchip är en mer effektiv modell av AI-bearbetning som leder till betydande kostnadsbesparingar.

Graphcore

På frågan om Googles poäng angående stora neurala nätuppgifter, sa Lacey att de viktigaste MLPerf-resultaten fungerar bra som en proxy för verkliga uppgifter.

Utöver individuella leverantörers prestationer, visar MLPerf-riktmärket den totala chipindustrins prestation när det gäller att påskynda prestanda på neurala nätverk, sa MLCommons ordförande Kanter.

“Om du tittar på banan för de bästa resultaten i MLPerf-träning. med tiden kan du se att den är dramatiskt snabbare än Moores lag, säger Kanter och syftar på halvledartumregeln under många decennier att transistortätheten fördubblas ungefär var 18:e månad, vilket leder till en fördubbling av prestanda.

< p>“Genom optimeringar av arkitektur, till systemstorlek, till programvara, till modellpartitionering,” sa Kanter, lyckas leverantörer påskynda neurala nätprestanda så mycket som 11 gånger snabbare än Moores lags historiska bana.

Benchmark-sviten fortsätter att få stöd från leverantörer, med fler deltagare och fler bidrag. Resultaten som rapporterades för alla riktmärken sammantaget uppgick till 175, upp från 144 i junirapporten.

Nya leverantörer gick med i tävlingen den här gången. Samsung Electronics, till exempel, lämnade in resultat från sin superdator med 256 AMD-chips och 1 024 Nvidia A100. Det systemet, med hjälp av några icke-standardiserade mjukvarujusteringar, hade den näst snabbaste poängen av alla system för att träna den normala versionen av BERT, bara 25 sekunder.

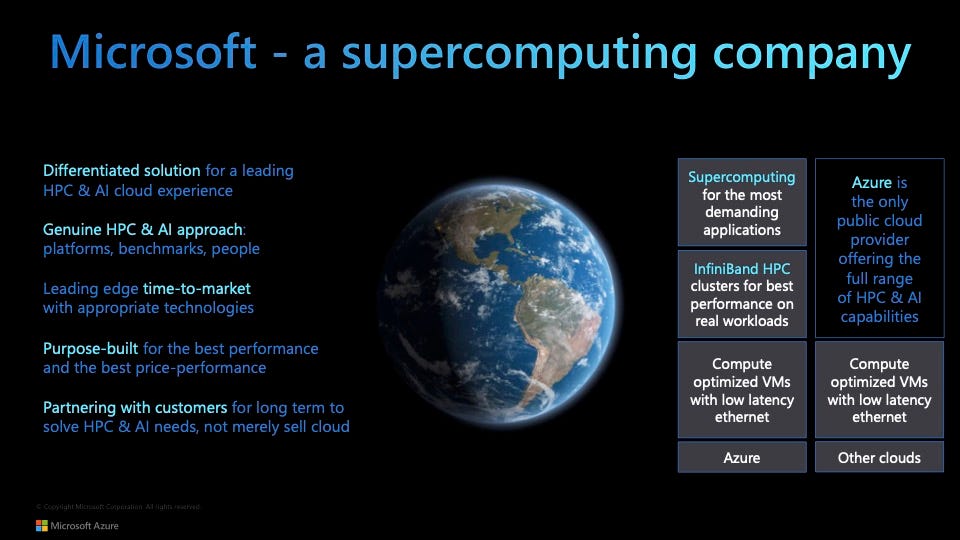

Också en nykomling denna gång var Microsofts Azure molntjänst, som rapporterade resultat för 19 inlämningar med AMD-processorer och Nvidia A100s i olika konfigurationer. Azure vann två av de fem bästa platserna i sju av de åtta benchmarktesterna.

Och ett Azure-system tog toppbetyget för att träna en bildsegmenteringsmodell på medicinsk data (KiTS19-utmaningen) med 192 AMD EPYC-processorer och 768 A100.

“Vi vill demokratisera superdatorer,” sa Nidhi Chappell, chef för högpresterande datorer och AI på Azure, till ZDNet.

Hon sa att att göra kommersiellt tillgängliga system, som 768-vägs AI100-systemet, i molnet har “fört samman det bästa av HPC och AI, istället för att ta ett vaniljmoln som tjänar varje arbetsbelastning.”

“AI-utbildning är ett HPC-problem, och vår expertis inom HPC har hjälpt oss att bygga AI i stor skala”, sa hon. “Vi vill bygga infrastruktur som är optimerad för storskalighet.” Detta inkluderar system som har så många som 80 000 kärnor.

Microsoft visar sin Azure molntjänsten “demokratiserar högpresterande datoranvändning” med sin första MLPerf-utbildningsinlämning, genomförd i samarbete med Nvidia.

Microsoft Azure

En viktig anledning till att delta i MLPerf, sa Chappell, var att visa att så storskaligt arbete kan prestera lika bra i en molnmiljö som det gör på plats.

“Vad vi har bevisat är att vi har kunnat maskera overheaden av molnvirtualisering; den overheaden är ganska avlägsen i molnet,” så att den inte drar ner prestandan, sa hon.

p>

På frågan om stora modeller kontra standard MLPerf-uppgifter, sa Chappell “det är bara en tidsfråga” innan Azure skickar in några icke-standardiserade, storskaliga arbeten som liknar vad Google har gjort i Open-divisionen.

“Det kommer att hända.”

Samtidigt är standard-MLPerf-testerna i den slutna divisionen användbara, sade hon, eftersom de “visar hur snabbt AI utvecklas; det är en ständig optimeringsprocess.”

Även: Etik för AI: Fördelar och risker med artificiell intelligens

Chappells samarbetspartner på Nvidia, Shar Narasimhan, Nvidias seniora produktchef för sina datacenterprodukter, sa i samma genomgång att MLPerfs standardtester har fördelen att vara som en enhetlig bana där många idrottare tävlar på ett jämnt fält.

“Det fungerar som en möjlighet för alla att springa exakt samma lopp och jämföra resultaten direkt”, sa Narasimhan. “När vi tittar på OS-resultat har vi haft exakt samma bana i mer än ett sekel, och det gör att du kan jämföra loppet som kördes för 100 år sedan med [den jamaicanske sprintern] Usain Bolts resultat.”

< p>Självklart, med världens största publicerade NLP-modell, Megatron-Turing, verkar det som om Nvidia och Azure skulle kunna erbjuda en ny inlämning av stora modeller som Google gjorde.

“Vi kan inte jämföra dessa modeller med någon annan”, förklarade Narasimhan, så det är svårt att göra sådant arbete användbart i MLPerf-sammanhang. Nvidia har inte förbundit sig till några framtida inlämningar av stora modeller.

När det gäller det som är viktigt för branschen, sa Narasimhan, är att många företag vill använda AI för fokuserade syften, “inte en gigantisk språkmodell som behöver 4 000 chips för att köra.” De mindre riktmärkena kan användas för att förutse arbetsbelastning och prestanda, sade han.

Googles Selvan sa att Google avser att fortsätta att underkasta sig MLPerfs riktmärken för sluten division i framtiden.

“Vi kommer att se alla tillbaka i den stängda divisionen nästa år — förhoppningsvis kan jag inte lova, men vi planerar att vara där,” sa han.

Teknikintäkter

Försäljningen av smarttelefoner under tredje kvartalet faller med 6,8 % när efterfrågan överträffar komponenttillbehör HP rapporterar starka resultat för fjärde kvartalet, uppgångar för första kvartalet Dell ser kommersiell PC-boom under tredje kvartalet VMware överträffar uppskattningar för tredje kvartalet med intäkterna upp 11 procent Best Buy tredje kvartalet bättre än väntat , men bruttomarginaler under press Pure Storage slår förväntningarna för tredje kvartalet, höjer utsikterna Zoom landar fler stora kunder under tredje kvartalet, slår marknadsuppskattningar Workday förvärvar VNDLY för 510 miljoner dollar, rapporterar stark hårdvara för tredje kvartalet | Digital transformation | CXO | Internet of Things | Innovation | Företagsprogramvara