Et Google-datacenter med stativer af dens TPU version 4 acceleratorchips til knasende maskinlæring. Google brugte en klynge af 2.048 TPU'er til at træne sin hidtil største version af sit BERT-natursprogsprogram, bestående af 481 milliarder parametre, på 19 timer, som en indsendelse til MLPerf-benchmark-konkurrencen.

< p>Den dybe læringsverden af kunstig intelligens er besat af størrelse.

Deep learning-programmer, såsom OpenAI's GPT-3, fortsætter med at bruge flere og flere GPU-chips fra Nvidia og AMD – eller nye former for accelerator-chips – til at bygge stadigt større softwareprogrammer. Nøjagtigheden af programmerne øges med størrelsen, hævder forskere.

Denne besættelse af størrelse var på fuld visning onsdag i de seneste industri-benchmark-resultater rapporteret af MLCommons, som sætter standarden for måling af, hvor hurtigt computerchips kan knække dyb læringskode.

Google besluttede ikke at underkaste sig nogen standard benchmark-tests af deep learning, som består af programmer, der er veletablerede på området, men relativt forældede. I stedet viste Googles ingeniører en version af Googles BERT naturlige sprogprogram frem, som ingen anden leverandør brugte.

MLPerf, benchmark-pakken, der bruges til at måle præstationer i konkurrencen, rapporterer resultater for to segmenter: Standard “Lukket” division, hvor de fleste leverandører konkurrerer på veletablerede netværk såsom ResNet-50; og “Åben”-afdelingen, som lader leverandører prøve ikke-standardiserede tilgange.

Det var i Open-afdelingen, at Google viste en computer, der brugte 2.048 af Googles TPU-chips, version 4. Den maskine var i stand til at udvikle BERT-programmet på omkring 19 timer.

Også: AI på tres sekunder

BERT-programmet, et neuralt netværk med 481 milliarder parametre, havde ikke tidligere været afsløret. Det er over tre størrelsesordener større end standardversionen af BERT i omløb, kendt som “BERT Large”, som kun har 340 millioner parametre. At have mange flere parametre kræver typisk meget mere computerkraft.

Google sagde, at den nye indsendelse afspejler den stigende betydning af skala i kunstig intelligens.

< p>Google indsendte den nye version af sit BERT-sprogprogram i “Open”-afdelingen af MLPerf. Graphcore og Samsung var de to andre leverandører, der deltog i denne division.

< p>Google indsendte den nye version af sit BERT-sprogprogram i “Open”-afdelingen af MLPerf. Graphcore og Samsung var de to andre leverandører, der deltog i denne division.

MLCommons

“Vores tankegang denne gang er, at vi altid har været ivrige efter at sikre, at vores indsendelser til MLPerf er godt tilpasset vores interne behov og behovene i ML-industrien,” sagde Aarush Selvan, der fører tilsyn med maskinlæringsinfrastruktur for Google, i en mediebriefing.

“Og så træning af store modeller — modeller i størrelsesordenen titusinder eller hundreder af milliarder af parametre, og endda en billion parametre og derover, er stadig vigtigere både inden for Google — det er et enormt sæt af fokus for vores forskning og vores produktion — men også for vores cloud-kunder.”

MLPerf-testpakken er skabelsen af MLCommons, et industrikonsortium, der udsteder flere årlige benchmark-evalueringer af computere for de to dele af maskinlæring: såkaldt træning, hvor et neuralt netværk bygges ved at få dets indstillinger forfinet i flere eksperimenter; og såkaldt inferens, hvor det færdige neurale netværk laver forudsigelser, efterhånden som det modtager nye data.

Onsdagens rapport er den seneste benchmark-test for træningsfasen. Den følger den tidligere rapport i juni.

De fulde MLPerf-resultater blev diskuteret i en pressemeddelelse på MLCommons-webstedet. De fuldstændige data om indsendelser kan ses i tabeller, der er offentliggjort på webstedet.

Også: Graphcore bringer ny konkurrence til Nvidia i de seneste MLPerf AI-benchmarks< /p>

Googles Selvan sagde, at MLCommons burde overveje at inkludere flere store modeller. De ældre, mindre netværk som ResNet-50 “giver os kun en proxy” til træning i stor skala, sagde han.

“At kaste 4.000 chips for at træne BERT på bare et par sekunder er virkelig fedt,” bemærkede Selvan med henvisning til den mindre version af BERT, som de fleste leverandører fokuserer på i den lukkede division.

“Og viser nogle aspekter af skalerbarhed. , men det er egentlig bare en proxy, for i det virkelige liv bruger du aldrig så mange chips til at træne den lille model.”

“At kaste 4.000 chips for at træne BERT på bare et par sekunder er virkelig fedt,” bemærkede Selvan med henvisning til den mindre version af BERT, som de fleste leverandører fokuserer på i den lukkede division. “Og viser nogle aspekter af skalerbarhed, men det er egentlig bare en proxy, for i det virkelige liv bruger du aldrig så mange chips til at træne den lille model.”

MLCommons

Den manglende komponent, sagde Selvan, er den såkaldte effektivitet af systemer, efterhånden som de bliver større. Google var i stand til at køre sin gigantiske BERT-model med en effektivitet på 63 %, fortalte han ZDNet, målt ved antallet af flydende kommaoperationer pr. sekund udført i forhold til en teoretisk kapacitet. Det, sagde han, var bedre end det næsthøjeste industriresultat, 52%, opnået af Nvidia i udviklingen af sin Megatron-Turing-sprogmodel udviklet med Microsoft.

“Fremadrettet synes vi, det ville være virkelig fantastisk at have en slags benchmark for store modeller inden for MLPerf-konkurrencen,” sagde Selvan.

David Kanter, administrerende direktør for MLCommons, sagde, at beslutningen om at have store modeller skulle overlades til medlemmerne af Commons at beslutte i fællesskab. Han påpegede dog, at brugen af små neurale netværk som test gør konkurrencen tilgængelig for flere parter.

“Punkten med et benchmark er at være retfærdigt og repræsentativt, men også at ikke slå nogen som driver det konkurs,” sagde Kanter.

“I teorien kunne vi gøre træning GPT-3 til et MLPerf benchmark,” tilføjede Kanter med henvisning til 175-milliarder parametre sprogmodel introduceret af OpenAI sidste år som et state-of-the-art naturligt sprog model.

“Pointen med et benchmark er at være retfærdigt og repræsentativt, men også at ikke slå nogen, der driver det konkurs,” sagde MLCommons formand Kanter. “I teorien kunne vi gøre træning GPT-3 til et MLPerf -benchmark … Udfordringen er, at træning i GPT-3 er ganske beregningsmæssigt dyrt. Det koster titusindvis af millioner af dollars.”

MLCommons

“Udfordringen er, at træning af GPT-3 er ganske beregningsmæssigt dyrt. Det koster titusindvis af millioner dollars.”

Derimod er standardtestene af MLPerf, hvis kode er gjort tilgængelig for alle, en ressource, enhver AI-forsker kan gribe for at replikere testene – uden at have eksotiske tilgange til beregning, sagde Kanter.

“På den måde producerer det disse meget værdifulde tekniske artefakter for hele samfundet og hjælper med at drive industrien fremad.”

Google har ingen planer om at udgive om den nye BERT-model, Selvan fortalte ZDNet i en e-mail og beskrev det som “noget, vi gjorde kun for MLPerf.” Programmet ligner design skitseret i forskning af Google tidligere i år på stærkt paralleliserede neurale netværk, sagde Selvan.

På trods af nyheden i BERT-programmet med 481 milliarder parametre, er det repræsentativt for opgaver i den virkelige verden, fordi det bygger på kode fra den virkelige verden.

“Vi mener, at disse benchmarks, vi har indsendt, fordi de udnytter en stablet Transformer-arkitektur, er ret realistiske med hensyn til deres beregningsegenskaber med eksisterende store sprogmodeller, der er blevet offentliggjort,” sagde Selvan til ZDNet.< /p>

Ligesom de mindre indsendelser i MLPerf blev den gigantiske BERT-model trænet til at producere resultater med en vis nøjagtighed, forklarer Selvan. I dette tilfælde 75% nøjagtighed i forudsigelser, over de 72,2%, der kræves af MLPerf.

Nvidia-chips tog endnu en gang broderparten af topscore til at træne neurale net, med lidt hjælp denne gang fra Microsoft Azure.

Nvidia

Google-programmet var også afhængig af færre eksempler på tekstdata for at opnå samme nøjagtighed som resultaterne for lukkede divisioner fra andre leverandører. Den lukkede division kræver et program for at træne med næsten en halv milliard sekvenser af tokens, for det meste af en længde på 128 tokens pr. sekvens. Google-programmet blev trænet med kun omkring 20 millioner tokens, men med en længde på 512 tokens pr. sekvens. Arbejdet diskuteres mere detaljeret i et blogindlæg af Google.

Det 2.048-TPU-system, Google brugte til at udføre arbejdet, er i øjeblikket tilgængelig som en Google Cloud-tjeneste.

Resten af MLPerf-resultaterne, for det meste i den lukkede division, viser, at Nvidia og andre leverandører fortsætter med at gøre fremskridt med at reducere den tid, det tager at træne standardversionerne af ResNet, BERT og andre opgaver.

Nvidia tog som altid brorparten af de bedste resultater. For eksempel tog computere, der brugte den seneste generation af GPU, A100, de fire øverste pladser for den hurtigste tid til at træne ResNet-50, den hurtigste var på kun 21 sekunder. Det var med 4.320 A100'er, der opererede parallelt, ved hjælp af 1.080 AMD's EPYC x86-processorer. Resultatet var en forbedring i forhold til de 24 sekunder, Nvidia noterede sig i junirapporten.

Men hvor systemer brugte færre Nvidia-chips og færre værtsprocessorer, var konkurrenterne i stand til at score højere end Nvidia. Intels Habana Labs tog femtepladsen i ResNet-50 med 256 af Habanas Gaudi acceleratorchips overvåget af 128 Intel Xeons.

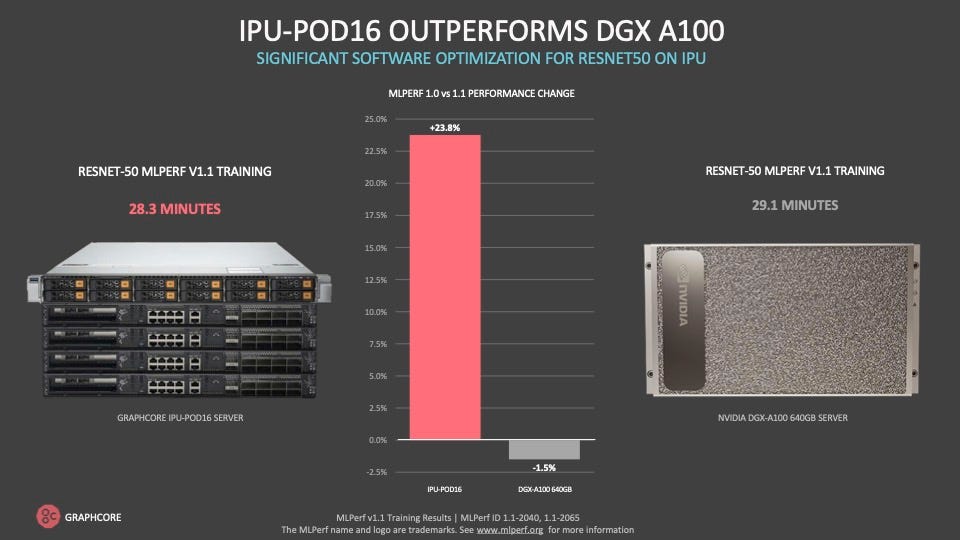

Graphcore gjorde det muligt at levere bedre resultater til meget mindre omkostninger end Nvidias systemer , hvor en større del af besparelsen er færre værtsprocessorer fra Intel eller AMD, der er nødvendige for et tilsvarende antal AI-acceleratorer.

Graphcore

Og Graphcore, den Bristol, UK-baserede startup, der viste den bedste score i junirapporten for et to-processor system på BERT træning, tog sjettepladsen på ResNet-50 med en ny version af sin IPU-POD computer, der bruger 256 af sine IPU-acceleratorchips og 32 AMD EPYC-værtsprocessorer.

Habana- og Graphcore ResNet-50-resultaterne var på henholdsvis 3,4 minutter og 3,8 minutter. Det kan sammenlignes med 4,5 minutter, som kræves af Nvidias 7. plads, et 64-vejs A100-system med 16 EPYC-processorer.

Som i junirapporten, første gang Graphcore deltog, understregede virksomheden vigtigheden af at finde en balance mellem ydeevne og omkostninger ved de overordnede systemer. Virksomheden citerede time-to-time-toget ResNet-50 på 28 minutter på sit 16-vejssystem, et minut hurtigere end et sammenligneligt Nvidia DGXA100-system, der koster væsentligt mere, sagde det.

“Vores POD-16 klarer sig bedre end en DGXA100… og det er halvdelen af listeprisen af DGXA100,” sagde Dave Lacey, Graphcores chefsoftwarearkitekt, i en mediebriefing.

En stor del af omkostningsfordelen kommer fra at have en mindre forhold mellem Intel- eller AMD x86-værtsprocessorer i forhold til IPU-chips, sagde Graphcore.

Graphcore kom på en sjetteplads efter Nvidia-chips for topresultater, der trænede standard BERT-modellen, med næsten 7 minutter mod 3 minutter for Nvidia-system på femtepladsen. Graphcore-systemet brugte dog kun 4 AMD EPYC-processorer mod 16 i det Nvidia-baserede system.

“Værtsprocessorprisen er en væsentlig del af omkostningerne ved et system,” sagde Lacey. “Som enhver dyr ressource bruger du kun det, du har brug for.”

Graphcore gør kabinettet til dets lave forhold mellem værtsprocessor – Intel eller AMD x86 — til acceleratorchip er en mere effektiv model for AI-behandling, der fører til betydelige omkostningsbesparelser.

Graphcore

Adspurgt om Googles pointe med hensyn til store neurale netopgaver sagde Lacey, at de vigtigste MLPerf-resultater fungerer godt som en proxy for opgaver i den virkelige verden.

Ud over individuelle leverandørpræstationer demonstrerer MLPerf benchmark den samlede chipindustris præstation med at fremskynde ydeevnen på neurale netværk, sagde MLCommons Chair Kanter.

“Hvis du ser på banen for de bedste resultater i MLPerf træning over tid kan du se, at det er dramatisk hurtigere end Moores lov,” sagde Kanter med henvisning til halvleder-tommelfingerregelen i mange årtier om, at transistortætheden fordobles omtrent hver 18. måned, hvilket fører til en fordobling i ydeevnen.

< p>“Gennem optimeringer til arkitektur, til systemstørrelse, til software, til modelopdeling,” sagde Kanter, formår leverandører at fremskynde neurale netydelser så meget som 11 gange hurtigere end Moores lovs historiske bane.

Benchmark-pakken fortsætter med at få støtte fra leverandører med flere deltagere og flere indsendelser. De rapporterede resultater for alle benchmarks i alt var 175, op fra 144 i junirapporten.

Nye leverandører deltog i konkurrencen denne gang. Samsung Electronics indsendte for eksempel resultater fra sin supercomputer ved hjælp af 256 AMD-chips og 1.024 Nvidia A100'er. Dette system, ved hjælp af nogle ikke-standard software tweaks, havde den næsthurtigste score af alle systemer til at træne den normale version af BERT, kun 25 sekunder.

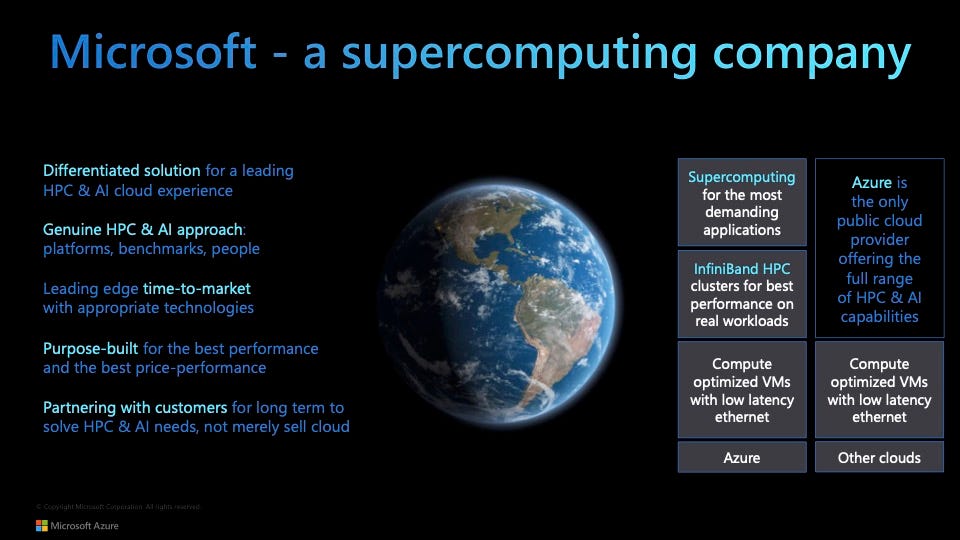

Også en nykommer denne gang var Microsofts Azure cloud-tjeneste, som rapporterede resultater for 19 indsendelser ved brug af AMD-processorer og Nvidia A100'er i forskellige konfigurationer. Azure vandt to af de fem øverste pladser i syv ud af de otte benchmark-tests.

Og ét Azure-system tog topscore for at træne en billedsegmenteringsmodel på medicinske data (KiTS19-udfordringen) ved hjælp af 192 AMD EPYC-processorer og 768 A100'er.

“Vi ønsker at demokratisere supercomputing,” sagde Nidhi Chappell, leder af high-performance computing og AI hos Azure, til ZDNet.

Hun sagde, at det at lave kommercielt tilgængelige systemer, såsom 768-vejs AI100-systemet, i skyen har “samlet det bedste fra HPC og AI, i stedet for at tage en vaniljesky, der tjener enhver arbejdsbyrde.”

“AI-træning er et HPC-problem, og vores ekspertise inden for HPC har hjulpet os med at opbygge AI i stor skala,” sagde hun. “Vi vil bygge infrastruktur, der er optimeret til stor skala.” Dette inkluderer systemer, der har så mange som 80.000 kerner.

Microsoft viser sin Azure cloud-tjenesten “demokratiserer højtydende computing” med sin første MLPerf-træningsindsendelse, udført i samarbejde med Nvidia.

Microsoft Azure

En vigtig grund til at deltage i MLPerf, sagde Chappell, var at vise, at et så stort arbejde kan præstere lige så godt i et cloudmiljø som det gør on-premise.

“Det, vi har bevist, er, at vi har været i stand til at maskere overheaden af cloud-virtualisering; den overhead er stort set fjerntliggende i skyen,” så det ikke trækker ydeevnen ned, sagde hun.

p>

Forespurgt om store modeller i forhold til standard MLPerf-opgaver sagde Chappell “det er kun et spørgsmål om tid”, før Azure indsender nogle ikke-standardiserede, store værker, der ligner det, Google har gjort i Open-divisionen.

“Det vil ske.”

Samtidig er standard MLPerf-testene i den lukkede division nyttige, sagde hun, fordi de “viser, hvor hurtigt AI udvikler sig; det er en konstant optimeringsproces.”

Også: AI:s etik: Fordele og risici ved kunstig intelligens

Chappells samarbejdspartner hos Nvidia, Shar Narasimhan, Nvidias senior group product manager for dets datacenterprodukter, sagde i samme briefing, at MLPerfs standardtests har den dyd, at de er som en ensartet bane, hvor mange atleter konkurrerer på et jævnt felt.

“Det tjener som en mulighed for alle at løbe nøjagtigt det samme løb og sammenligne resultaterne direkte,” sagde Narasimhan. “Når vi ser på de olympiske resultater, har vi haft nøjagtig den samme bane i mere end et århundrede, og det giver dig mulighed for at sammenligne løbet, der blev kørt for 100 år siden med [den jamaicanske sprinter] Usain Bolts resultater.”

< p>Med verdens største publicerede NLP-model, Megatron-Turing, ser det selvfølgelig ud til, at Nvidia og Azure kunne tilbyde en ny indsendelse af store modeller, som Google gjorde.

“Vi kan ikke sammenligne disse modeller med nogen andre,” forklarede Narasimhan, så det er svært at gøre sådan et arbejde nyttigt i forbindelse med MLPerf. Nvidia har ikke forpligtet sig til fremtidige indsendelser af store modeller.

Med hensyn til det, der er vigtigt for industrien, sagde Narasimhan, er, at mange virksomheder ønsker at bruge AI til fokuserede formål, “ikke en gigantisk sprogmodel, der har brug for 4.000 chips for at køre.” De mindre benchmarks kan bruges til at forudse arbejdsbyrder og ydeevne, sagde han.

Googles Selvan sagde, at Google har til hensigt at fortsætte med at underkaste sig MLPerfs lukkede divisions benchmarks i fremtiden.

“Vi vil se alle tilbage i den lukkede division næste år – forhåbentlig kan vi ikke love, men vi planlægger at være der,” sagde han.

Teknologisk indtjening

3. kvartals smartphonesalg falder 6,8 %, da efterspørgslen overstiger komponentforsyninger HP rapporterer stærke resultater for 4. kvartal, stigninger i 1. kvartal Dell ser kommerciel pc-boom i 3. kvartal VMware slår estimater for 3. kvartal med en omsætning på 11 % Best Buy 3. kvartal bedre end forventet , men bruttomargener under pres Pure Storage slår forventningerne til 3. kvartal, hæver udsigterne Zoom lander flere store kunder i 3. kvartal, slår markedsestimaterne Workday opkøber VNDLY for 510 millioner dollars, rapporterer stærk hardware i 3. kvartal | Digital transformation | CXO | Internet of Things | Innovation | Enterprise Software