Et Google-datasenter med stativer med TPU-versjon 4-akseleratorbrikker for knusende maskinlæring. Google brukte en klynge på 2048 TPU-er for å trene opp sin største versjon av BERT-programmet for naturlig språk noensinne, bestående av 481 milliarder parametere, på 19 timer, som en innsending til MLPerf-benchmark-konkurransen.

< p>Den dyplæringsverden av kunstig intelligens er besatt av størrelse.

Deep learning-programmer, som OpenAIs GPT-3, fortsetter å bruke flere og flere GPU-brikker fra Nvidia og AMD – eller nye typer akseleratorbrikker – for å bygge stadig større programvare. Nøyaktigheten til programmene øker med størrelsen, hevder forskere.

Denne besettelse med størrelse ble vist for full visning onsdag i de siste industrireferanseresultatene rapportert av MLCommons, som setter standarden for å måle hvor raskt databrikker kan knuse dyp læringskode.

Google bestemte seg for å ikke sende inn noen standard benchmark-tester for dyp læring, som består av programmer som er veletablerte på feltet, men relativt utdaterte. I stedet viste Googles ingeniører frem en versjon av Googles BERT-program for naturlig språk, som ingen andre leverandører brukte.

MLPerf, referansepakken som brukes til å måle ytelse i konkurransen, rapporterer resultater for to segmenter: standard “Lukket” divisjon, der de fleste leverandører konkurrerer på veletablerte nettverk som ResNet-50; og “Open”-divisjonen, som lar leverandører prøve ut ikke-standardiserte tilnærminger.

Det var i Open-divisjonen Google viste en datamaskin som brukte 2048 av Googles TPU-brikker, versjon 4. Den maskinen klarte å utvikle BERT-programmet på omtrent 19 timer.

Også: AI på seksti sekunder

BERT-programmet, et nevralt nettverk med 481 milliarder parametere, hadde ikke tidligere vært avslørt. Den er over tre størrelsesordener større enn standardversjonen av BERT i omløp, kjent som “BERT Large”, som har bare 340 millioner parametere. Å ha mange flere parametere krever vanligvis mye mer datakraft.

Google sa at den nye innsendingen gjenspeiler den økende betydningen av skala i AI.

< p>Google sendte inn den nye versjonen av sitt BERT-språkprogram i “Open”-avdelingen av MLPerf. Graphcore og Samsung var de to andre leverandørene som deltok i denne divisjonen.

< p>Google sendte inn den nye versjonen av sitt BERT-språkprogram i “Open”-avdelingen av MLPerf. Graphcore og Samsung var de to andre leverandørene som deltok i denne divisjonen.

MLCommons

“Vår tankegang denne gangen er at vi alltid har vært opptatt av å sørge for at våre innleveringer til MLPerf er godt tilpasset våre interne behov, og behovene til ML-industrien,” sa Aarush Selvan, som fører tilsyn med maskinlæringsinfrastruktur for Google, i en mediebriefing.

“Og så, opplæring av store modeller — modeller i størrelsesorden titalls eller hundrevis av milliarder av parametere, og til og med en billion parametere og over, er stadig viktigere både innen Google — det er et stort sett med fokus for vår forskning og vår produksjon – men også for våre skykunder.”

MLPerf-testpakken er opprettelsen av MLCommons, et industrikonsortium som utsteder flere årlige benchmark-evalueringer av datamaskiner for de to delene av maskinlæring: såkalt trening, der et nevralt nettverk bygges ved å ha innstillingene foredlet i flere eksperimenter; og såkalt inferens, hvor det ferdige nevrale nettverket gjør spådommer etter hvert som det mottar nye data.

Onsdagens rapport er den siste referansetesten for treningsfasen. Den følger den tidligere rapporten i juni.

De fullstendige MLPerf-resultatene ble diskutert i en pressemelding på MLCommons-nettstedet. De fullstendige dataene om innsendinger kan sees i tabeller som er lagt ut på nettstedet.

Også: Graphcore bringer ny konkurranse til Nvidia i de siste MLPerf AI-standardene< /p>

Googles Selvan sa at MLCommons burde vurdere å inkludere flere store modeller. De eldre, mindre nettverkene som ResNet-50 “gir oss bare en proxy” for storskala treningsytelse, sa han.

“Å kaste 4000 sjetonger for å trene BERT på bare noen få sekunder er veldig kult,” observerte Selvan, med henvisning til den mindre versjonen av BERT de fleste leverandører fokuserer på i Closed-divisjonen.

“Og viser noen aspekter ved skalerbarhet. , men det er egentlig bare en proxy, for i det virkelige liv bruker du aldri så mange sjetonger for å trene den lille modellen.”

“Å kaste 4000 sjetonger for å trene BERT på bare noen få sekunder er veldig kult,” observerte Selvan, med henvisning til den mindre versjonen av BERT de fleste leverandører fokuserer på i Closed-divisjonen. “Og viser frem noen aspekter ved skalerbarhet, men det er egentlig bare en proxy, for i det virkelige liv bruker du aldri så mange sjetonger for å trene den lille modellen.”

MLCommons

Den manglende komponenten, sa Selvan, er den såkalte effektiviteten til systemene når de blir større. Google var i stand til å kjøre sin gigantiske BERT-modell med 63 % effektivitet, sa han til ZDNet, målt ved antall flytepunktoperasjoner per sekund utført i forhold til en teoretisk kapasitet. Det, sa han, var bedre enn det nest høyeste bransjeresultatet, 52 %, oppnådd av Nvidia i utviklingen av sin Megatron-Turing-språkmodell utviklet med Microsoft.

“Fremover synes vi det ville vært kjempebra å ha en slags benchmark for store modeller i MLPerf-konkurransen,” sa Selvan.

David Kanter, administrerende direktør i MLCommons, sa at beslutningen om å ha store modeller bør overlates til medlemmene av Commons å bestemme kollektivt. Han påpekte imidlertid at bruk av små nevrale nettverk som tester gjør konkurransen tilgjengelig for flere parter.

“Poenget med en benchmark er å være rettferdig og representativ, men også å ikke slå noen som driver den konkurs,” sa Kanter.

“I teorien kan vi gjøre trening GPT-3 til en MLPerf-referanse,” la Kanter til, med henvisning til språkmodellen med 175 milliarder parametere introdusert av OpenAI i fjor som et toppmoderne naturlig språk modell.

“Poenget med en benchmark er å være rettferdig og representativ, men også å ikke slå noen som driver den konkurs,” sa MLCommons styreleder Kanter. “I teorien kan vi gjøre trening GPT-3 til en MLPerf -referanse … Utfordringen er at trening GPT-3 er ganske beregningsmessig dyr. Det koster titalls millioner dollar.”

MLCommons

“Utfordringen er at trening av GPT-3 er ganske beregningsmessig dyrt. Det koster titalls millioner dollar.”

Derimot er standardtestene til MLPerf, hvis kode er tilgjengelig for alle, en ressurs enhver AI-forsker kan ta for å replikere testene – uten å ha eksotiske tilnærminger til beregning, sa Kanter.

“På den måten produserer den disse svært verdifulle tekniske artefaktene for hele fellesskapet og bidrar til å drive industrien fremover.”

Google har ingen planer om å publisere på den nye BERT-modellen, Selvan fortalte ZDNet i en e-post, og beskrev det som “noe vi gjorde bare for MLPerf.” Programmet ligner på design skissert i forskning av Google tidligere i år på svært parallelliserte nevrale nettverk, sa Selvan.

Til tross for nyheten til BERT-programmet med 481 milliarder parametere, er det representativt for oppgaver i den virkelige verden fordi det bygger på kode fra den virkelige verden.

“Vi tror at disse benchmarkene vi sendte inn, fordi de utnytter en stablet transformatorarkitektur, er ganske realistiske når det gjelder beregningsegenskapene deres med eksisterende store språkmodeller som har blitt publisert,” sa Selvan til ZDNet.< /p>

I likhet med de mindre innleveringene i MLPerf, ble den gigantiske BERT-modellen trent til å produsere resultater med en viss nøyaktighet, forklarer Selvan. I dette tilfellet, 75 % nøyaktighet i spådommer, over 72,2 % som kreves av MLPerf.

Nvidia-brikker tok igjen brorparten toppscore for å trene nevrale nett, med litt hjelp denne gangen fra Microsoft Azure.

Nvidia

Google-programmet var også avhengig av færre eksempler på tekstdata for å oppnå samme nøyaktighet som resultatene for lukket divisjon fra andre leverandører. Den lukkede divisjonen krever et program for å trene med nesten en halv milliard sekvenser av tokens, for det meste med en lengde på 128 tokens per sekvens. Google-programmet ble trent ved å bruke bare rundt 20 millioner tokens, men med en lengde på 512 tokens per sekvens. Arbeidet er omtalt mer detaljert i et blogginnlegg fra Google.

Systemet på 2048 TPU som Google brukte til å utføre arbeidet, er for tiden tilgjengelig som en Google Cloud-tjeneste.

Resten av MLPerf-resultatene, for det meste i den lukkede divisjonen, viser at Nvidia og andre leverandører fortsetter å gjøre fremskritt med å redusere tiden det tar å trene standardversjonene av ResNet, BERT og andre oppgaver.

Nvidia tok som alltid brorparten av toppresultatene. For eksempel tok datamaskiner som bruker den siste generasjonen av GPU, A100, de fire øverste plassene for den raskeste tiden å trene ResNet-50, den raskeste var bare 21 sekunder. Det var med 4320 A100-er som opererer parallelt, ved hjelp av 1080 AMDs EPYC x86-prosessorer. Resultatet var en forbedring i forhold til de 24 sekundene Nvidia noterte i junirapporten.

Der systemer brukte færre Nvidia-brikker og færre vertsprosessorer, klarte imidlertid konkurrentene å score høyere enn Nvidia. Intels Habana Labs tok femteplassen i ResNet-50 med 256 av Habanas Gaudi-akseleratorbrikker overvåket av 128 Intel Xeons.

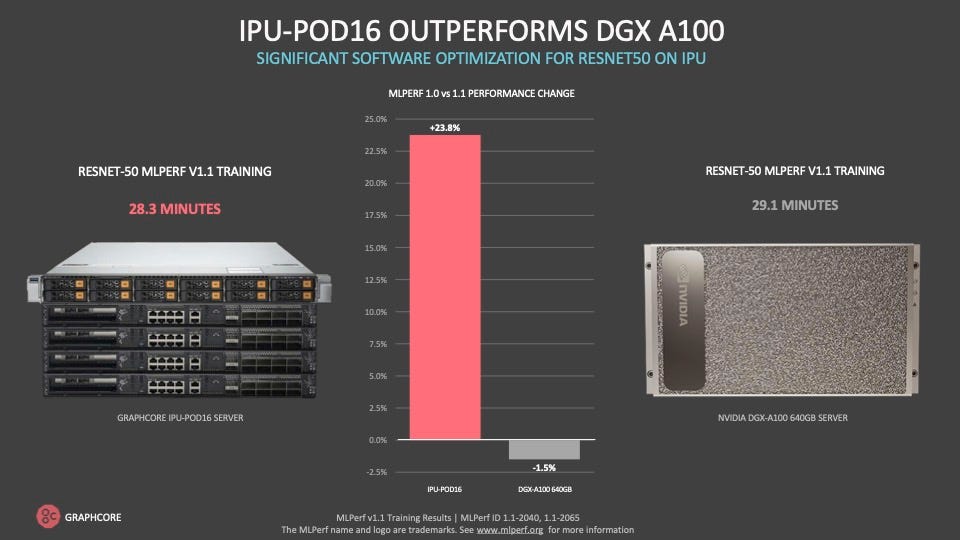

Graphcore gjorde tilfellet at den kan levere bedre resultater til mye lavere kostnader enn Nvidias systemer , en større del av besparelsene er færre vertsprosessorer fra Intel eller AMD som trengs for et tilsvarende antall AI-akseleratorer.

Graphcore

Og Graphcore, den Bristol, Storbritannia-baserte oppstarten som viste best poengsum i junirapporten for et to-prosessorsystem på BERT-trening, tok sjetteplassen på ResNet-50 med en ny versjon av sin IPU-POD-datamaskin som bruker 256 av sine IPU-akseleratorbrikker og 32 AMD EPYC-vertsprosessorer.

Habana- og Graphcore ResNet-50-resultatene var henholdsvis 3,4 minutter og 3,8 minutter. Det kan sammenlignes med 4,5 minutter som kreves av Nvidias 7. plass, et 64-veis A100-system med 16 EPYC-prosessorer.

Som i junirapporten, første gang Graphcore deltok, understreket selskapet viktigheten av å finne en balanse mellom ytelse og kostnad for de overordnede systemene. Selskapet siterte tid-til-tid-toget ResNet-50 på 28 minutter på sitt 16-veis system, et minutt raskere enn et sammenlignbart Nvidia DGXA100-system som koster vesentlig mer, heter det.

“Vår POD-16 overgår en DGXA100… og det er halvparten av listeprisen av DGXA100,” sa Dave Lacey, Graphcores sjefprogramvarearkitekt, i en mediebriefing.

Mye av kostnadsfordelen kommer fra å ha en mindre forhold mellom Intel- eller AMD x86-vertsprosessorer i forhold til IPU-brikker, sa Graphcore.

Graphcore kom på sjetteplass bak Nvidia-brikker for toppscore som trener standard BERT-modellen, med nesten 7 minutter mot 3 minutter for Nvidia-system på femteplass. Graphcore-systemet brukte imidlertid bare 4 AMD EPYC-prosessorer mot 16 i det Nvidia-baserte systemet.

“Vertsprosessorprisen er en betydelig del av kostnadene for et system,” sa Lacey. “Som enhver dyr ressurs bruker du bare det du trenger.”

Graphcore gjør kabinettet til det lave forholdet mellom vertsprosessor – Intel eller AMD x86 — til akseleratorbrikken er en mer effektiv modell for AI-behandling som fører til betydelige kostnadsbesparelser.

Graphcore

På spørsmål om Googles poeng angående store nevrale nettoppgaver, sa Lacey at de viktigste MLPerf-resultatene fungerer godt som en proxy for oppgaver i den virkelige verden.

I tillegg til individuelle leverandørprestasjoner, demonstrerer MLPerf-referansen den totale brikkeindustriens prestasjon med å øke hastigheten på ytelsen på nevrale nettverk, sa MLCommons-styreleder Kanter.

“Hvis du ser på banen for de beste resultatene i MLPerf-trening. over tid kan du se at det er dramatisk raskere enn Moores lov,” sa Kanter, med henvisning til halvleder-tommelfingerregelen i mange tiår om at transistortettheten dobles omtrent hver 18. måned, noe som fører til en dobling i ytelse.

< p>“Gjennom optimaliseringer av arkitektur, til systemstørrelse, til programvare, til modellpartisjonering,” sa Kanter, klarer leverandører å øke hastigheten på nevrale nettytelse så mye som 11 ganger raskere enn Moores lovs historiske bane.

Referansepakken fortsetter å få støtte fra leverandører, med flere deltakere og flere innsendinger. Resultatene rapportert for alle referanseindeksene til sammen var 175, opp fra 144 i junirapporten.

Nye leverandører ble med i konkurransen denne gangen. Samsung Electronics sendte for eksempel inn resultater fra sin superdatamaskin med 256 AMD-brikker og 1024 Nvidia A100-er. Dette systemet, med hjelp av noen ikke-standard programvarejusteringer, hadde den nest raskeste poengsummen av alle systemer for å trene normalversjonen av BERT, bare 25 sekunder.

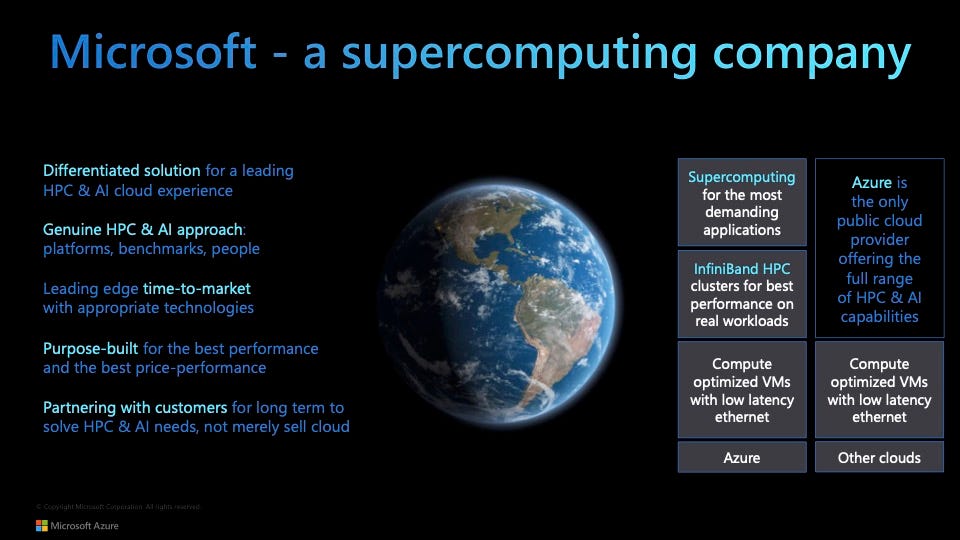

En nykommer denne gangen var også Microsofts Azure-skytjeneste, som rapporterte resultater for 19 innsendinger ved bruk av AMD-prosessorer og Nvidia A100-er i ulike konfigurasjoner. Azure vant to av de fem øverste plassene i syv av de åtte referansetestene.

Og ett Azure-system tok toppscore for å trene en bildesegmenteringsmodell på medisinske data (KiTS19-utfordringen), ved bruk av 192 AMD EPYC-prosessorer og 768 A100-er.

“Vi ønsker å demokratisere superdatabehandling,” sa Nidhi Chappell, leder for høyytelses databehandling og AI hos Azure, til ZDNet.

Hun sa at det å lage kommersielt tilgjengelige systemer, som 768-veis AI100-systemet, i skyen har “samlet det beste fra HPC og AI, i stedet for å ta en vaniljesky som betjener enhver arbeidsbelastning.”

“AI-opplæring er et HPC-problem, og vår ekspertise på HPC har hjulpet oss med å bygge AI i stor skala,” sa hun. “Vi ønsker å bygge infrastruktur som er optimalisert for stor skala.” Dette inkluderer systemer som har så mange som 80 000 kjerner.

Microsoft viser sin Azure skytjenesten «demokratiserer høyytelses databehandling» med sin første MLPerf-treningsinnlevering, utført i samarbeid med Nvidia.

Microsoft Azure

En viktig grunn til å delta i MLPerf, sa Chappell, var å vise at et slikt stort arbeid kan prestere like godt i et skymiljø som det gjør på stedet.

“Det vi har bevist er at vi har vært i stand til å maskere overheaden til skyvirtualisering; den overheaden er ganske fjerntliggende i skyen,” slik at det ikke trekker ned ytelsen, sa hun.

p>

På spørsmål om store modeller versus standard MLPerf-oppgaver, sa Chappell “det er bare et spørsmål om tid” før Azure sender inn noen ikke-standardiserte, store arbeider som ligner på det Google har gjort i Open-divisjonen.

“Det vil skje.”

Samtidig er standard MLPerf-testene i den lukkede divisjonen nyttige, sa hun, fordi de “viser hvor raskt AI utvikler seg; det er en konstant prosess med optimalisering.”

Også: Etikk ved AI: Fordeler og risikoer ved kunstig intelligens

Chappells samarbeidspartner i Nvidia, Shar Narasimhan, Nvidias senior gruppe produktsjef for sine datasenterprodukter, sa i samme orientering at MLPerfs standardtester har den fordelen å være som en enhetlig bane hvor mange idrettsutøvere konkurrerer på et jevnt felt.

“Det fungerer som en mulighet for alle til å løpe nøyaktig det samme løpet, og sammenligne resultatene mot hverandre,” sa Narasimhan. “Når vi ser på OL-resultater, har vi hatt nøyaktig samme bane i mer enn et århundre, og det lar deg sammenligne løpet som ble kjørt for 100 år siden med [den jamaicanske sprinteren] Usain Bolts resultater.”

< p>Selvfølgelig, med verdens største publiserte NLP-modell, Megatron-Turing, ser det ut til at Nvidia og Azure kunne tilby en ny innsending av store modeller slik Google gjorde.

“Vi kan ikke sammenligne disse modellene. med noen andre,” forklarte Narasimhan, så det er vanskelig å gjøre slikt arbeid nyttig i sammenheng med MLPerf. Nvidia har ikke forpliktet seg til fremtidige innsendinger av store modeller.

Når det gjelder det som er viktig for industrien, sa Narasimhan, er at mange selskaper ønsker å bruke AI til fokuserte formål, “ikke en gigantisk språkmodell som trenger 4000 brikker for å kjøre.” De mindre referansene kan brukes til å forutse arbeidsbelastninger og ytelse, sa han.

Googles Selvan sa at Google har til hensikt å fortsette å underkaste seg referanseindeksene for lukket divisjon til MLPerf i fremtiden.

“Vi vil se alle tilbake i den lukkede divisjonen neste år – forhåpentligvis kan jeg ikke love det, men vi planlegger å være der,” sa han.

Teknikkinntekter

Smarttelefonsalget for tredje kvartal faller 6,8 % ettersom etterspørselen overgår komponentforsyninger HP rapporterer sterke resultater for fjerde kvartal, oppganger for første kvartal Dell ser kommersiell PC-boom i tredje kvartal VMware slår estimater for tredje kvartal med inntekter opp 11 % Best Buy tredje kvartal bedre enn forventet , men bruttomarginer under press Pure Storage slår forventningene til 3. kvartal, øker utsiktene Zoom lander flere store kunder i 3. kvartal, slår markedsestimatene Workday kjøper VNDLY for 510 millioner dollar, melder sterk maskinvare i 3. kvartal | Digital transformasjon | CXO | Internet of Things | Innovasjon | Enterprise Software