Die Welt wird von einer künstlichen Intelligenzsoftware überschwemmt, die sich in einem Aufkleber an einem Laternenpfahl befinden könnte.

Was TinyML genannt wird, eine breite Bewegung zum Schreiben von KI-Formen für maschinelles Lernen, die auf Geräten mit sehr geringem Stromverbrauch ausgeführt werden können, erhält jetzt eine eigene Suite von Benchmark-Tests für Leistung und Stromverbrauch.

Der Test, MLPerf, ist die Gründung von MLCommons, einem Industriekonsortium, das bereits jährliche Benchmark-Bewertungen von Computern für die beiden Teile des maschinellen Lernens herausgibt, das sogenannte Training, bei dem ein neuronales Netzwerk aufgebaut wird, indem seine Einstellungen in mehreren Experimenten verfeinert werden ; und die sogenannte Inferenz, bei der das fertige neuronale Netz Vorhersagen trifft, wenn es neue Daten empfängt.

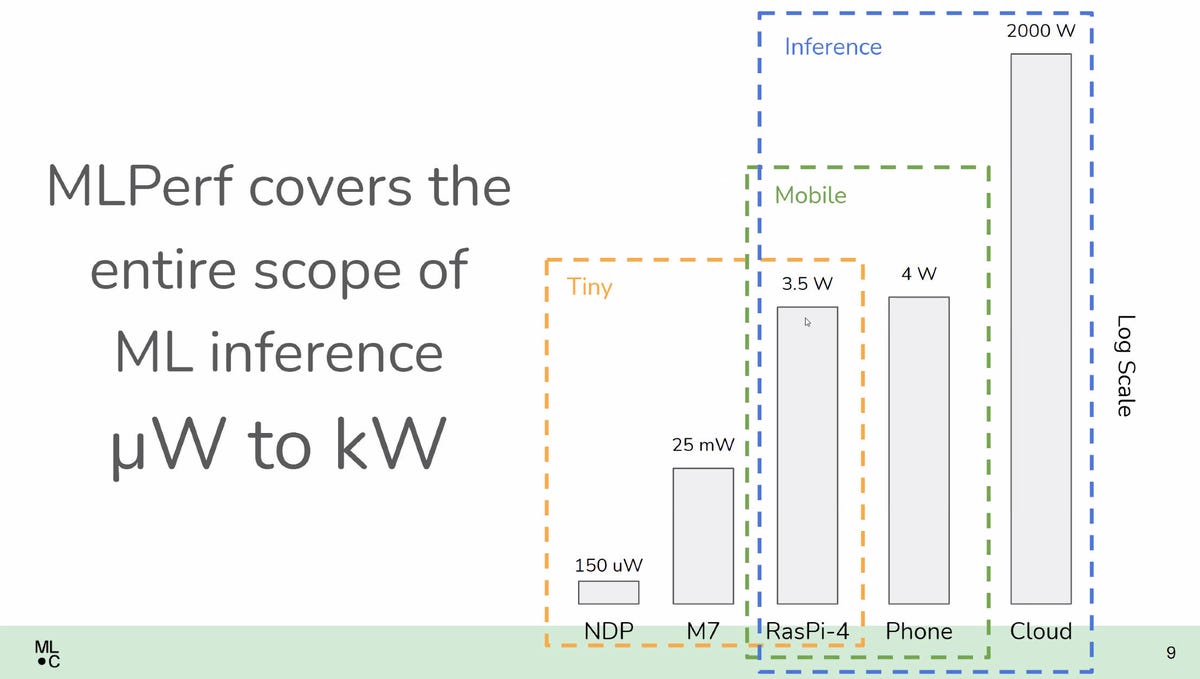

Diese Benchmark-Tests konzentrierten sich jedoch auf konventionelle Computergeräte, von Laptops bis hin zu Supercomputern. MLPerf Tiny Inference, wie die neue Prüfung heißt, konzentriert sich auf die neue Grenze von Dingen, die auf Smartphones laufen, bis hin zu Dingen, die dünn wie eine Briefmarke sein könnten, ganz ohne Batterie.

Die Referenzimplementierung für MLPerf Tiny Inference testet, wie viel Latenz anfällt und wie viel Energie verbraucht wird, indem vier repräsentative maschinelle Lernaufgaben auf einer ARM-basierten Mikrocontrollerplatine von ST MIcroelectronics Nucleo für eingebettete Systeme ausgeführt werden.

“Dies vervollständigt das Benchmark-Spektrum von Mikrowatt bis Megawatt”, sagte David Kanter, der Executive Director von MLCommons, dem Branchenkonsortium, das MLPerf beaufsichtigt, in einem Briefing mit der Presse.

Auch: Der Leistungsbenchmark der KI-Branche, MLPerf, misst zum ersten Mal auch den Energieverbrauch des maschinellen Lernens

Die Tests messen die Latenz in Millisekunden und den Stromverbrauch in Mikro-Jules, um vier repräsentative maschinelle Lernvorgänge abzuschließen Aufgaben, wobei niedriger in beiden Fällen besser ist. Dies ist das zweite Mal, dass ML Commons eine Energiemessung eingeführt hat. Im April führte die Gruppe eine Messung der verwendeten Wechselstromleistung in Watt in den bestehenden MLPerf-Inferenztest ein.

TinyML stellt ziemlich Aufgaben dar, die vielen Benutzern von Mobilgeräten vertraut sind, beispielsweise das Aktivierungswort, das ein Telefon aktiviert, wie “Hey, Google” oder “Hey, Siri”. (Warden vertraute dem Publikum lachend an, dass er und seine Kollegen “Hey, Google” im Büro als “Hey, G” bezeichnen müssen, damit die Telefone des anderen nicht ständig klingeln.)

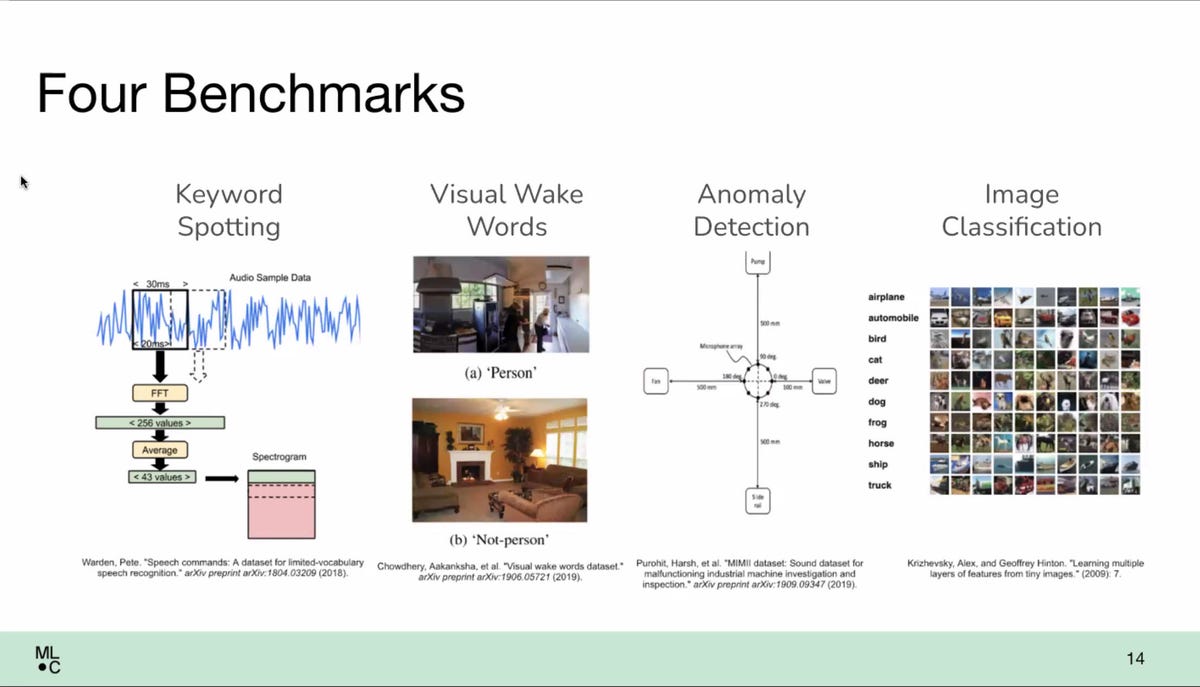

In diesem Fall umfassten die vier Aufgaben das Erkennen von Schlüsselwörtern, aber auch drei weitere: sogenannte visuelle Weckwörter, bei denen ein Objekt in einem Sichtfeld eine Aktivität auslöst (denken Sie an eine Videotürklingel); Bildklassifizierung auf dem weit verbreiteten CIFAR-10-Datensatz; und Anomalieerkennung, ein visuelles Inspektionssystem, das in einer Fabrikhalle verwendet werden könnte.

Der Benchmark wurde von Making erstellt eine Referenzimplementierung, bei der diese vier Aufgaben auf einer kleinen eingebetteten Computerplatine ausgeführt werden, dem Nucleo-L4R5ZI von ST Microelectronics, das einen eingebetteten ARM Cortex-M4-Prozessor ausführt.

Der Nucleo wird von ML Commons als ausreichend weit verbreitet angesehen, um Geräte mit sehr geringem Stromverbrauch darzustellen. Auf dem Nucleo lief Googles Softwaresystem für TinyML namens TensorFlow Lite, in diesem Fall eine speziell für Mikrocontroller entwickelte Version.

Vier Gruppen reichten ihre Ergebnisse für den Benchmark ein: Syntiant, ein in Irvine, Kalifornien, ansässiger Entwickler von KI-Prozessoren; LatentAI, ein in Menlo Park, Kalifornien, ansässiges Spin-out des Forschungsinstituts SRI International, das ein Entwickler-SDK für KI herstellt; Peng Cheng Laboratory, ein Forschungslabor in Shenzen, China; und hls4ml, eine Sammlung von Forschern des Fermilab, der Columbia University, der UC San Diego und des CERN.

Syntiant hat den Benchmark auf einem ARM Cortex-M0-Prozessor ausgeführt, während LatentAI ein Raspberry Pi 4-System mit einem Broardcom-Chip verwendet und hls4ml einen Xilinx-Prozessor auf einem Pynq-Z2-Entwicklungsboard verwendet.

Die vielleicht interessanteste Einreichung aus Hardware-Sicht war der kundenspezifische Prozessor von Peng Cheng Laboratory, der von Chinas Semiconductor Manufacturing International hergestellt wurde. Dieser Teil führt den offenen RISC-V-Befehlssatz aus, ein Projekt der University of California in Berkeley, das als Alternative zu ARM-Chipbefehlen zunehmend Unterstützung findet.

Ein offizielles Papier, das den Benchmark beschreibt, steht auf OpenReview.net zum Download bereit, verfasst von zwei der akademischen Berater der Organisation, Colby Banbury und Vijay Janapa Reddi von der Harvard University, zusammen mit mehreren beitragenden Autoren. Dieses Papier wurde auf der diesjährigen NeurIPS, der größten akademischen Konferenz des KI-Bereichs, eingereicht.

Der Benchmark wurde über einen Zeitraum von achtzehn Monaten durch gemeinsame Beiträge von ML Commons-Arbeitsmitgliedern erstellt, darunter Vertreter des CERN, der Columbia University und der UC San Diego, Google, der Chiphersteller Infineon, Qualcomm, Silicon Labs, STMicro und Renesas, KI-Startup SambaNova System- und Chipdesign-Softwarehersteller Synopsys, unter anderem.

Reddi von Harvard sagte, das Design sei das Ergebnis sowohl einer Abstimmung durch diese Berater als auch eines Auswahlprozesses aus den Vorschlägen.

“Es wird durch Abstimmungen getrieben, aber wir möchten verstehen, was das Feedback von Verbrauchern oder Kunden ist”, sagte Reddi.

“Es gibt ein Element des Gruppenkonsens, und es gibt ein Element der Machbarkeit”, sagte Kanter und meinte damit, sich mit den Grenzen dessen auseinanderzusetzen, welche Datensätze in der Praxis für Tests verwendet werden können. „Wenn Sie keinen echten Datensatz auswerten, werden Sie keine überaus aussagekräftigen Ergebnisse erzielen“, sagte er. Datensätze wie CIFAR-10 stellen sicher, dass die Ergebnisse “vergleichbar und gut anerkannt” sind, fügte er hinzu.

“Das ist ein Gating-Faktor”, sagte Kanter über das Dataset-Problem. “Es gibt viele Anwendungen, bei denen wir gerne die Leistung messen würden, aber letztendlich schaut man sich die verfügbaren Ressourcen an, insbesondere da dies ein erster Versuch ist.”

Eine der größten Herausforderungen beim Benchmarking von TinyML besteht darin, dass der Software-Stack, alle Codierungsschichten von den Hardware-Befehlssätzen bis hin zu den Frameworks des maschinellen Lernens, wie Googles TensorFlow Lite, eine viel vielfältigere Sammlung von Software darstellen, als sie normalerweise in Programme, die für PCs und Supercomputer in TensorFlow, PyTorch und Nvidias CUDA-Software-Engine geschrieben wurden.

Die Tests ermöglichen es Unternehmen, die entweder ihre eigene Version eines neuronalen Netzwerkalgorithmus verwenden oder ein Standardmodell verwenden, das wie alle anderen auch als “offene” oder “geschlossene” Benchmark-Ergebnisse bezeichnet wird. beziehungsweise.

Eine zusätzliche Komplikation besteht darin, den genauen Leistungsbereich zu definieren. „Die Leistungsmessung für batteriebasierte Systeme ist eine große Herausforderung“, so Kanter. Die in der Testsuite verwendeten Embedded-Board-Systeme laufen in einem kontrollierten Testaufbau, in dem ihre absolute Laufzeitleistung für die Aufgaben von einem Power-Monitor, der die Leistung liefert, „abgefangen“ wird.

“Wir haben einfach das gesamte Batterie-Subsystem herausgeschnitten”, sagte Peter Torelli, Präsident des Embedded Microprocessor Benchmark Consortium, einer Gruppe, die seit Jahrzehnten die Leistung eingebetteter Systeme misst, die an der Energiekomponente des Benchmarks arbeiteten.

Außerdem: Maschinelles Lernen am Rande: TinyML wird groß

In der realen Welt, unterschiedliche Umstände werden jedes Gerät begrüßen, das tatsächlich in einem Mobiltelefon oder einem Fabrikgerät läuft. Googles Entwicklungsleiter für TinyML, Pete Warden, hat argumentiert, dass sich die Bemühungen von TinyML auf batteriebetriebene Geräte ohne Steckdosenanschluss konzentrieren sollten.

Warden hat vorgeschlagen, dass noch einfachere TinyML-Geräte Energy Harvesting verwenden könnten, so dass sie nicht einmal eine Batterie haben, sondern ihre Energie stattdessen über die Sonne oder über wärmeabgebende Organismen oder Strukturen in der Nähe erhalten.

Obwohl die ML Commons im Prinzip mit der Ansicht von Warden übereinstimmt, dass viele TinyML-Geräte nur über Batteriestrom oder Energy Harvesting verfügen, umfassen die Benchmarks Geräte wie den Raspberri Pi, die eine Wandstromquelle verwenden könnten. Mit 3,5 Watt Leistung ist der Raspberri Pi um einiges größer als die Mikrowatt der kleinsten Arten von eingebetteten Systemen.

Angesichts der Neuheit des Benchmarks, so Kanter, gibt es nur das Referenzsystem von Reddi und Banbury in Harvard bietet tatsächlich die Leistungsmessung in diesem ersten Ergebnissatz an; die vier anderen Einsender haben keine Leistungsmessungen vorgelegt.

“Wir erwarten für die nächste Runde einige Energiemessungen”, sagte er ZDNet per E-Mail.

Außerdem: Die KI-Führungskraft von Google sieht eine Welt von Billionen von Geräten, die nicht in menschlicher Obhut sind

Verwandte Themen:

Hardware Digitale Transformation CXO Internet of Things Innovation Unternehmenssoftware < img src="https://www.zdnet.com/a/hub/i/r/2018/09/04/c3df0f2d-c0dd-40e0-aac3-cf7a5effe212/thumbnail/40x40/a512fa125babb0e8085dab571e85ced1/tiernan-ray-author. jpg" class="" height="40" width="40" alt="Tiernan Ray" height="40" width="40" title="Um KI mit extrem geringem Stromverbrauch zu messen, erhält MLPerf einen TinyML-Benchmark"/>