Kulynych fick högsta belöningen tack vare sin upptäckt att Twitters algoritm tenderar att tillämpa ett “skönhetsfilter”.

Bild: Bogdan Kulynych

Twitter har prövat en metod utan motstycke för att hitta de dolda fördomarna i sina egna algoritmer.

Plattformen för sociala medier har registrerat externa forskare i en unik tävling, där vinnande deltagare var de som kunde komma med de mest övertygande bevisen som visar en orättvis praxis som utförs av en av företagets algoritmer.

Initiativet kallades “algoritmisk bias bounty-utmaning” och gav deltagarna full tillgång till koden som ligger till grund för Twitters bildbeskärningsalgoritm, som avgör hur bilder ska beskäras för att enkelt kunna ses när de kommer upp en användares tidslinje.

SE: Pentagon säger att dess nya AI kan se händelser “dagar i förväg”

Modellen är programmerad att uppskatta vad en person sannolikt kommer att vilja titta på i en bild – det vill säga den mest framträdande delen av bilden, varför den också kallas salthetsalgoritmen. Målet med utmaningen var att ta reda på om salthetsalgoritmen gör skadliga eller diskriminerande val, med löfte om att vinna priser från $ 500 till $ 3500.

Säkerhets- och integritetsingenjörsstudenten Bogdan Kulynych fick topppriset. Forskaren upptäckte att algoritmen tenderar att använda ett “skönhetsfilter”: det gynnar smalare, yngre ansikten, såväl som de med en ljus eller varm hudfärg och slät hudstruktur och stereotypiskt feminina ansiktsdrag.

“Jag såg tillkännagivandet på Twitter, och det verkade nära mina forskningsintressen – jag är för närvarande doktorand och jag fokuserar på integritet, säkerhet, maskininlärning och hur de korsar samhället,” Kulynych berättar ZDNet. “Jag bestämde mig för att delta och lyckades lägga upp något på en vecka.”

Det är ingen nyhet att Twitters salthetsalgoritm är problematisk. Förra året började plattformens användare märka att tekniken tenderade att välja vita människor framför svarta när de beskär, liksom manliga ansikten framför kvinnliga ansikten. Efter att ha genomfört en del egna undersökningar medgav företaget att modellen gjorde orättvisa val och tog bort salthetsalgoritmen helt och hållet och lanserade istället ett nytt sätt att visa standardformatfoton i sin helhet.

Men i stället för att definitivt lägga ifrån algoritmen, beslutade Twitter att göra modellens kod tillgänglig för forskare för att se om andra skadliga metoder kan dyka upp.

Om idén påminner om de bug -bounty -program som nu är normen inom säkerhetsbranschen, beror det på att konceptet bygger på exakt samma sak.

Av säkerhetsskäl ser bug -bounties att företag uppmanar säkerhetsexperter att hjälpa dem att identifiera sårbarheter i sina produkter innan hackare kan utnyttja dem till deras fördel. Och inom AI har experter länge funderat på att överföra konceptet till att upptäcka fördomar i algoritmer.

Twitter är det första företaget som har förvandlat konceptet till ett verkligt initiativ, och enligt Kulynych visar metoden lovande.

“Vi lyckades lägga upp något på mycket kort tid”, säger Kulynych till ZDNet. “Naturligtvis betyder det snabba tempot att det finns möjlighet till falskt positivt. Men i sig är det en bra sak eftersom det stimulerar dig att ta upp så många skador som möjligt, så tidigt som möjligt.”

Detta står i kontrast till hur akademiker hittills har försökt visa algoritmisk partiskhet och skada. Särskilt vid granskning av ett externt företags modeller kan denna process ta månader eller till och med år, delvis för att forskare inte har tillgång till algoritmens kod. Algoritmen bias bounty-utmaning, å andra sidan, är ett Twitter-ledt initiativ, vilket innebär att företaget öppnade tillgång till modellens kod för deltagare som vill undersöka.

SE: Kan AI förbättra dina upphämtningslinjer?

Det viktigaste var att utmaningen på sociala medier var det första testet i verkligheten av ett koncept som hittills mest har funnits i fantasin hos dem som studerar etisk AI. Och som med de flesta abstrakta idéer var en av de viktigaste punkterna att det inte finns någon metod för algoritmiska fördomar. Till skillnad från säkerhetsbuggar, som har väletablerade protokoll, regler och standarder, finns det inga bästa metoder när det gäller att upptäcka fördomar i AI.

Twitter har därför tagit fram en bransch först med fördjupad vägledning och metodik för de utmaningar som deltagarna ska följa när de försöker identifiera potentiella skador som salthetsalgoritmen kan införa-och det börjar med att definiera exakt vad som utgör en skada.

“I beskrivningen av tävlingen fanns en taxonomi av skador som var riktigt hjälpsam och ganska nyanserad”, säger Kulynych. “Det var ännu bredare än traditionella fördomar.”

Skadorna som definieras av Twitter har nedvärdering, stereotyper, felaktigt erkännande eller underrepresentation, men också rykte, psykologi eller till och med ekonomisk skada.

Plattformen för sociala medier bad sedan deltagarna att genomföra en blandning av kvalitativ och kvantitativ forskning och presentera sina resultat i en read-me-fil som beskriver deras resultat, tillsammans med en GitHub-länk som visar skadan. För att bedöma den mest övertygande forskningen övervägde Twitter kriterier som antalet drabbade användare eller sannolikheten för att skadan inträffar.

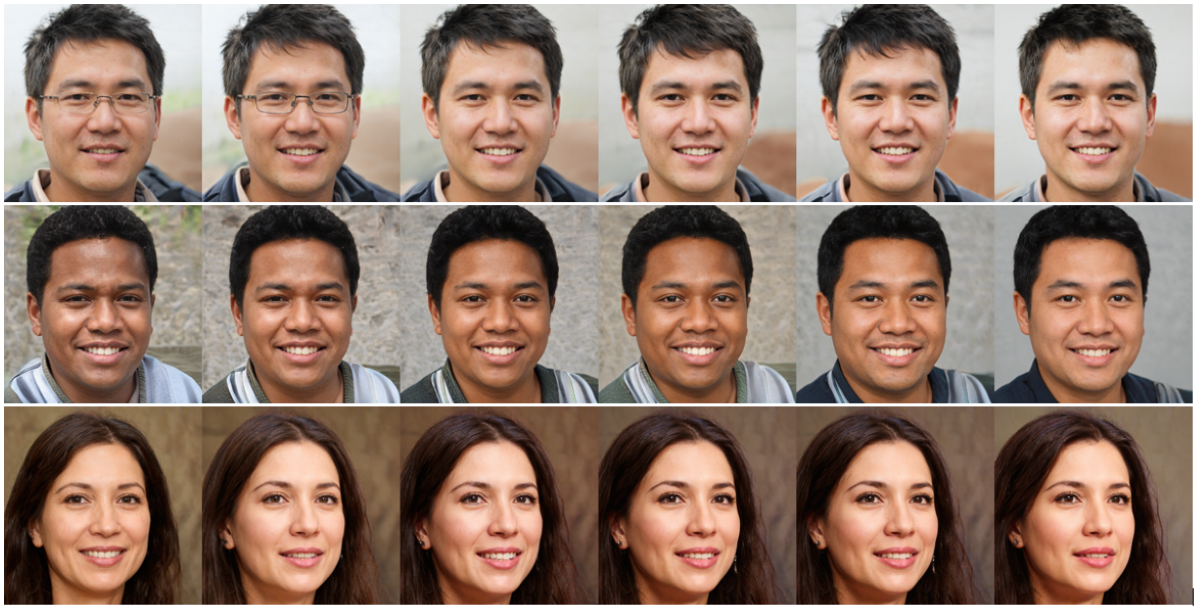

Kulynych började med att generera en uppsättning ansikten med en mycket sofistikerad ansiktsgenereringsalgoritm och modifierade sedan något av ansiktsfunktionerna något för att ta reda på vad som mest sannolikt skulle fånga uppmärksamheten hos salthetsalgoritmen. Han slutade med en uppsättning ansikten som alla uppnådde “maximal saliency” – och de verkade återspegla vissa skönhetsstandarder som var inarbetade i modellen.

Till exempel, i 37% av fallen var algoritmens uppmärksamhet bättre fångad när huden blev ljusare, eller när den blev varmare, mer mättad och mer kontrastrik. I en fjärdedel av fallen ökade saliniteten genom att göra funktioner mer stereotypiskt feminina; medan 18% av tiden fick yngre ansikten en bättre skörd. Samma statistik gällde smalare ansikten.

Med andra ord är ansiktsdrag som inte överensstämmer med vissa “skönhets” -standarder som ställs av Twitters algoritm mindre benägna att få strålkastarljuset när bilderna beskärs.

Naturligtvis innebär den snabba vändningen att experimentet inte är lika rigoröst som en fullfjädrad akademisk studie – en läxa för framtida utmaningar. “För framtida företag som gör detta tror jag att mer tid skulle behövas för att sätta ihop en kvalitetssändning”, säger Kulynych.

Twitter själv har erkänt att detta bara är ett första steg. När vi meddelade utmaningen sa företagets produktchef Jutta Williams att initiativet kom med några okända, och att lärdomar skulle tillämpas för nästa evenemang.

SE: Större kvantdatorer, snabbare: Denna nya idé kan vara den snabbaste vägen till riktiga appar

Algoritmisk snedvridning duster blir till synes verkliga, och forskare kan bara hoppas att andra teknikföretag kommer att följa efter – men med vissa varningar, säger Kulynych.

“Jag menar inte att minska lagets prestationer, den här tävlingen är ett stort steg”, förklarar Kulynych. “Och problemet med algoritmisk snedvridning är mycket viktigt att ta itu med. Jag tror att företag stimuleras till att åtgärda detta problem, vilket är bra. Men faran här är att glömma allt annat.”

Det vill säga om algoritmen alls ska finnas. Vissa modeller har visat sig generera betydande skada, oavsett om det är för att de sprider felaktig information eller påverkar integriteten. I dessa fall bör frågan inte vara att ta reda på hur man fixar algoritmen – utan om algoritmen förvarar skada bara genom att existera.

Twitter ramade in sin algoritmiska bias -utmaning genom prisma “skada” snarare än “bias”; men när konceptet växer, förutser Kulynych möjligheten för vissa företag att gömma sig bakom fasaden av en partisk premie för att legitimera förekomsten av algoritmer som genom design är skadliga.

Till exempel, även om ett ansiktsigenkänningssystem ska vara helt opartiskt, utesluter det inte frågan om tekniken utgör en integritetsrisk för dem som utsätts för den.

“Det stora med bias är att det förutsätter att systemet ska existera, och om du bara fixar bias så kommer allt om systemet att bli bra”, säger Kulynych. “Det är inte en ny sak-alla har gjort etik-tvätt och rättvisa-tvätt för en tid.”

Algoritmiska bias -teorier teoretiserades som en metod som kan tjäna dem som påverkas mest av diskriminerande algoritmiska skador – och de kan vara ett kraftfullt verktyg för att göra tekniken rättvisare, så länge de inte blir ett annat företagsverktyg istället.

Big Data

Var är IBM: s hybrid moln -startplatta? Sju sätt att göra realtidsteknik verklig för din organisation Maskininlärning på kanten: TinyML blir stor Vad händer nästa för Cloudera? McDonald's vill 'demokratisera' maskininlärning för alla användare i sin verksamhet

Relaterade ämnen:

Digital Transformation CXO Internet of Things Innovation Enterprise Software Smart Cities ![]()