Kulynych fikk den største belønningen takket være sin oppdagelse at Twitters algoritme har en tendens til å bruke et “skjønnhetsfilter”.

Bilde: Bogdan Kulynych

Twitter har prøvd en metode uten sidestykke for å finne de skjulte skjevhetene i sine egne algoritmer.

Den sosiale medieplattformen har registrert eksterne forskere i en enestående konkurranse, der vinnende deltakere var de som kunne komme med de mest overbevisende bevisene som viser en urettferdig praksis som utføres av en av selskapets algoritmer.

Initiativet ble kalt “algoritmisk bias bounty-utfordring”, og ga deltakerne full tilgang til koden som ligger til grunn for Twitters bildeskjæringsalgoritme, som bestemmer hvordan bilder skal beskjæres for lett å bli sett når de kommer opp en brukers tidslinje.

SE: Pentagon sier at den nye AI -en kan se hendelser “dager i forveien”

Modellen er programmert til å estimere hva en person mest sannsynlig vil se på i et bilde – det vil si den mest fremtredende delen av bildet, og derfor er den også kjent som saliency -algoritmen. Målet med utfordringen var å finne ut om saliency -algoritmen gjør skadelige eller diskriminerende valg, med løfte om å vinne premier fra $ 500 til $ 3500.

Sikkerhets- og personverningeniørstudent Bogdan Kulynych vant toppremien. Forskeren oppdaget at algoritmen har en tendens til å bruke et “skjønnhetsfilter”: det favoriserer slankere, yngre ansikter, så vel som de med en lys eller varm hudfarge og glatt hudtekstur, og stereotypisk feminine ansiktstrekk.

“Jeg så kunngjøringen på Twitter, og den virket nær mine forskningsinteresser – jeg er for tiden doktorgradsstudent og jeg fokuserer på personvern, sikkerhet, maskinlæring og hvordan de krysser samfunnet,” Kulynych forteller ZDNet. “Jeg bestemte meg for å delta og klarte å sette opp noe på en uke.”

Det er ingen nyhet at Twitters fremtidsalgoritme er problematisk. I fjor begynte plattformens brukere å legge merke til at teknologien hadde en tendens til å velge hvite mennesker fremfor svarte når de beskjærte, samt mannlige ansikter fremfor kvinnelige ansikter. Etter å ha utført noen egne undersøkelser, innrømmet selskapet at modellen tok urettferdige valg og fjernet saltholdighetsalgoritmen helt, og lanserte i stedet en ny måte å vise standard bildesideforhold i sin helhet.

Men i stedet for å definitivt sette algoritmen bort, bestemte Twitter seg for å gjøre modellens kode tilgjengelig for forskere for å se om det kan oppstå andre skadelige metoder.

Hvis ideen minner om bug bounty -programmene som nå er normen i sikkerhetsbransjen, er det fordi konseptet er basert på akkurat det samme.

Av sikkerhetshensyn ser bug bounties at selskaper oppfordrer sikkerhetseksperter for å hjelpe dem med å identifisere sårbarheter i produktene sine før hackere kan utnytte dem til deres fordel. Og innen AI har eksperter lenge tenkt på å overføre konseptet til å oppdage forstyrrelser i algoritmer.

Twitter er det første selskapet som har forvandlet konseptet til et reelt initiativ, og ifølge Kulynych viser metoden løfte.

“Vi klarte å sette opp noe på veldig kort tid,” sier Kulynych til ZDNet. “Selvfølgelig betyr det raske tempoet at det er mulighet for en falsk positiv. Men iboende er det en god ting fordi det stimulerer deg til å overflate så mange skader som mulig, så tidlig som mulig.”

Dette står i kontrast til måten akademikere har prøvd å demonstrere algoritmisk skjevhet og skade så langt. Spesielt ved revisjon av et eksternt selskaps modeller kan denne prosessen ta måneder eller år, delvis fordi forskere ikke har tilgang til algoritmens kode. Algoritmen bias bounty challenge, derimot, er et Twitter-ledet initiativ, noe som betyr at selskapet åpnet tilgang til modellens kode for deltakere som ønsker å undersøke.

SE: Kan AI forbedre hentelinjene dine?

Viktigere var utfordringen på sosiale medier-plattformen den første virkelige testen av et konsept som så langt stort sett har eksistert i fantasien til de som studerer etisk AI. Og som med de fleste abstrakte ideer, var et av de viktigste stikkpunktene at det ikke finnes noen metodikk for algoritmiske skjevheter. I motsetning til sikkerhetsbug-bounties, som har veletablerte protokoller, regler og standarder, er det ingen beste praksis når det gjelder å oppdage forstyrrelser i AI.

Twitter har derfor produsert en industri-først, med grundig veiledning og metodikk for utfordringen deltakerne skal følge når de prøver å identifisere potensielle skader som saliency-algoritmen kan innføre-og den starter med å definere nøyaktig hva som utgjør en skade.

“I beskrivelsen av konkurransen var det en taksonomi av skader som var veldig nyttig og ganske nyansert,” sier Kulynych. “Det var enda bredere enn tradisjonelle forestillinger om skjevhet.”

Skadene som defineres av Twitter-funksjonen nedverdigelse, stereotypisering, feilgjenkjenning eller underrepresentasjon, men også omdømme, psykologisk eller økonomisk skade.

Den sosiale medieplattformen ba deretter deltakerne om å utføre en blanding av kvalitativ og kvantitativ forskning, og presentere funnene sine i en read-me-fil som beskriver resultatene deres, sammen med en GitHub-lenke som demonstrerer skaden. For å bedømme den mest overbevisende forskningen vurderte Twitter kriterier som antall berørte brukere eller sannsynligheten for at skaden oppstår.

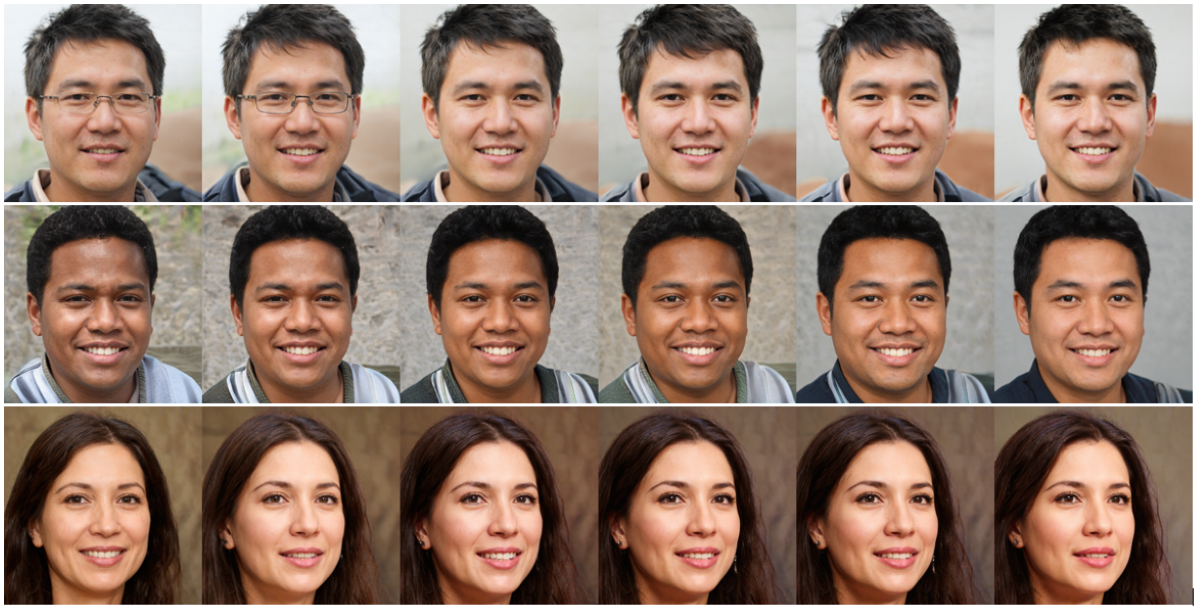

Kulynych startet med å generere et sett ansikter ved hjelp av en svært sofistikert ansiktsgenerasjonsalgoritme, og endret deretter litt på ansiktsfunksjonene for å finne ut hva som mest sannsynlig ville tiltrekke seg oppmerksomheten til algoritmen. Han endte opp med et sett ansikter som alle oppnådde “maksimal saliency” – og de så ut til å gjenspeile visse skjønnhetsstandarder som var forankret i modellen.

For eksempel, i 37% av tilfellene, ble algoritmens oppmerksomhet bedre fanget når huden ble lysere, eller når den ble varmere, mer mettet og mer kontrastrik. I en fjerdedel av tilfellene økte salien ved å gjøre funksjoner mer stereotypisk feminine; mens 18% av tiden fikk yngre ansikter en bedre avling. Den samme statistikken gjaldt for slankere ansikter.

Med andre ord er det mindre sannsynlig at ansiktstrekk som ikke er i samsvar med visse “skjønnhetsstandarder” som er satt av Twitters algoritme, får søkelyset når bildene blir beskåret.

Selvfølgelig betyr den raske snuoperasjonen at eksperimentet ikke er like strengt som et fullverdig akademisk studie – en leksjon som er lært for fremtidige utfordringer. “For fremtidige selskaper som gjør dette, tror jeg det ville trengt mer tid å sette sammen et kvalitetsinnlevering,” sier Kulynych.

Twitter har selv erkjent at dette bare er et første skritt. Da vi kunngjorde utfordringen, sa selskapets produktsjef Jutta Williams at initiativet fulgte med noen ukjente, og at læring ville bli brukt til det neste arrangementet.

SE: Større kvantemaskiner, raskere: Denne nye ideen kan være den raskeste veien til virkelige apper

Algoritmisk skjevhet dusører blir tilsynelatende virkelige, og forskere kan bare håpe at andre teknologiselskaper vil følge ledelsen – men med noen forbehold, sier Kulynych.

“Jeg mener ikke å redusere prestasjonene til laget, denne konkurransen er et stort skritt,” forklarer Kulynych. “Og problemet med algoritmisk skjevhet er veldig viktig å ta opp. Jeg tror selskaper blir incentivert til å fikse dette problemet, noe som er bra. Men faren her er å glemme alt annet.”

Det vil si om algoritmen i det hele tatt skal eksistere. Noen modeller har vist seg å gi betydelig skade, enten det er fordi de sprer feilinformasjon eller påvirker personvernet. I slike tilfeller bør spørsmålet ikke være å finne ut hvordan algoritmen fikses – men om algoritmen foreviger skade bare ved å eksistere.

Twitter ramte inn sin algoritmiske skjevhetsutfordring gjennom prismen “skader” i stedet for “skjevhet”; men etter hvert som konseptet vokser, forutser Kulynych muligheten for at noen selskaper vil gjemme seg bak fasaden til en partisk premie for å legitimere eksistensen av algoritmer som etter design er skadelige.

For eksempel, selv om et ansiktsgjenkjenningssystem bør gjøres til å være helt upartisk, utelukker det ikke spørsmålet om teknologien utgjør en personvernrisiko for de som er utsatt for det.

“Det store med skjevhet er at det på forhånd antar at systemet burde eksistere, og hvis du bare fikser skjevhet, vil alt om systemet bli bra,” sier Kulynych. “Det er ikke noe nytt-alle har holdt på med etikkvask og rettferdighetsvask en stund.”

Algoritmiske skjevheter ble teoretisert som en metode som kan tjene dem som er mest påvirket av diskriminerende algoritmiske skader – og de kan være et kraftig verktøy for å gjøre teknologien mer rettferdig, så lenge de ikke blir et annet bedriftsverktøy i stedet.

Big Data

Hvor er IBMs hybridsky -lanseringsplate? Syv måter å gjøre sanntidsteknologi reell for organisasjonen Maskinlæring på kanten: TinyML blir stor Hva skjer videre for Cloudera? McDonald's ønsker å 'demokratisere' maskinlæring for alle brukere på tvers av virksomheten

Relaterte emner:

Digital Transformation CXO Internet of Things Innovation Enterprise Software Smart Cities ![]()