Capo dell'architettura di Intel, Raja Koduri.

L'elaborazione delle reti neurali per l'intelligenza artificiale sta diventando una parte principale del carico di lavoro di ogni tipo di chip, secondo il gigante dei chip Intel, che giovedì ha svelato i dettagli dei prossimi processori durante il suo rito annuale “Giornata dell'Architettura”.

“Le reti neurali sono le nuove app”, ha affermato Raja M. Koduri, vicepresidente senior e direttore generale dell'Accelerated Computing Systems and Graphics Group di Intel, in un'intervista con ZDNet tramite i team Microsoft.

“Quello che vediamo è che ogni socket, non è CPU, GPU, IPU, tutto avrà l'accelerazione della matrice”, ha detto Koduri.

Koduri ha rilevato la neonata unità di calcolo accelerato di Intel a giugno come parte di un'ampia riorganizzazione della leadership esecutiva di Intel sotto il CEO Pat Gelsinger.

Koduri ha affermato che Intel accelerando le moltiplicazioni delle matrici nel cuore delle reti neurali, Intel avrà i chip più veloci per l'apprendimento automatico e il deep learning e qualsiasi forma di elaborazione dell'intelligenza artificiale.

Anche: Intel forma le unità di business per l'informatica accelerata e il software

“Siamo la CPU AI più veloce e la nostra Sapphire Rapids, la nostra nuova architettura del data center, è la più veloce per i carichi di lavoro AI, le nostre nuove GPU, nessuno finora, ci sono state dozzine di startup, ma nessuno ha battuto Nvidia su un benchmark di formazione, e lo abbiamo dimostrato oggi».

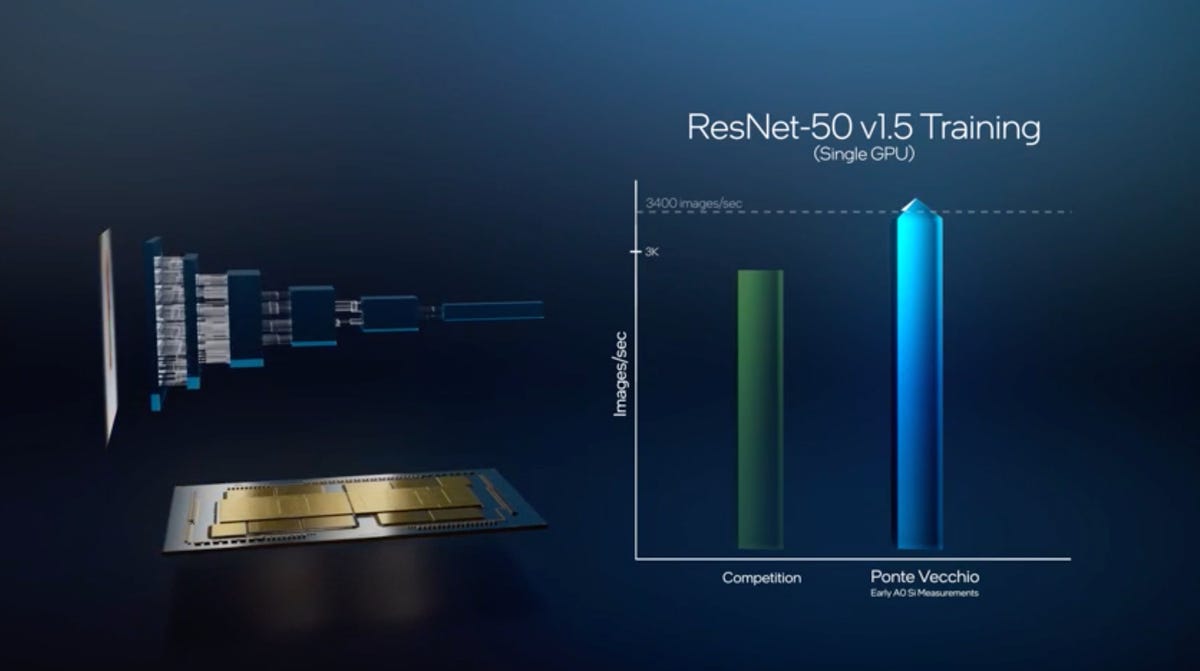

Intel ha mostrato una dimostrazione in cui la sua prossima GPU stand-alone, Ponte Vecchio, ha battuto la GPU A100 di Nvidia in un'attività di rete neurale di benchmark comune, eseguendo la rete neurale ResNet-50 per classificare le immagini in ImageNet libreria di fotografie.

Intel afferma che le versioni di pre-produzione della sua GPU Ponte Vecchio possono migliorare Nvidia in una misura standard delle prestazioni della rete neurale nelle applicazioni di deep learning, in cui la rete neurale ResNet-50 deve essere addestrata per elaborare migliaia di immagini al secondo dalla raccolta di immagini ImageNet .

Intel afferma che Ponte Vecchio può anche creare previsioni più velocemente con ResNet-50 su ImageNet rispetto a Nvidia e altri in quelli che sono noti come task inferene.

Nella dimostrazione, Intel afferma che Ponte Vecchio, in silicio di pre-produzione, è in grado di elaborare oltre 3.400 immagini in un secondo, superando i precedenti record di 3.000 immagini. Questo è per l'addestramento della rete neurale. Nell'area dell'inferenza, quando una rete neurale addestrata fa previsioni, Ponte Vecchio è in grado di fare previsioni per oltre 43.000 immagini in un solo secondo, superando quello che cita come il punteggio massimo in competizione di 40.000 immagini al secondo.

I chip Xeon di Intel tendevano a dominare il mercato dell'inferenza AI, ma Nvidia ha fatto breccia. Intel ha poca parte nella formazione delle reti neurali mentre Nvidia domina il campo con le sue GPU.

Koduri ha affermato che l'azienda intende competere con Nvidia nel bake-off annuale dei chip AI, MLPerf, in cui l'azienda rivendica i diritti di vantarsi su ResNet-50 e altre attività di benchmark.

La giornata dedicata all'architettura si concentra sulla roadmap di Intel su come la progettazione dei circuiti dei suoi chip disporrà i transistor e i blocchi funzionali sul chip, come unità logiche aritmetiche, cache e pipeline.

Un cambiamento di architettura, per Intel o per qualsiasi azienda, porta nuovi “core”, il cuore del processore che controlla come viene gestito il “datapath”, ovvero l'archiviazione e il recupero dei numeri, e il percorso di controllo, ovvero il movimento di istruzioni intorno al chip.

Molti aspetti delle nuove CPU sono stati rivelati in precedenza da Intel, incluso l'Architecture Day dello scorso anno. L'azienda deve convincere i progettisti di software a pensare e lavorare sui suoi processori anni prima che siano pronti per il lancio.

Ad esempio, il mondo sapeva che Intel avrebbe lanciato sul mercato una nuova CPU per l'elaborazione client, chiamata Alder Lake, che combina due tipi di CPU. Giovedì Intel ha annunciato che avrebbe rinominato quei due, precedentemente nomi in codice Golden Cove e Gracemont, come “Performance Core” e “Efficient Core”. Maggiori dettagli su questo da Chris Duckett di ZDNet.

Inoltre: Intel presenta l'architettura ibrida Alder Lake con core efficienti e ad alte prestazioni

Tra le nuove rivelazioni di oggi vi è che le nuove CPU utilizzeranno una struttura hardware nota come “Thread Director”. Il Thread Director prende il controllo di come i thread di esecuzione sono pianificati per essere eseguiti sul processore in un modo che si adatta a fattori come il consumo di energia, per ricevere il sistema operativo di alcuni di quel ruolo.

“L'intero modo in cui il sistema operativo interagisce con l'hardware è un'innovazione hardware.” Thread Director, afferma Intel, “fornisce telemetria di basso livello sullo stato del core e il mix di istruzioni del thread, consentendo al sistema operativo di posizionare il thread giusto sul core giusto al momento giusto”.

Thread Director, un programma hardware che assumerà alcune responsabilità per la gestione dei thread di istruzione dal sistema operativo, è stato uno dei nuovi elementi discussi durante la giornata dell'architettura di Intel.

Intel

Un'altra nuova divulgazione è come i chip utilizzeranno le tecnologie della larghezza di banda della memoria. Ad esempio, è stato rivelato che il prossimo processore per data center di Intel, Sapphire Rapids,

Alder Lake supporterà le interfacce di memoria PCIe Gen 5, DDR 5.

Intel ha rivelato che il suo prossimo processore per data center, Sapphire Rapids, la prossima era della sua famiglia Xeon, avrà alcuni aspetti prestazionali. Ad esempio, il chip eseguirà 2.048 operazioni per ciclo di clock su tipi di dati interi a 8 bit utilizzando ciò che Intel chiama AMX, o “estensioni di matrice avanzate”. Ancora una volta, l'enfasi è sui tipi di operazioni delle reti neurali. AMX è un tipo speciale di capacità di moltiplicazione di matrici che funzionerà su riquadri separati di un chip. Sapphire Rapids è composto da quattro riquadri fisici separati che hanno ciascuno CPU e acceleratore e funzioni di input/output, ma che guardano al sistema operativo come una CPU logica.

Intel afferma che Sapphire Rapids è ottimizzato per l'intelligenza artificiale tramite estensioni come AMX.

Intel

Sapphire Rapids è un esempio di come Intel consideri sempre più vantaggiosa la costruzione fisica di chip su più substrati. L'uso di più riquadri fisici, ad esempio, piuttosto che un die semiconduttore monolitico, fa uso di ciò che Intel chiama il suo bridge di interconnessione multi-die incorporato.

La presentazione di giovedì è stata caratterizzata da molte discussioni anche sulla tecnologia di processo Intel, che l'azienda ha cercato di raddrizzare dopo i passi sbagliati degli ultimi anni.

A causa dei limiti del tradizionale ridimensionamento della dimensione dei transistor secondo la Legge di Moore, ha affermato Koduri, è essenziale utilizzare altri vantaggi che Intel può apportare nella produzione di chip, incluso l'impilamento di più die all'interno di un pacchetto.

“Oggi è molto più importante per gli architetti sfruttare ogni strumento nella nostra cassetta degli attrezzi per processi e imballaggi rispetto a dieci anni fa per costruire queste cose”, ha affermato Koduri. “Prima, sì, sì, sì, il tradizionale Dennard Scaling, la legge di Moore se ne occupava, prendi la mia nuova CPU, mettila sul nuovo nodo di processo, e il gioco è fatto.”

Si riferiva all'osservazione di Robert Dennard, uno scienziato dell'IBM, negli anni '70 che come sempre più transistor sono compresso in un'area quadrata di un chip, il consumo di energia di ciascun transistor diminuisce in modo che il processore diventi più efficiente dal punto di vista energetico. Dennard Scaling è considerato effettivamente morto, proprio come la legge di Moore.

Sia Alder Lake che Sapphire Rapids saranno costruiti da Intel utilizzando quella che chiama la sua tecnologia di processo “Intel 7”. Questa è una ridenominazione di ciò che era stato chiamato “SuperFin potenziato a 10 nm”, in base al quale l'azienda aggiunge un transistor tridimensionale più efficiente, un FinFet, al processo a 10 nanometri per una maggiore efficienza nell'utilizzo dell'energia. (La designazione Intel 7 fa parte di un'ampia ridenominazione della tecnologia di processo Intel che l'azienda ha presentato a luglio.)

Allo stesso tempo, alcune parti delle parti di Intel saranno realizzate utilizzando la produzione presso Taiwan Semiconductor Manufacturing, che fornisce i concorrenti di Intel. Questo passaggio all'esternalizzazione selettiva è un'estensione dell'uso esistente da parte di Intel della produzione di transistor in outsourcing. È ciò che il CEO Gelsinger ha chiamato la strategia “IDM 2.0” di Intel.

Anche: Intel: larghezza di banda dei dati, scarsità sono le due maggiori sfide per i chip AI

Oggi, ha detto Koduri, “è un'età d'oro per gli architetti perché dobbiamo usare questi strumenti in modo molto più efficace”. Koduri faceva eco a un'affermazione fatta nel 2019 da U.C. Il professore di Berkeley David Patterson che gli architetti di computer devono compensare la fisica dei dispositivi che significa che la legge di Moore e lo scaling di Dennard non dominano più.

Naturalmente, con Nvidia che continua a innovare nelle GPU e che ora prevede di svelare la propria CPU, “Grace”, nei prossimi anni, e con startup come Cerebras Systems che costruiscono tipi di chip completamente nuovi, l'obiettivo di Intel nell'intelligenza artificiale non è semplicemente per rendere i suoi processori più compatibili con l'intelligenza artificiale. Deve essere quello di cambiare il modo in cui il campo dell'IA svolge il suo lavoro.

Alla domanda su come le varie innovazioni di Intel possano cambiare il modo in cui vengono costruite le reti neurali, Koduri ha affermato che i numerosi tipi di processori che ora proliferano in Intel e altrove dovranno cooperare molto di più e funzionare meno separatamente, per cooperare su compiti.

“I carichi di lavoro stanno decisamente andando nella direzione in cui queste cose chiamate CPU, GPU, DPU e memorie parlano tra loro molto più di quanto non stiano parlando tra loro in questo momento.”

“Parleranno tra loro, saranno in stretta collaborazione tra queste cose, per portare a termine il lavoro, di quanto tu abbia visto nei primi cinque anni di deep learning”.

Koduri si riferiva al periodo dal 2016 al 2021 come “i primi cinque anni di deep learning”, come lo vede lui. “I prossimi cinque anni avvicineranno di più tutte queste cose”.

da leggere

Etica dell'IA: vantaggi e rischi dell'intelligenza artificiale

La scala crescente dell'IA sta sollevando la posta in gioco per importanti questioni etiche .

Ulteriori informazioni

Argomenti correlati:

Hardware Digital Transformation CXO Internet of Things Innovation Enterprise Software ![]()