L'era del deep learning è iniziata nel 2006, quando Geoffrey Hinton, professore all'Università di Toronto, che è uno dei fondatori di quel particolare approccio all'intelligenza artificiale, ha teorizzato che si potrebbero ottenere risultati notevolmente migliori aggiungendo molti più neuroni artificiali a un programma di apprendimento automatico. Il “profondo” nell'apprendimento profondo si riferisce alla profondità di una rete neurale, quanti strati di dati di neuroni artificiali vengono passati attraverso.

L'intuizione di Hinton ha portato a scoperte rivoluzionarie nelle prestazioni pratiche dei programmi di intelligenza artificiale su test come l'attività di riconoscimento delle immagini ImageNet. I successivi quindici anni sono stati definiti la rivoluzione del deep learning.

Un rapporto pubblicato la scorsa settimana dalla Stanford University, in collaborazione con più istituzioni, sostiene che il predominio dell'approccio di deep learning potrebbe svanire nei prossimi anni, poiché si esauriscono le risposte alle domande difficili sulla costruzione dell'IA.

“Il recente predominio del deep learning potrebbe volgere al termine”, scrivono gli autori del rapporto. “Per continuare a fare progressi, i ricercatori di intelligenza artificiale dovranno probabilmente abbracciare metodi codificati a mano sia generali che speciali, nonché processori sempre più veloci e dati più grandi”. dice il rapporto AI100.

Inoltre: L'industria dell'IA, ossessionata dalla velocità, è restia a considerare il costo energetico nell'ultimo benchmark MLPerf

Il rapporto, noto formalmente come “The One Hundred Year Study of AI”, è la seconda puntata di quella che dovrebbe essere una serie di rapporti ogni cinque anni sullo stato della disciplina. Il rapporto è redatto da un gruppo di accademici che formano un comitato permanente e organizzano workshop i cui risultati sono riassunti nello studio.

La previsione del rapporto sul deep learning potrebbe essere prematura, per il semplice motivo che, a differenza delle epoche passate, quando l'IA era ai margini dell'informatica, la matematica che alimenta il deep learning sono ormai saldamente radicati nel mondo dell'informatica commerciale.

Centinaia di miliardi di dollari di valore di mercato sono ora attribuiti ai fondamenti del deep learning. L'apprendimento profondo, a differenza di qualsiasi approccio AI prima di esso, è ora l'istituzione.

Decenni fa, le aziende con ambiziose ricerche informatiche hanno cessato l'attività per mancanza di denaro. Thinking Machines è stata la gemma della ricerca sull'intelligenza artificiale degli anni '80 – '90. È fallita nel 1994 dopo aver bruciato 125 milioni di dollari in capitale di rischio.

L'idea che le startup di oggi vadano in bancarotta sembra molto meno probabile, piene com'è di quantità di denaro senza precedenti. Cerebras Systems, Graphcore, SambaNova Systems, hanno ottenuto miliardi, collettivamente, e hanno accesso a molti più soldi, sia nei mercati del debito che in quelli azionari.

Ancora più importante, il leader nei chip AI, Nvidia, è una centrale elettrica che vale $ 539 miliardi di valore di mercato e produce $ 10 miliardi all'anno vendendo chip per la formazione e l'inferenza di deep learning. Questa è un'azienda con un sacco di possibilità per costruire di più e vendere di più e arricchirsi ancora di più con la rivoluzione del deep learning.

Perché il business del deep learning ha così tanto successo? È perché il deep learning, indipendentemente dal fatto che porti effettivamente a qualcosa di simile all'intelligenza, ha creato un paradigma per utilizzare un'elaborazione sempre più veloce per automatizzare un sacco di programmazione informatica. Hinton, insieme ai suoi co-cospiratori, è stato premiato per aver portato avanti la scienza informatica indipendentemente da ciò che gli studiosi di intelligenza artificiale possono pensare del loro contributo all'intelligenza artificiale.

Gli autori del rapporto AI100 sostengono che il deep learning sta incontrando limiti pratici nel suo insaziabile desiderio di dati e potenza di calcolo. Gli autori scrivono,

Ma ora, negli anni 2020, questi metodi generali stanno incontrando dei limiti – calcolo disponibile, dimensioni del modello, sostenibilità, disponibilità di dati, fragilità e mancanza di semantica – che stanno iniziando a spingere i ricercatori a progettare componenti specializzati dei loro sistemi per prova a aggirarli.

Tutto ciò potrebbe essere vero, ma, ancora una volta, questa è una chiamata alle armi a cui l'industria informatica è felice di spendere miliardi per rispondere. I compiti del deep learning sono diventati l'obiettivo dei computer più potenti. L'intelligenza artificiale non è più una disciplina speciale, è il cuore dell'ingegneria informatica.

Occorrono solo quattordici secondi perché uno dei computer più veloci del pianeta, costruito da Google, venga “addestrato” automaticamente per risolvere ImageNet, secondo i risultati del benchmark all'inizio di quest'anno della suite di test MLPerf. Questa non è una misura del pensiero, di per sé, è una misura della velocità con cui un computer può trasformare l'input in output: immagini in entrata, regressione lineare in uscita.

Tutti i computer, da quando li ha concepiti Alan Turing, fanno una cosa e una cosa sola, trasformano una serie di uno e zero in una diversa serie di uno e zero. Tutto ciò che l'apprendimento profondo è, è un modo per il computer di elaborare automaticamente le regole della trasformazione piuttosto che far specificare la regola a una persona.

Quello che Google e Nvidia stanno aiutando a costruire è semplicemente il futuro di tutti i computer. Ogni programma per computer può trarre vantaggio dall'automazione di alcune delle sue trasformazioni, piuttosto che essere laboriosamente codificato da una persona.

L'approccio incredibilmente semplice che sta alla base di quell'automazione, la moltiplicazione di matrici, è sublime perché è un'operazione matematica di base. È un bersaglio facile per i produttori di computer.

Ciò significa che ogni chip sta diventando un chip di deep learning, nel senso che ogni chip è ora un chip di moltiplicazione di matrici.

“Le reti neurali sono le nuove app”, ha dichiarato di recente a ZDNet Raja M. Koduri, vicepresidente senior e direttore generale dell'Accelerated Computing Systems and Graphics Group di Intel. “Quello che vediamo è che ogni socket, non è CPU, GPU, IPU, tutto avrà un'accelerazione della matrice”, ha detto Koduri.

Anche: Etica dell'IA: vantaggi e rischi dell'intelligenza artificiale

Quando hai un martello, tutto è un chiodo. E l'industria informatica ha un martello molto grosso.

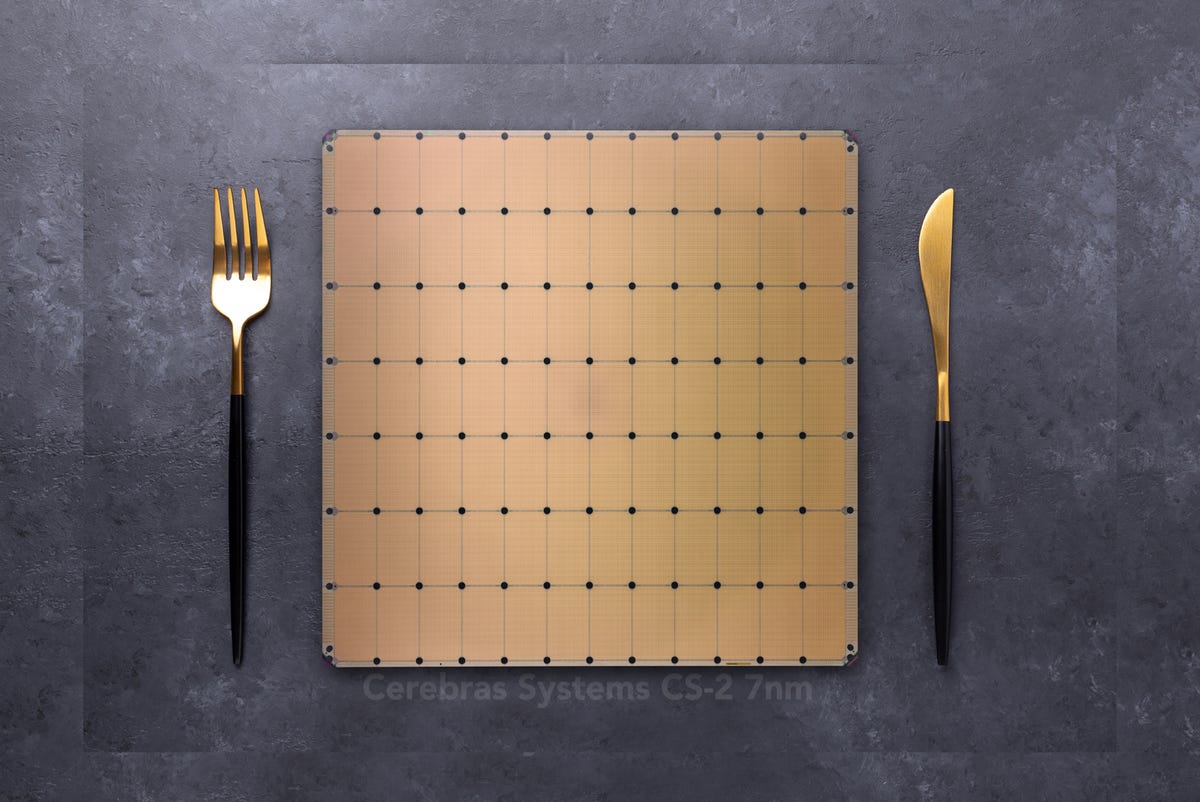

Il chip WSE di Cerebras, il più grande semiconduttore al mondo, è una macchina gigante per fare una cosa ancora e ancora, le moltiplicazioni di matrici che alimentano il deep learning.

L'industria dei computer vuole banchettare con i giganteschi motori di moltiplicazione delle matrici, come il WSE di Cerebras chip, il chip più grande al mondo, dedicato all'esecuzione di moltiplicazioni veloci in parallelo.

Cerebras Systems

Il test di riferimento MLPerf è diventato il metro di valutazione con cui le aziende acquistano computer, in base alla loro velocità di elaborazione del deep learning. La rivoluzione del deep learning è diventata l'industria del deep learning poiché ha stabilito la matematica a matrice come nuova misura del calcolo.

Gli studiosi che hanno assemblato il rapporto AI100 stanno facendo un punto sulle direzioni della ricerca. Molti studiosi sono preoccupati che l'apprendimento profondo non si sia avvicinato all'obiettivo della comprensione né del raggiungimento di un'intelligenza simile a quella umana, e non sembra che lo farà presto.

Critici del deep learning come lo psicologo della NYU Gary Marcus hanno organizzato interi seminari per esplorare un modo per fondere il deep learning con altri approcci, come il ragionamento simbolico, per trovare un modo per superare quella che sembra la natura limitata dell'approccio monotono del deep learning.

Anche: AI in sessanta secondi

La critica è elegantemente incapsulata da uno dei membri del gruppo di studio del rapporto, Melanie Mitchell del Santa Fe Institute e della Portland State University. Mitchell ha scritto in un articolo di quest'anno, intitolato “Perché l'intelligenza artificiale è più difficile di quanto pensiamo”, che il deep learning sta incontrando gravi limitazioni nonostante l'ottimismo dell'approccio. Mitchell cita come prova il fatto che gli obiettivi tanto sbandierati come l'era a lungo annunciata delle auto a guida autonoma non si sono concretizzati.

Come sostiene Mitchell, abbastanza astutamente, il deep learning sa a malapena come parlare di intelligenza, tanto meno replicarla:

È chiaro che per fare e valutare i progressi nell'intelligenza artificiale in modo più efficace, avremo bisogno di sviluppare un vocabolario migliore per parlare di ciò che le macchine possono fare. E più in generale, avremo bisogno di una migliore comprensione scientifica dell'intelligenza come si manifesta in diversi sistemi in natura. Ciò richiederà ai ricercatori di intelligenza artificiale di impegnarsi più profondamente con altre discipline scientifiche che studiano l'intelligenza.

Tutto ciò è senza dubbio vero, eppure l'industria informatica ama l'incrementalismo. Sessant'anni di produzione di circuiti integrati a velocità doppia e doppia hanno reso il mondo dei computer agganciato a cose che possono essere facilmente replicate. L'apprendimento profondo, basato su un mare di moltiplicazioni di matrici, ancora una volta, è un obiettivo sublime, un compito straordinariamente semplice da eseguire sempre più velocemente.

Finché le aziende informatiche potranno continuare a sfornare miglioramenti nell'accelerazione della matrice, l'industria del deep learning, in quanto mainstream dell'informatica, avrà una capacità di resistenza con cui fare i conti.

(Se desideri saperne di più sul rapporto AI100, Stanford sta tenendo una discussione virtuale oggi dalle 9:00 alle 10:00, ora del Pacifico, a cui puoi accedere dalla pagina Web dell'evento.)

Argomenti correlati:

Hardware Digital Transformation CXO Internet of Things Innovation Enterprise Software ![]()