Kulynych verdiende de hoogste beloning dankzij zijn ontdekking dat het algoritme van Twitter de neiging heeft om een ”schoonheidsfilter” toe te passen.

Afbeelding: Bogdan Kulynych

Twitter heeft een ongekende methode uitgeprobeerd om de verborgen vooroordelen in zijn eigen algoritmen te vinden.

Het socialemediaplatform heeft externe onderzoekers ingeschreven voor een unieke wedstrijd, waarbij de winnende deelnemers degenen waren die met het meest overtuigende bewijs konden komen dat een oneerlijke praktijk aantoont die wordt uitgevoerd door een van de algoritmen van het bedrijf.

Dit initiatief wordt de “algoritmische bias bounty-uitdaging” genoemd en gaf deelnemers volledige toegang tot de code die ten grondslag ligt aan het algoritme voor het bijsnijden van afbeeldingen van Twitter, dat bepaalt hoe afbeeldingen moeten worden bijgesneden om gemakkelijk te kunnen worden bekeken wanneer ze op de tijdlijn van een gebruiker.

ZIE: Het Pentagon zegt dat de nieuwe AI gebeurtenissen 'dagen van tevoren' kan zien

Het model is geprogrammeerd om in te schatten wat een persoon het meest waarschijnlijk op een foto wil zien – dat wil zeggen, het meest opvallende deel van de afbeelding, daarom staat het ook bekend als het saliency-algoritme. Het doel van de uitdaging was om erachter te komen of het saliency-algoritme schadelijke of discriminerende keuzes maakt, met de belofte om prijzen te winnen variërend van $ 500 tot $ 3.500.

Beveiligings- en privacy-engineeringstudent Bogdan Kulynych sleepte de hoofdprijs in de wacht. De onderzoeker ontdekte dat het algoritme de neiging heeft om een ”schoonheidsfilter” toe te passen: het geeft de voorkeur aan slankere, jongere gezichten, maar ook aan die met een lichte of warme huidskleur en gladde huidtextuur, en stereotiepe vrouwelijke gelaatstrekken.

“Ik zag de aankondiging op Twitter en het leek dicht bij mijn onderzoeksinteresses – ik ben momenteel een doctoraatsstudent en ik richt me op privacy, beveiliging, machine learning en hoe deze interageren met de samenleving,” Kulynych vertelt ZDNet. “Ik besloot mee te doen en slaagde erin om in een week tijd iets op te zetten.”

Het is geen nieuws dat het opvallende algoritme van Twitter problematisch is. Vorig jaar begonnen de gebruikers van het platform te merken dat de technologie de neiging had om blanke mensen te verkiezen boven zwarte mensen bij het bijsnijden, evenals mannelijke gezichten boven vrouwelijke gezichten. Na zelf wat onderzoek te hebben gedaan, gaf het bedrijf toe dat het model oneerlijke keuzes heeft gemaakt en het opvallende algoritme helemaal heeft verwijderd, en in plaats daarvan een nieuwe manier heeft gelanceerd om standaardbeeldverhouding-foto's volledig weer te geven.

Maar in plaats van het algoritme definitief opzij te zetten, besloot Twitter de code van het model beschikbaar te stellen aan onderzoekers om te zien of er andere schadelijke praktijken zouden kunnen ontstaan.

Als het idee doet denken aan de bug bounty-programma's die nu de norm zijn in de beveiligingsindustrie, dan komt dat omdat het concept op precies hetzelfde is gebaseerd.

Op het gebied van beveiliging zien we bij bug bounties dat bedrijven een beroep doen op beveiligingsexperts om hen te helpen kwetsbaarheden in hun producten te identificeren voordat hackers deze in hun voordeel kunnen misbruiken. En op het gebied van AI hebben experts lang nagedacht over het omzetten van het concept naar het detecteren van vooroordelen in algoritmen.

Twitter is het eerste bedrijf dat het concept heeft omgezet in een echt initiatief, en volgens Kulynych is de methode veelbelovend.

“We zijn erin geslaagd om in zeer korte tijd iets op te zetten”, vertelt Kulynych aan ZDNet. “Natuurlijk betekent het hoge tempo dat er een kans is op een vals positief resultaat. Maar inherent is het een goede zaak omdat het je stimuleert om zo vroeg mogelijk zoveel mogelijk schade aan de oppervlakte te brengen.”

Dit staat in contrast met de manier waarop academici tot nu toe hebben geprobeerd om algoritmische vooringenomenheid en schade aan te tonen. Vooral bij het controleren van modellen van een extern bedrijf kan dit proces maanden of zelfs jaren duren, mede omdat onderzoekers geen toegang hebben tot de code van het algoritme. De bounty-uitdaging van het algoritme vooringenomenheid is daarentegen een door Twitter geleid initiatief, wat betekent dat het bedrijf toegang tot de code van het model opende voor deelnemers die het wilden onderzoeken.

ZIE: Kan AI uw ophaallijnen verbeteren?

Belangrijk is dat de uitdaging van het sociale-mediaplatform de eerste real-life test was van een concept dat tot nu toe grotendeels bestond in de verbeelding van degenen die ethische AI bestudeerden. En zoals met de meeste abstracte ideeën, was een van de belangrijkste knelpunten dat er geen methodologie bestaat voor algoritmische vooringenomenheidspremies. In tegenstelling tot premies voor beveiligingsbugs, die gevestigde protocollen, regels en standaarden hebben, zijn er geen best practices als het gaat om het detecteren van vooringenomenheid in AI.

Twitter heeft daarom een primeur in de branche geproduceerd, met diepgaande begeleiding en methodologie voor de uitdaging die deelnemers moeten volgen bij het identificeren van mogelijke schade die het saliency-algoritme zou kunnen introduceren – en het begint met het precies definiëren van wat een schade is.

“In de beschrijving van de wedstrijd was er een taxonomie van schade die erg nuttig en nogal genuanceerd was”, zegt Kulynych. “Het was zelfs breder dan de traditionele noties van vooringenomenheid.”

De schade die door Twitter wordt gedefinieerd, omvat minachting, stereotypering, verkeerde herkenning of ondervertegenwoordiging, maar ook reputatieschade, psychologische of zelfs economische schade.

Het socialemediaplatform vroeg de deelnemers vervolgens om een mix van kwalitatief en kwantitatief onderzoek uit te voeren en hun bevindingen te presenteren in een read-me-bestand waarin hun resultaten werden beschreven, samen met een GitHub-link die de schade aantoont. Om het meest overtuigende onderzoek te beoordelen, heeft Twitter rekening gehouden met criteria zoals het aantal getroffen gebruikers of de kans dat de schade zich voordoet.

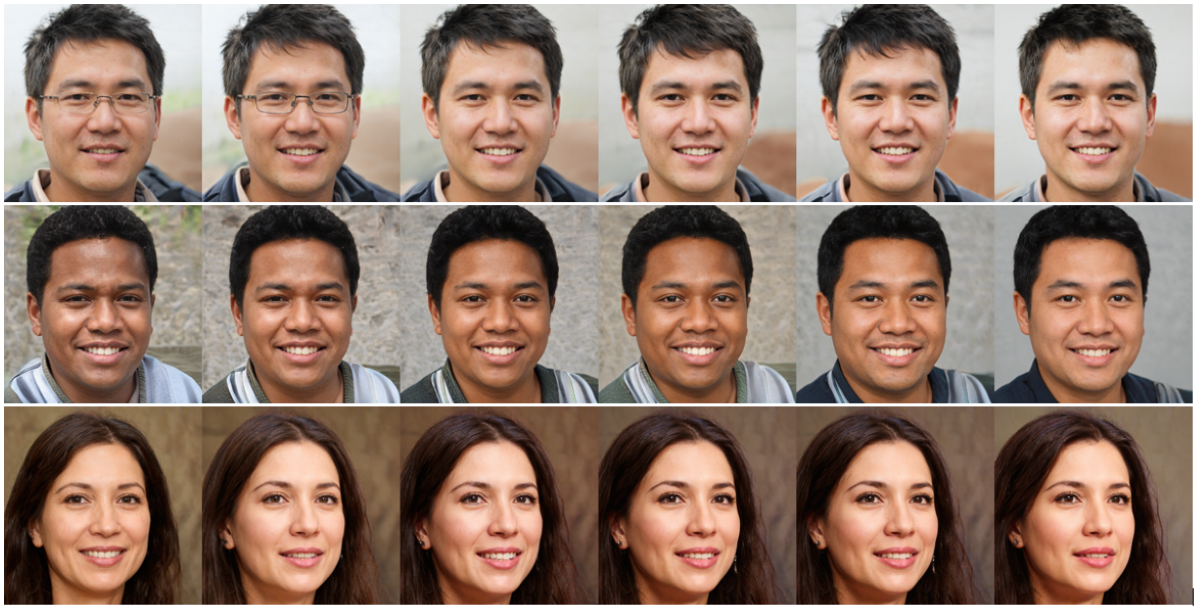

Kulynych begon met het genereren van een reeks gezichten met behulp van een zeer geavanceerd algoritme voor het genereren van gezichten, en wijzigde vervolgens enkele gelaatstrekken enigszins om erachter te komen wat het meest waarschijnlijk de aandacht van het saliency-algoritme zou trekken. Hij eindigde met een reeks gezichten die allemaal “maximale opvallendheid” bereikten – en ze leken bepaalde schoonheidsnormen te weerspiegelen die in het model waren verankerd.

In 37% van de gevallen werd de aandacht van het algoritme bijvoorbeeld beter getrokken bij het lichter maken van de huid, of bij het warmer, meer verzadigd en contrastrijker maken. In een kwart van de gevallen nam de opvallendheid toe door kenmerken meer stereotiep vrouwelijk te maken; terwijl 18% van de tijd jongere gezichten een betere oogst kregen. Dezelfde statistiek gold voor slankere gezichten.

Met andere woorden, gelaatstrekken die niet voldoen aan bepaalde “schoonheids”-normen die zijn ingesteld door het algoritme van Twitter, zullen minder snel in de schijnwerpers komen te staan wanneer afbeeldingen worden bijgesneden.

Natuurlijk betekent de snelle doorlooptijd dat het experiment niet zo rigoureus is als een volwaardige academische studie – een les die is geleerd voor toekomstige uitdagingen. “Voor toekomstige bedrijven die dit doen, denk ik dat er meer tijd nodig is om een kwaliteitsinzending samen te stellen”, zegt Kulynych.

Twitter heeft zelf erkend dat dit slechts een eerste stap is. Bij de aankondiging van de uitdaging zei de productmanager van het bedrijf, Jutta Williams, dat het initiatief met een aantal onbekenden kwam en dat de lessen zouden worden toegepast voor het volgende evenement.

ZIE: Grotere kwantumcomputers, sneller: dit nieuwe idee zou de snelste route naar apps in de echte wereld kunnen zijn

Algoritmische vooringenomenheid premies lijken daarom echt te worden, en onderzoekers kunnen alleen maar hopen dat andere technologiebedrijven het voorbeeld zullen volgen, maar met enkele kanttekeningen, zegt Kulynych.

“Het is niet mijn bedoeling om de prestaties van het team te verminderen, deze wedstrijd is een enorme stap”, legt Kulynych uit. “En het probleem van algoritmische vooringenomenheid is erg belangrijk om aan te pakken. Ik denk dat bedrijven worden gestimuleerd om dit probleem op te lossen, wat goed is. Maar het gevaar hier is om al het andere te vergeten.”

Dat wil zeggen, of het algoritme überhaupt zou moeten bestaan. Van sommige modellen is vastgesteld dat ze aanzienlijke schade veroorzaken, of het nu is omdat ze verkeerde informatie verspreiden of de privacy schaden. In die gevallen zou de vraag niet moeten zijn om erachter te komen hoe het algoritme kan worden gerepareerd, maar of het algoritme schade in stand houdt door alleen maar te bestaan.

Twitter heeft zijn algoritmische bias-bounty-uitdaging gekaderd door het prisma van “schade” in plaats van “bias”; maar naarmate het concept groeit, voorziet Kulynych de mogelijkheid dat sommige bedrijven zich verschuilen achter de façade van een vooringenomen premie om het bestaan van algoritmen te legitimeren die, door hun ontwerp, schadelijk zijn.

Zelfs als een gezichtsherkenningssysteem bijvoorbeeld volledig onbevooroordeeld zou moeten worden gemaakt, sluit het de vraag niet uit of de technologie een privacyrisico vormt voor degenen die eraan worden onderworpen.

“Het belangrijkste van vooringenomenheid is dat het veronderstelt dat het systeem zou moeten bestaan, en als je alleen vooroordelen oplost, dan komt alles aan het systeem in orde”, zegt Kulynych. “Dat is niet nieuw – iedereen doet al een tijdje ethiek-wassing en eerlijkheid-wassing.”

Algoritmische vooringenomenheidspremies werden getheoretiseerd als een methode die degenen die het meest worden getroffen door discriminerende algoritmische schade zou kunnen dienen – en ze zouden een krachtig hulpmiddel kunnen zijn om technologie eerlijker te maken, zolang ze niet in plaats daarvan een ander bedrijfsinstrument worden.

Big Data

Waar is IBM's hybride cloud-lanceerplatform? Zeven manieren om realtime technologie echt te maken voor uw organisatie Machine learning aan de edge: TinyML wordt groot Wat biedt Cloudera nu? McDonald's wil machine learning 'democratiseren' voor alle gebruikers in al haar activiteiten

gerelateerde onderwerpen:

digitale transformatie CXO Internet of Things Innovatie Enterprise Software Smart Cities ![]()