![]()

Immagine: Apple

Venerdì, Apple ha rivelato i piani per affrontare il problema degli abusi sui minori sui suoi sistemi operativi negli Stati Uniti tramite aggiornamenti a iOS 15, iPadOS 15, watchOS 8 e macOS Monterey.

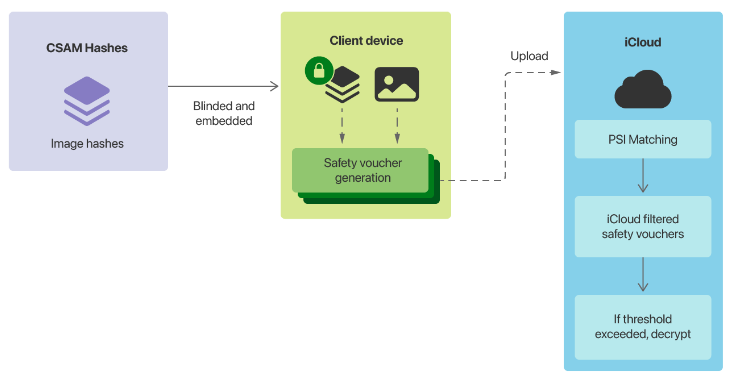

La componente più controversa dei piani di Cupertino è il suo sistema di rilevamento di materiale pedopornografico (CSAM). Coinvolgerà i dispositivi Apple che abbinano le immagini sul dispositivo a un elenco di hash di immagini CSAM noti forniti dal National Center for Missing and Exploited Children (NCMEC) degli Stati Uniti e da altre organizzazioni per la sicurezza dei bambini prima che un'immagine venga archiviata in iCloud.

“Prima che un'immagine venga archiviata in Foto di iCloud, viene eseguito un processo di corrispondenza sul dispositivo per quell'immagine rispetto agli hash CSAM noti. Questo processo di corrispondenza è alimentato da una tecnologia crittografica chiamata intersezione di set privati, che determina se esiste una corrispondenza senza rivelare il risultato”, ha detto Apple.

“Il dispositivo crea un voucher di sicurezza crittografico che codifica il risultato della partita insieme a dati crittografati aggiuntivi sull'immagine. Questo voucher viene caricato su iCloud Photos insieme all'immagine.”

Una volta raggiunta una soglia non dichiarata, Apple esaminerà manualmente i voucher e esaminerà i metadati. Se l'azienda determina che è CSAM, l'account verrà disabilitato e verrà inviato un rapporto a NCMEC. Cupertino ha affermato che gli utenti potranno presentare ricorso per riattivare un account.

Apple afferma che la sua soglia garantirà “meno di una possibilità su un trilione all'anno di segnalare erroneamente un determinato account”.

L'altra coppia di funzionalità annunciate da Apple venerdì prevedeva che Siri e la ricerca fornissero avvisi quando un utente cerca contenuti relativi a CSAM e l'utilizzo dell'apprendimento automatico per avvisare i bambini quando stanno per visualizzare foto sessualmente esplicite in iMessage.

“Quando si riceve questo tipo di contenuto, la foto sarà sfocata e il bambino sarà avvisato, presentato con risorse utili e rassicurato che va bene se non vuole visualizzare questa foto. Come ulteriore precauzione, il bambino può anche essere ha detto che, per assicurarsi che siano al sicuro, i loro genitori riceveranno un messaggio se lo visualizzano”, ha detto Apple.

“Protezioni simili sono disponibili se un bambino tenta di inviare foto sessualmente esplicite. Il bambino verrà avvisato prima dell'invio della foto e i genitori possono ricevere un messaggio se il bambino sceglie di inviarlo”.

Immagine: Apple

Piani etichettati come backdoor

I piani di Apple hanno attirato critiche durante il fine settimana, con Electronic Frontier Foundation che ha etichettato le funzionalità come una backdoor.

“Se hai passato del tempo a seguire le Crypto Wars, sai cosa significa: Apple sta pianificando di creare una backdoor nel suo sistema di archiviazione dati e nel suo sistema di messaggistica”, ha scritto l'EFF.

“Apple può spiegare a lungo come la sua implementazione tecnica conserverà la privacy e la sicurezza nella sua backdoor proposta, ma alla fine, anche una backdoor accuratamente documentata, attentamente ponderata e con un ambito ristretto è ancora una backdoor.”

EFF ha avvertito che una volta installato il sistema CSAM, il passaggio successivo sarebbe stato cambiare il sistema per cercare altri tipi di contenuto.

“Non è un pendio scivoloso; è un sistema completamente costruito che aspetta solo che la pressione esterna faccia il minimo cambiamento”, ha detto.

“I casi di abuso sono facili da immaginare: i governi che vietano l'omosessualità potrebbero richiedere che il classificatore sia addestrato a limitare i contenuti LGBTQ+ apparenti, oppure un regime autoritario potrebbe richiedere che il classificatore sia in grado di individuare immagini satiriche popolari o volantini di protesta”.

L'EFF ha aggiunto che con iMessage per avviare la scansione delle immagini inviate e ricevute, la piattaforma di comunicazione non era più crittografata end-to-end.

“Apple e i suoi sostenitori potrebbero obiettare che la scansione prima o dopo che un messaggio è crittografato o decifrato mantiene intatta la promessa 'end-to-end', ma sarebbe una manovra semantica per coprire un cambiamento tettonico nella posizione dell'azienda verso una crittografia forte, “, ha detto la fondazione.

Il capo di WhatsApp Will Cathcart ha affermato che la piattaforma di proprietà di Facebook non adotterà l'approccio di Apple e si affiderà invece al materiale di segnalazione degli utenti.

“Si tratta di un sistema di sorveglianza costruito e gestito da Apple che potrebbe essere facilmente utilizzato per scansionare contenuti privati alla ricerca di qualsiasi cosa loro o un governo decidano di voler controllare. I paesi in cui vengono venduti gli iPhone avranno definizioni diverse su ciò che è accettabile”, ha detto Cathcart.

Il capo di WhatsApp ha chiesto come funzionerebbe il sistema in Cina e cosa sarebbe successo una volta che una squadra di spyware avesse scoperto come sfruttare il sistema.

WhatsApp esegue la scansione di immagini non crittografate, come foto del profilo e di gruppo, alla ricerca di materiale pedopornografico.

“Disponiamo di una tecnologia aggiuntiva per rilevare nuove CEI sconosciute all'interno di queste informazioni non crittografate. Utilizziamo anche classificatori di apprendimento automatico sia per scansionare superfici di testo, come profili utente e descrizioni di gruppi, sia per valutare informazioni e comportamenti di gruppo per sospetta condivisione di CEI”, la società disse.

L'ex CSO di Facebook Alex Stamos si è detto felice di vedere Apple assumersi la responsabilità dell'impatto della sua piattaforma, ma ha messo in dubbio l'approccio.

“Entrambi hanno spostato la palla in avanti tecnicamente, danneggiando lo sforzo complessivo per trovare un equilibrio politico”, ha detto Stamos.

“Uno dei problemi di base con l'approccio di Apple è che sembrano disperati per evitare di costruire una vera funzione di fiducia e sicurezza per i loro prodotti di comunicazione. Non esiste un meccanismo per segnalare spam, minacce di morte, incitamento all'odio, NCII o qualsiasi altro tipo di abuso su iMessage.”

Invece della sua “scansione non consensuale delle foto locali e della creazione di ML lato client che non forniranno molta prevenzione reale dei danni”, Stamos ha affermato che avrebbe preferito se Apple avesse avuto rapporti solidi in iMessage, con un team per la sicurezza dei bambini. per indagare sui report e ha lentamente implementato l'apprendimento automatico lato client. L'ex capo della sicurezza di Facebook ha affermato di temere che Apple avesse avvelenato il pozzo sui classificatori lato client.

“Anche se la Repubblica popolare cinese è stata spesso invocata, mi aspetto che la legge sulla sicurezza online del Regno Unito e la legge sui servizi digitali dell'UE siano state molto più importanti per le considerazioni di Apple”, ha affermato.

L'informatore Edward Snowden ha accusato Apple di aver implementato la sorveglianza di massa in tutto il mondo.

“Non commettere errori: se possono cercare porno per bambini oggi, possono cercare qualsiasi cosa domani”, ha detto.

“Hanno trasformato un trilione di dollari di dispositivi in iNarcs—*senza chiedere.*”

Venerdì tardi, 9to5Mac ha riferito di un memo interno di Apple che conteneva una nota dell'NCMEC.

“Sappiamo che i giorni a venire saranno pieni delle voci stridenti della minoranza”, secondo quanto riferito dall'NCMEC.

Copertura correlata

Perché sembra che Apple faccia così tante cattive scelte di design?Perché potresti non voler acquistare un nuovo iPhone fino al 2022Smetti di ignorare questo avviso iPhoneApple FYQ3 schiaccia le aspettative: $ 81,4 miliardi di entrate, $ 1,30 EPS; share sag

Argomenti correlati:

Apple Security TV Data Management CXO Data Center